Wan2.1 FLF2V 14B

紹介 :

Wan2.1-FLF2V-14Bは、ビデオ生成分野の進歩を促進することを目的とした、オープンソースの大規模ビデオ生成モデルです。このモデルは、複数のベンチマークテストで優れた性能を示しており、消費者向けGPUに対応し、480Pおよび720Pのビデオを効率的に生成できます。テキストからビデオ、画像からビデオなど、複数のタスクで優れた性能を発揮し、強力なビジュアルテキスト生成能力を備えており、様々な現実的なアプリケーションシナリオに適しています。

ターゲットユーザー :

「この製品は、高品質のビデオコンテンツの生成を必要とするビデオクリエーター、開発者、研究者、特にそれらの人々に適しています。その強力な機能と互換性により、教育、エンターテインメント、広告など、多くの業界で広く利用されています。」

使用シナリオ

Wan2.1を使用して、ソーシャルメディアコンテンツ作成用の短編ビデオを生成します。

画像をビデオに変換して、広告やマーケティングビデオ制作に使用します。

新しいアプリケーションを開発し、ビデオ生成機能を使用してユーザーエクスペリエンスを向上させます。

製品特徴

既存のモデルを凌駕し、最新のSOTA性能を提供します。

消費者向けGPUで動作し、優れた互換性を備えています。

テキストからビデオ、画像からビデオなど、さまざまなタスクを処理できます。

中国語と英語のテキスト生成に対応し、実用的な柔軟性を向上させます。

Wan-VAEを使用して効率的なエンコードとデコードを行い、時間情報を維持します。

さまざまなツールやプラットフォームに統合されており、使用と統合が容易です。

使用チュートリアル

モデルリポジトリのクローン作成:git clone https://github.com/Wan-Video/Wan2.1.git

依存関係のインストール:pip install -r requirements.txt

モデルウェイトのダウンロード:huggingface-cli または modelscope-cli を使用してモデルをダウンロードします。

テキストからビデオへの生成を実行:生成コマンドを使用し、パラメーターとプロンプトを指定します。

必要に応じてモデルパラメーターと生成オプションを調整して、ビデオ品質を最適化します。

おすすめAI製品

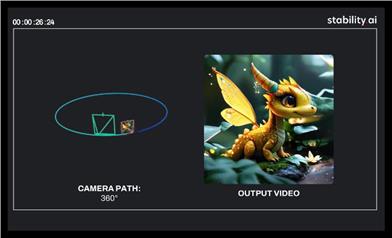

Stable Virtual Camera

Stable Virtual Cameraは、Stability AIが開発した13億パラメーターの汎用拡散モデルであり、Transformer画像からビデオへの変換モデルです。その重要性は、新しいビュー合成(NVS)に技術的なサポートを提供することであり、入力ビューとターゲットカメラに基づいて、3D整合性のある新しいシーンビューを生成できます。主な利点としては、ターゲットカメラの軌跡を自由に指定でき、大きな視点の変化と時間的に滑らかなサンプルを生成でき、追加のニューラル放射場(NeRF)蒸留なしで高い整合性を維持でき、さらに最長30秒の高品質でシームレスなループビデオを生成できることが挙げられます。このモデルは、研究および非商業目的でのみ無料で使用でき、研究者や非商業クリエイターに革新的な画像からビデオへの変換ソリューションを提供することを目的としています。

ビデオ アップデート

51.9K

ロングコンテキスト最適化(LCT)

ロングコンテキスト最適化(LCT)は、現在の単一生成能力と現実のナラティブビデオ制作とのギャップを解消することを目的としています。この技術は、データ駆動型のアプローチを使用してシーンレベルの一貫性を直接学習し、インタラクティブなマルチカメラ開発と合成生成をサポートしており、ビデオ制作のあらゆる側面に適用できます。

ビデオ アップデート

47.5K