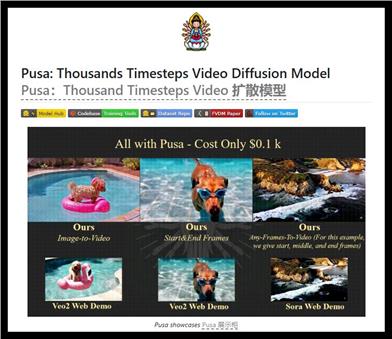

Pusa

紹介 :

Pusaはフレームレベルのノイズ制御によって動画拡散モデリングに革新的な手法を取り入れ、高品質な動画生成を実現します。テキストから動画、画像から動画など、様々な動画生成タスクに適用可能です。優れたモーションの忠実度と効率的なトレーニングプロセスにより、ユーザーが容易に動画生成タスクを実行できるオープンソースのソリューションを提供します。

ターゲットユーザー :

「Pusaは、高度な動画生成技術を利用して高品質なビジュアルコンテンツを作成したい、動画制作者、デジタルアーティスト、研究者にとって最適です。オープンソースであるため、ユーザーは自身のニーズに合わせてカスタマイズおよび拡張できます。」

使用シナリオ

テキストプロンプトによる動画生成、例:「人がバスケットボールをしている」と入力すると、関連する動画が生成されます。

ユーザーが提供した画像を動的な動画に変換し、ソーシャルメディアコンテンツの作成に使用します。

商業広告用の短編動画を作成し、シームレスループと動画トランジション効果を使用して効果を高めます。

製品特徴

テキストから動画の生成に対応:ユーザーはテキストプロンプトを入力して、対応する動画コンテンツを生成できます。

画像から動画への変換:ユーザーは静止画を動的な動画に変換し、視覚的な表現力を高めることができます。

フレーム補間機能:補間技術により動画フレームを滑らかにし、視聴体験を向上させます。

シームレスループ生成:ループ再生可能な動画を作成でき、短編動画コンテンツに最適です。

動画トランジション効果:動画間のトランジション効果に対応し、動画制作の専門性を高めます。

拡張動画生成:より長い動画の生成に対応し、様々なユーザーニーズに対応します。

高効率:トレーニングにはわずか0.1k H800 GPU時間しかかからず、コストが低いです。

完全なオープンソースリリース:完全なコードリポジトリと詳細なドキュメントを提供し、ユーザーによる二次開発を容易にします。

使用チュートリアル

Pusaモデルをインストールするには、Gitでコードリポジトリをクローンし、依存関係をインストールします。

モデルの重みをダウンロードします。Hugging Faceなどのソースから必要なファイルを取得します。

テキストから動画を生成するコマンドを実行し、モデルパスとプロンプト情報を提供します。

最適な効果を得るために、さまざまな条件位置を試します。

複数の画像を処理する場合は、各画像に対応するテキストプロンプトファイルを用意してください。

おすすめAI製品

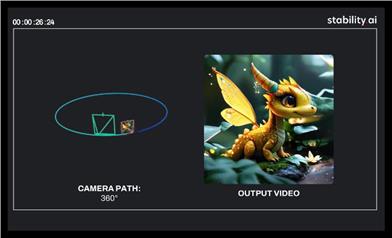

Stable Virtual Camera

Stable Virtual Cameraは、Stability AIが開発した13億パラメーターの汎用拡散モデルであり、Transformer画像からビデオへの変換モデルです。その重要性は、新しいビュー合成(NVS)に技術的なサポートを提供することであり、入力ビューとターゲットカメラに基づいて、3D整合性のある新しいシーンビューを生成できます。主な利点としては、ターゲットカメラの軌跡を自由に指定でき、大きな視点の変化と時間的に滑らかなサンプルを生成でき、追加のニューラル放射場(NeRF)蒸留なしで高い整合性を維持でき、さらに最長30秒の高品質でシームレスなループビデオを生成できることが挙げられます。このモデルは、研究および非商業目的でのみ無料で使用でき、研究者や非商業クリエイターに革新的な画像からビデオへの変換ソリューションを提供することを目的としています。

ビデオ アップデート

51.6K

ロングコンテキスト最適化(LCT)

ロングコンテキスト最適化(LCT)は、現在の単一生成能力と現実のナラティブビデオ制作とのギャップを解消することを目的としています。この技術は、データ駆動型のアプローチを使用してシーンレベルの一貫性を直接学習し、インタラクティブなマルチカメラ開発と合成生成をサポートしており、ビデオ制作のあらゆる側面に適用できます。

ビデオ アップデート

46.6K