EXAONE 3.5 7.8B Instruct AWQ

EXAONE 3.5は、LG AI Researchが開発した一連のインストラクションチューニング済みのバイリンガル(英語と韓国語)生成モデルであり、パラメータ数は2.4Bから32Bです。これらのモデルは最大32Kトークンのロングコンテキスト処理に対応し、現実世界のユースケースとロングコンテキスト理解において最先端の性能を発揮します。また、最近リリースされた同規模のモデルと比較して、一般的な領域においても競争力を維持しています。EXAONE 3.5モデルには、1)小型またはリソースの限られたデバイスへの展開に最適化された2.4Bモデル、2)前世代モデルと同等のサイズながら性能が向上した7.8Bモデル、3)強力な性能を提供する32Bモデルが含まれています。

AIモデル

45.8K

Llama 3 Patronus Lynx 70B Instruct Q4 K M GGUF

PatronusAI/Llama-3-Patronus-Lynx-70B-Instruct-Q4_K_M-GGUFは、70Bパラメータの大規模量子化言語モデルです。4ビット量子化技術を用いてモデルサイズを削減し、推論効率を向上させています。PatronusAIシリーズに属し、Transformersライブラリを基盤として構築されており、高性能な自然言語処理を必要とするアプリケーションシナリオに適しています。モデルはcc-by-nc-4.0ライセンスに従い、非営利目的での使用と共有が可能です。

AIモデル

45.3K

Llama 3 Patronus Lynx 8B V1.1 Instruct Q8 GGUF

PatronusAI/Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUFは、Llamaモデルに基づく量子化バージョンで、対話と幻覚検出のために設計されています。このモデルはGGUF形式を使用し、8.03億のパラメータを持ち、大規模言語モデルに分類されます。その重要性は、高品質な対話生成と幻觉検出能力を提供しつつ、モデルの高効率動作を維持できる点にあります。このモデルはTransformersライブラリとGGUFテクノロジーに基づいて構築されており、高性能な対話システムとコンテンツ生成が必要なアプリケーションシナリオに適しています。

チャットボット

47.5K

EXAONE 3.5 2.4B Instruct AWQ

EXAONE-3.5-2.4B-Instruct-AWQは、LG AI Researchが開発した一連のバイリンガル(英語と韓国語)指示微調整済み生成モデルであり、パラメーター数は2.4Bから32Bです。これらのモデルは最大32Kトークンのロングコンテキスト処理に対応し、現実世界のユースケースとロングコンテキスト理解において最先端の性能を示すと同時に、最近公開された同規模のモデルと比較して、汎用領域において競争力を維持しています。このモデルは小型またはリソースの限られたデバイスへの配置向けに最適化されており、AWQ量子化技術を採用することで、4ビットグループ重み量子化(W4A16g128)を実現しています。

AIモデル

44.2K

Llama Lynx 70b 4bit 量子化

Llama-Lynx-70b-4bit-量子化は、PatronusAIが開発した70億パラメータの大規模テキスト生成モデルです。4ビット量子化処理が施されており、モデルサイズと推論速度の最適化を実現しています。Hugging FaceのTransformersライブラリに基づいて構築されており、多言語に対応し、特に対話生成とテキスト生成において優れた性能を発揮します。高い性能を維持しながらモデルのストレージと計算ニーズを削減できるため、リソースに制約のある環境でも強力なAIモデルを展開できます。

AIモデル

45.8K

EXAONE 3.5 7.8B Instruct

EXAONE-3.5-7.8B-Instructは、LG AI Researchが開発した、2.4Bから32Bのパラメータを持つ一連の指示微調整済みバイリンガル(英語と韓国語)生成モデルです。これらのモデルは最大32Kトークンのロングコンテキスト処理をサポートし、現実世界のユースケースやロングコンテキスト理解において最先端の性能を示すとともに、最近リリースされた同規模のモデルと比較して、汎用領域において競争力を維持しています。

AIモデル

47.5K

EXAONE 3.5 2.4B Instruct

EXAONE-3.5-2.4B-Instructは、LG AI Researchが開発した一連のバイリンガル(英語と韓国語)命令微調整済み生成モデルで、パラメータ数は2.4Bから32Bです。これらのモデルは最大32Kトークンの長いコンテキスト処理をサポートし、現実世界のユースケースと長いコンテキストの理解において最先端の性能を示すと同時に、最近発表された同規模のモデルと比較して一般的な分野においても競争力を維持しています。このモデルは、自動翻訳、テキスト要約、対話システムなど、長文処理と多言語対応が必要なシナリオに特に適しています。

翻訳

45.3K

EXAONE 3.5 7.8B Instruct GGUF

EXAONE 3.5は、LG AI Researchが開発した一連のバイリンガル(英語と韓国語)命令微調整済み生成モデルであり、パラメーター数は2.4Bから32Bまで多岐に渡ります。これらのモデルは最大32Kトークンのロングコンテキスト処理をサポートし、現実世界のユースケースとロングコンテキスト理解において最先端の性能を発揮します。同時に、最近公開された同規模のモデルと比較して、汎用領域において競争力を維持しています。EXAONE 3.5モデルには、1) 小型またはリソースの限られたデバイスへの展開に最適化された2.4Bモデル、2) 前世代モデルと同等のサイズながら性能が向上した7.8Bモデル、3) 高性能を提供する32Bモデルが含まれます。

AIモデル

46.9K

Internvl2 5 4B

InternVL2_5-4Bは、高度なマルチモーダル大規模言語モデル(MLLM)です。InternVL 2.0をベースにコアモデルアーキテクチャを維持しつつ、トレーニングとテスト戦略、データ品質を大幅に強化しました。本モデルは、画像、テキスト間変換タスクにおいて優れた性能を発揮し、特にマルチモーダル推論、数学問題解決、OCR、グラフおよび文書理解において顕著な成果を上げています。オープンソースモデルとして、研究者や開発者が視覚と言語に基づくインテリジェントアプリケーションの探求と構築に役立つ強力なツールを提供します。

AIモデル

46.6K

Internvl2 5 8B

InternVL2_5-8Bは、OpenGVLabが開発したマルチモーダル大規模言語モデル(MLLM)です。InternVL 2.0をベースに、トレーニングおよびテスト戦略の顕著な強化とデータ品質の向上を実現しました。本モデルは『ViT-MLP-LLM』アーキテクチャを採用し、新たに増分学習されたInternViTと、InternLM 2.5やQwen 2.5などの複数の事前学習済み言語モデルを統合し、ランダム初期化されたMLPプロジェクターを使用しています。InternVL 2.5シリーズモデルは、画像?動画理解、多言語理解など、マルチモーダルタスクにおいて卓越した性能を発揮します。

AIモデル

53.3K

Olmo 2 7B

OLMo 2 7Bは、Allen Institute for AI (Ai2)が開発した7Bパラメータの大規模言語モデルです。複数の自然言語処理タスクにおいて優れた性能を発揮します。大規模データセットでの学習により、自然言語の理解と生成が可能で、様々な言語モデル関連の研究やアプリケーションをサポートします。OLMo 2 7Bの主な利点としては、大規模なパラメータ数によりより繊細な言語の特徴を捉えられること、そしてオープンソースであることで、学術界と産業界における更なる研究と応用が促進されることが挙げられます。

AIモデル

46.9K

Smolvlm

SmolVLMは、20億パラメーターを持つ小型ながらも高性能なビジョン言語モデル(VLM)です。同種のモデルと比較して、メモリ消費量が少なく、効率性に優れています。SmolVLMは、全てのモデルチェックポイント、VLMデータセット、トレーニングレシピ、ツールを含む全てがApache 2.0ライセンスの下で完全にオープンソースとして公開されています。ブラウザやエッジデバイスへのローカル展開に適しており、推論コストを削減し、ユーザーによるカスタマイズを可能にします。

AIモデル

50.0K

Qwq 32B Preview

QwQ-32B-Previewは、Qwenチームによって開発された実験的な研究モデルであり、人工知能の推論能力の向上を目指しています。このモデルは有望な分析能力を示していますが、いくつかの重要な制約も存在します。数学とプログラミングにおいては優れた性能を示しますが、常識的な推論や微妙な言語理解においては改善の余地があります。このモデルはTransformersアーキテクチャを採用しており、325億個のパラメータ、64層、40個のAttentionヘッド(GQA)を備えています。製品背景情報によると、QwQ-32B-PreviewはQwen2.5-32Bモデルをベースにさらに開発されており、より深層的な言語理解と生成能力を備えています。

AIモデル

52.7K

Qwen2.5 Coder 0.5B Instruct GPTQ Int8

Qwen2.5-Coderは、コード生成、コード推論、コード修正に特化したQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンで訓練されており、コード生成、推論、修正能力が大幅に向上しています。Qwen2.5-Coder-32Bは、現在最も高度なオープンソースコード大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。さらに、Qwen2.5-Coderはコードエージェントなど、現実世界のアプリケーションに包括的な基盤を提供し、コーディング能力の向上に加え、数学や汎用能力の面でも優位性を維持しています。

コードアシスタント

48.6K

Qwen2.5 Coder 0.5B Instruct AWQ

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。Qwen2.5の強力な能力を基盤とし、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンに拡張トレーニングすることで、Qwen2.5-Coder-32Bは現在最先端のオープンソースコードLLMとなり、そのコーディング能力はGPT-4oに匹敵します。このモデルはAWQ量子化された4ビット指令調整済み0.5Bパラメータバージョンであり、因果言語モデル、事前学習と事後学習、Transformersアーキテクチャなどの特徴を備えています。

コード推論

45.0K

Alphaqubit

AlphaQubitは、Google DeepMindとQuantum AIチームが共同開発した人工知能システムです。量子コンピューターにおけるエラーを最先端の精度で識別できます。この技術は、機械学習と量子誤り訂正の専門知識を組み合わせ、複雑な問題解決、科学的ブレークスルー、新たな分野の探求に重要な信頼性の高い量子コンピューターの構築を目指しています。AlphaQubitの主な利点には、高い精度と大規模量子計算への適合性があります。

人工知能

46.9K

Qwen2.5 Coder 32B Instruct GGUF

Qwen2.5-Coderはコード生成に特化したモデルであり、コード生成などの分野で顕著な性能向上を実現しています。パラメータ規模は多様で、量子化にも対応しています。無料であり、開発者の効率と品質向上を目的としています。

コード推論

50.8K

Qwen2.5 Coder 1.5B

Qwen2.5-Coder-1.5Bは、Qwen2.5-Coderシリーズの大規模言語モデルであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5を基盤とし、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンに拡張トレーニングすることで、現在のオープンソースコードLLMの中でもトップクラスの実力を誇り、コーディング能力はGPT-4oに匹敵します。さらに、数学と汎用能力も強化されており、コードエージェントなどの実際的なアプリケーションに、より包括的な基盤を提供します。

コードアシスタント

51.6K

Qwen2.5 Coder 7B

Qwen2.5-Coder-7Bは、Qwen2.5をベースとした大規模言語モデルであり、コード生成、コード推論、コード修正に特化しています。5.5兆トークンを超えるトレーニングデータ(ソースコード、テキストコード接地、合成データなど)を用いて学習されており、現在公開されているコード言語モデルの最新成果です。プログラミング能力においてGPT-4oと同等のパフォーマンスを示すだけでなく、数学能力や一般的な能力においても優れており、最大128Kトークンの長文コンテキストにも対応しています。

コードアシスタント

46.9K

Qwen2.5 Coder 7B Instruct

Qwen2.5-Coder-7B-Instructは、Qwen2.5-Coderシリーズのコード特化型大規模言語モデルです。0.5億、1.5億、30億、70億、140億、320億パラメータの6種類の主要なモデルサイズを網羅し、様々な開発者のニーズに対応します。コード生成、コード推論、コード修正において顕著な性能向上を実現しており、強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンで学習されています。Qwen2.5-Coder-32Bは現在最先端のオープンソースコードLLMであり、そのコーディング能力はGPT-4oに匹敵します。さらに、最大128Kトークンの長文コンテキストに対応し、コードエージェントのような実際的なアプリケーションに包括的な基盤を提供します。

コードアシスタント

47.2K

Qwen2.5 Coder 14B

Qwen2.5-Coder-14Bは、Qwenシリーズのコード専門の大規模言語モデルです。0.5億から32億パラメータまでの様々なモデルサイズを用意しており、開発者の多様なニーズに対応します。コード生成、コード推論、コード修正において顕著な性能向上を実現しており、強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンで学習されています。Qwen2.5-Coder-32Bは、現在最先端のオープンソースコードLLMであり、そのコーディング能力はGPT-4oに匹敵します。さらに、コードエージェントなどの現実世界のアプリケーションに包括的な基盤を提供し、コーディング能力の強化に加え、数学や汎用能力における強みも維持しています。最大128Kトークンのロングコンテキストに対応しています。

コードアシスタント

48.0K

Qwen2.5 Coder 14B Instruct

Qwen2.5-Coder-14B-Instructは、Qwen2.5-Coderシリーズの大規模言語モデルであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンまで拡張トレーニングを行い、現在オープンソースのコードLLMにおける最新技術となっています。コーディング能力の向上だけでなく、数学や汎用能力の優位性も維持しており、最大128Kトークンのロングコンテキストにも対応しています。

コードアシスタント

44.7K

Qwen2.5 Coder 32B

Qwen2.5-Coder-32Bは、Qwen2.5をベースとしたコード生成モデルで、32億個のパラメータを持ちます。これは現在、オープンソースのコード言語モデルの中で最大規模のモデルの一つです。コード生成、コード推論、コード修正において顕著な改善が見られ、最大128Kトークンの長文処理に対応できるため、コードエージェントなどの実用的なアプリケーションシナリオに適しています。数学や一般的な能力も維持しており、長文処理にも対応するため、開発者にとって強力なコード開発支援ツールとなります。

コードアシスタント

46.9K

Qwen2.5 Coder 32B Instruct

Qwen2.5-Coderは、コード生成用に設計されたQwen大規模言語モデルシリーズで、0.5、1.5、3、7、14、32億パラメータの6つの主要なモデルサイズがあり、様々な開発者のニーズに対応します。このモデルは、コード生成、コード推論、コード修正において顕著な改善が見られ、強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンでトレーニングされました。Qwen2.5-Coder-32Bは、現在最も高度なオープンソースのコード生成大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。コーディング能力の向上に加え、数学や汎用的な能力も維持しており、最大128Kトークンのロングコンテキストにも対応しています。

コードアシスタント

50.2K

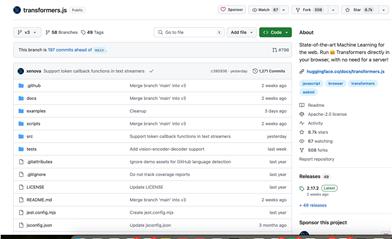

Transformers.js

transformers.jsは、Webページに高度な機械学習機能を提供することを目的としたJavaScriptライブラリです。このライブラリにより、ユーザーはサーバーレスで、事前にトレーニングされたTransformersモデルをブラウザ上で直接実行できます。バックエンドとしてONNX Runtimeを使用しており、PyTorch、TensorFlow、またはJAXモデルをONNX形式に変換できます。transformers.jsはHugging Faceのtransformers Pythonライブラリと同等の機能を提供し、同様のAPIを提供することで、開発者は既存のコードを容易にWebフロントエンドに移行できます。

AI開発助手

59.6K

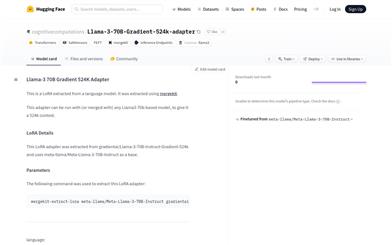

Llama 3 70B Gradient 524K アダプター

Llama-3 70B Gradient 524K アダプターは、Gradient AI Teamが開発したLlama-3 70Bモデルベースのアダプターです。LoRA技術を用いてモデルのコンテキスト長を524Kに拡張することで、長文データ処理におけるモデルのパフォーマンスを向上させます。このモデルは、NTK-aware補間とRingAttentionライブラリなどの高度なトレーニング技術を用いて、高性能計算クラスタ上で効率的にトレーニングされています。

AIモデル

48.0K

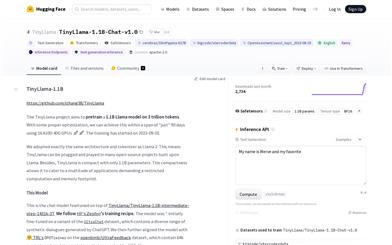

Tinyllama

TinyLlamaプロジェクトは、3兆トークンで11億パラメーターのLlamaモデルを事前学習することを目指しています。適切な最適化により、「わずか」90日間で16台のA100-40G GPUを使用して学習を完了することができました。学習は2023年9月1日に開始されました。Llama 2と全く同じアーキテクチャとトークナイザーを採用しています。そのため、Llamaをベースとした多くのオープンソースプロジェクトでTinyLlamaを使用できます。さらに、TinyLlamaはパラメーター数が11億とコンパクトなため、計算資源やメモリ容量が限られたアプリケーションにも対応できます。

AIモデル

69.8K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

41.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

41.1K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

40.3K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

39.7K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

40.8K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

39.7K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M