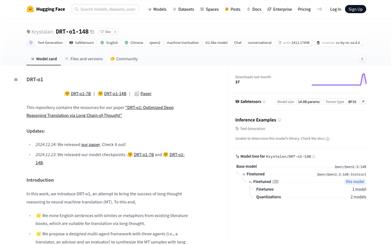

EXAONE 3.5 2.4B Instruct

紹介 :

EXAONE-3.5-2.4B-Instructは、LG AI Researchが開発した一連のバイリンガル(英語と韓国語)命令微調整済み生成モデルで、パラメータ数は2.4Bから32Bです。これらのモデルは最大32Kトークンの長いコンテキスト処理をサポートし、現実世界のユースケースと長いコンテキストの理解において最先端の性能を示すと同時に、最近発表された同規模のモデルと比較して一般的な分野においても競争力を維持しています。このモデルは、自動翻訳、テキスト要約、対話システムなど、長文処理と多言語対応が必要なシナリオに特に適しています。

ターゲットユーザー :

大量のテキストデータと多言語対応の対話処理を必要とする開発者や研究者を対象としています。EXAONE-3.5-2.4B-Instructは長いコンテキスト処理とバイリンガル機能をサポートしているため、自動翻訳、テキスト要約、対話システムなど、複雑なテキストコンテンツの理解と生成を必要とするアプリケーションに特に適しています。

使用シナリオ

自動翻訳:英語のテキストを韓国語に、またはその逆に翻訳します。

テキスト要約:長い記事やレポートの短い要約を生成します。

対話システム:ユーザーの入力を理解し、応答できるインテリジェントアシスタントを作成します。

製品特徴

パラメータ数(埋め込み層を除く):21.4億

層数:30

アテンションヘッド数:GQA、32個のQヘッドと8個のKVヘッド

語彙数:102,400

コンテキスト長:32,768トークン

単語埋め込みの結合:真(7.8Bおよび32Bモデルとは異なる)

使用チュートリアル

1. transformersライブラリv4.43以降をインストールします。

2. AutoModelForCausalLMとAutoTokenizerを使用して、Hugging Faceからモデルとトークナイザーを読み込みます。

3. プロンプトを選択しますまたは記述します(英語または韓国語)。

4. tokenizer.apply_chat_templateメソッドを使用して、メッセージとプロンプトをモデルが理解できる形式に変換します。

5. model.generateメソッドを使用してテキストを生成します。

6. tokenizer.decodeメソッドを使用して、生成されたトークンをテキストに変換します。

7. 生成されたテキストを出力するか、その他の方法で使用します。

おすすめAI製品

中国語精選

豆包(doubao)

豆包(Doubao)は、自然言語処理を用いたインテリジェントなチャットボットです。天気、ニュース、ジョーク、音楽など、様々な話題でユーザーと自然な会話を楽しむことができます。さらに、ユーザーの好みや習慣に基づいて、関連性の高いコンテンツやサービスをレコメンドします。豆包はあなた専属のチャットアシスタントとして、寂しさを解消します。

会話型AI

17.0M

中国語精選

Kimiスマートアシスタント

Kimi Chatは、月之暗面科技が開発した、スマートなチャットボットアプリです。大容量の知識ベースを備え、インテリジェントな雑談、質問への回答、生活支援サービスの提供など、高度なインテリジェントなインタラクション能力を備えています。いつでもどこでもKimiとチャットして楽しみを見つけることができ、その返答は多様で、会話をより楽しくします。Kimi Chatは完全に無料で、QRコードをスキャンするか、携帯電話で検索して直接使用できます。

会話型AI

15.9M