Cheating LLM Benchmarks

簡介 :

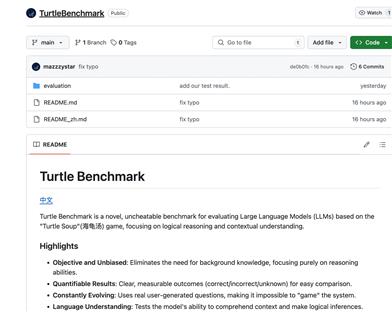

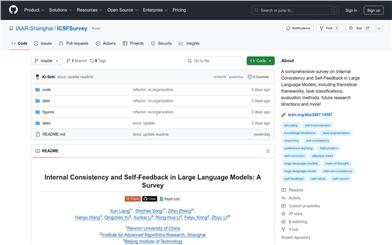

Cheating LLM Benchmarks 是一個研究項目,旨在通過構建所謂的“零模型”(null models)來探索在自動語言模型(LLM)基準測試中的作弊行為。該項目通過實驗發現,即使是簡單的零模型也能在這些基準測試中取得高勝率,這挑戰了現有基準測試的有效性和可靠性。該研究對於理解當前語言模型的侷限性和改進基準測試方法具有重要意義。

需求人群 :

目標受眾主要是自然語言處理(NLP)領域的研究人員、開發者以及對語言模型性能評估感興趣的技術愛好者。這個項目為他們提供了一個平臺,用於測試和理解現有語言模型的基準測試性能,以及探討如何改進這些測試方法。

使用場景

研究人員使用該項目來測試和分析不同語言模型在特定任務上的表現。

開發者利用該項目的代碼和工具來構建和評估自己的語言模型。

教育機構可能使用這個項目作為教學案例,幫助學生理解語言模型評估的複雜性。

產品特色

構建零模型以參與語言模型基準測試。

通過Jupyter Notebook提供實驗步驟和代碼。

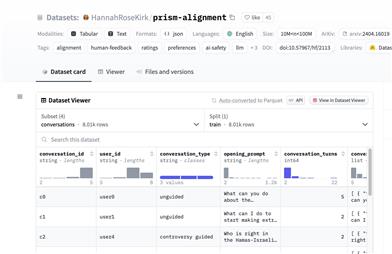

使用AlpacaEval工具來評估模型輸出。

計算並分析模型的勝率和標準誤差。

提供詳細的實驗結果和分析數據。

支持對實驗結果進行進一步的重新評估和分析。

使用教程

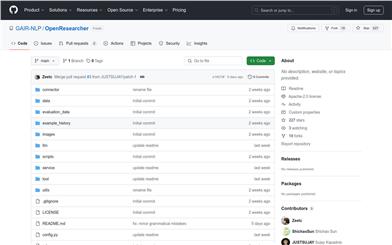

1. 訪問項目GitHub頁面並克隆或下載項目代碼。

2. 安裝必要的依賴項,如Jupyter Notebook和AlpacaEval。

3. 運行項目中的Jupyter Notebook文件,如'01_prepare_submission.ipynb',以構建零模型提交。

4. 使用AlpacaEval工具評估模型輸出,按照項目中的指南設置環境變量並運行評估命令。

5. (可選)運行'02_re_evaluate_submission.ipynb'進行進一步的分析,計算勝率等統計數據。

6. 查看項目中的'README.md'和'LICENSE'文件,瞭解更多關於項目的使用和許可信息。

精選AI產品推薦

Deepeval

DeepEval提供了不同方面的度量來評估LLM對問題的回答,以確保答案是相關的、一致的、無偏見的、非有毒的。這些可以很好地與CI/CD管道集成在一起,允許機器學習工程師快速評估並檢查他們改進LLM應用程序時,LLM應用程序的性能是否良好。DeepEval提供了一種Python友好的離線評估方法,確保您的管道準備好投入生產。它就像是“針對您的管道的Pytest”,使生產和評估管道的過程與通過所有測試一樣簡單直接。

AI模型評測

170.8K

Sciagentsdiscovery

SciAgentsDiscovery 是一個利用多智能體系統和大規模本體知識圖譜,自動化科學研究的系統。它通過整合大型語言模型、數據檢索工具和多智能體學習系統,能夠自主生成和完善研究假設,揭示潛在的機制、設計原則和意外材料屬性。該系統在生物啟發材料領域展示了其跨學科關係的發現能力,超越了傳統人類驅動的研究方法。

AI學術研究

128.9K