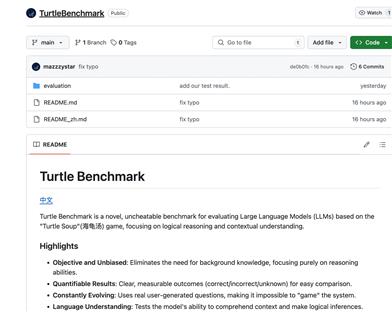

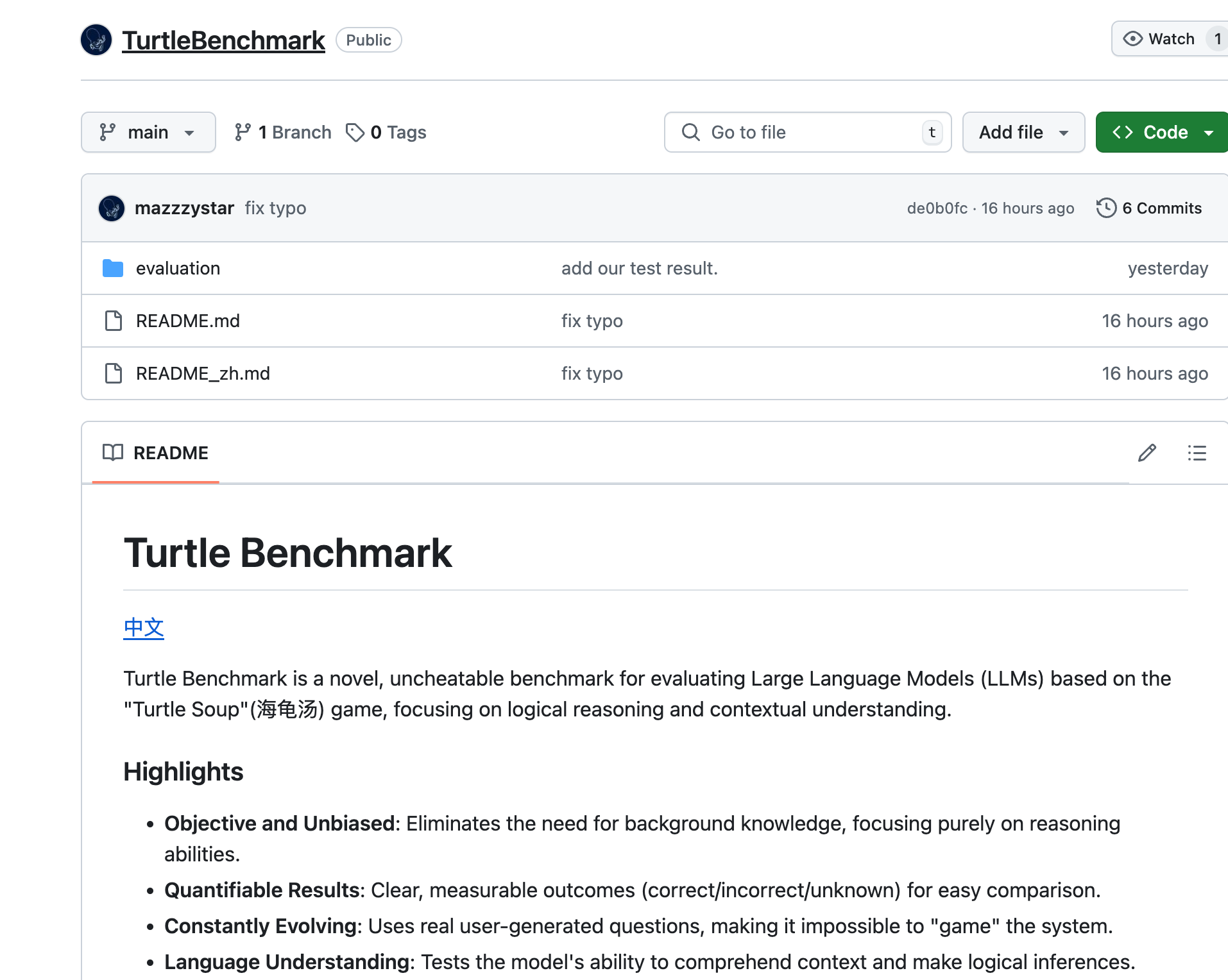

Turtle Benchmark

簡介 :

Turtle Benchmark是一款基於'Turtle Soup'遊戲的新型、無法作弊的基準測試,專注於評估大型語言模型(LLMs)的邏輯推理和上下文理解能力。它通過消除對背景知識的需求,提供了客觀和無偏見的測試結果,具有可量化的結果,並且通過使用真實用戶生成的問題,使得模型無法被'遊戲化'。

需求人群 :

Turtle Benchmark適用於需要評估和比較大型語言模型性能的研究者和開發者。它特別適合那些專注於模型的邏輯推理和上下文理解能力的專業人士,幫助他們更準確地瞭解模型在中文語境下的表現。

使用場景

研究者使用Turtle Benchmark評估不同大型語言模型在特定邏輯推理任務上的表現。

開發者利用Turtle Benchmark測試他們的語言模型是否能夠準確理解並回答用戶的問題。

教育機構使用Turtle Benchmark作為教學工具,幫助學生理解大型語言模型的工作原理和性能評估方法。

產品特色

目標明確、無偏見:專注於推理能力,無需背景知識。

結果可量化:提供清晰、可測量的結果(正確/錯誤/未知),便於比較。

持續進化:使用真實用戶生成的問題,防止系統被操縱。

語言理解:測試模型理解上下文和進行邏輯推斷的能力。

使用簡單:通過簡單的命令行操作即可進行評估。

數據豐富:包含32個獨特的'Turtle Soup'故事和1537個人工標註的標籤。

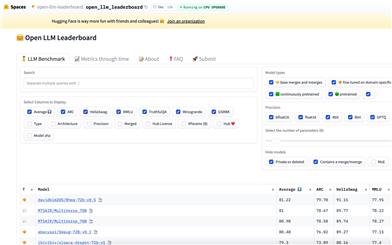

結果解讀:通過散點圖比較不同模型在2-shot學習場景下的整體準確率和故事平均準確率。

使用教程

1. 進入Turtle Benchmark項目目錄。

2. 將.env.example文件重命名為.env並添加API密鑰。

3. 執行`python evaluate.py`命令以進行2-shot學習評估。

4. 如需進行零樣本(Zero-shot)評估,執行`python evaluate.py --shot 0`命令。

5. 查看評估結果,包括整體準確率和故事平均準確率。

6. 通過散點圖分析不同模型的性能差異。