LLMベンチマークにおける不正行為の研究

紹介 :

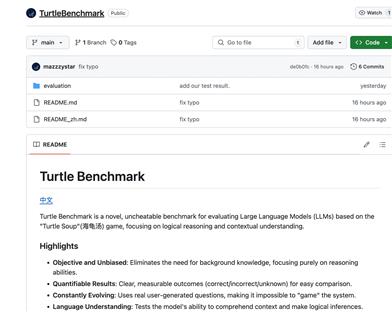

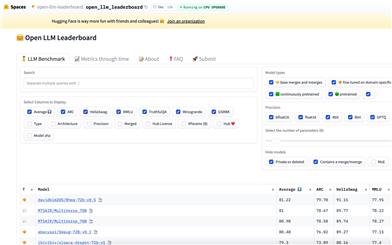

「Cheating LLM Benchmarks」は、いわゆる「ゼロモデル」を構築することで、自動言語モデル(LLM)のベンチマークにおける不正行為を調査することを目的とした研究プロジェクトです。本プロジェクトでは、実験を通じて、単純なゼロモデルでさえこれらのベンチマークで高い勝率を達成できることを発見しました。これは、既存のベンチマークの有効性と信頼性に疑問を投げかけるものです。この研究は、現在の言語モデルの限界を理解し、ベンチマーク手法を改良するために重要な意味を持ちます。

ターゲットユーザー :

主な対象読者は、自然言語処理(NLP)分野の研究者、開発者、そして言語モデルの性能評価に関心のある技術愛好家です。本プロジェクトは、既存の言語モデルのベンチマーク性能をテスト?理解し、これらのテスト手法を改善する方法を探求するためのプラットフォームを提供します。

使用シナリオ

研究者は本プロジェクトを使用して、特定のタスクにおける様々な言語モデルの性能をテスト?分析します。

開発者は本プロジェクトのコードとツールを利用して、独自の言語モデルを構築?評価します。

教育機関は、本プロジェクトを教育事例として使用し、学生が言語モデル評価の複雑性を理解するのに役立てることができます。

製品特徴

言語モデルベンチマークに参加するためのゼロモデルを構築する。

Jupyter Notebookを用いて実験手順とコードを提供する。

AlpacaEvalツールを使用してモデルの出力を評価する。

モデルの勝率と標準誤差を計算し、分析する。

詳細な実験結果と分析データを提供する。

実験結果の更なる再評価と分析を支援する。

使用チュートリアル

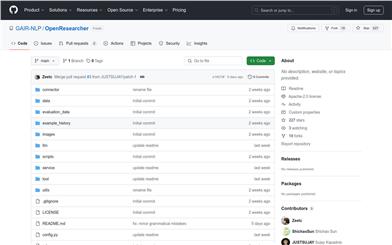

1. プロジェクトのGitHubページにアクセスし、プロジェクトコードをクローンまたはダウンロードします。

2. Jupyter NotebookとAlpacaEvalなど、必要な依存関係をインストールします。

3. プロジェクト内のJupyter Notebookファイル(例:'01_prepare_submission.ipynb')を実行して、ゼロモデルの提出物を構築します。

4. AlpacaEvalツールを使用してモデルの出力を評価します。プロジェクト内のガイドに従って環境変数を設定し、評価コマンドを実行します。

5. (オプション)'02_re_evaluate_submission.ipynb'を実行して、勝率などの統計データを計算し、さらなる分析を行います。

6. プロジェクト内の'README.md'と'LICENSE'ファイルを参照して、プロジェクトの使用方法とライセンスに関する詳細情報を確認してください。

おすすめAI製品

Deepeval

DeepEvalは、LLMが問題に対する回答を評価するための多角的な指標を提供し、回答が関連性があり、一貫性があり、偏りや有害な表現を含まないことを保証します。CI/CDパイプラインとの統合も容易で、機械学習エンジニアはLLMアプリケーションの改善に伴うパフォーマンスの向上を迅速に評価?検証できます。DeepEvalはPythonに優しいオフライン評価方法を提供し、パイプラインの運用準備を確実にします。それはまさに「パイプラインのためのPytest」と言えるもので、テストの通過と同じくらいシンプルで直接的な方法で、生産と評価パイプラインのプロセスを実現します。

AIモデル評価

160.1K

Benchmark Medical RAG

Benchmark Medical RAGは、医療分野に特化した検索拡張型質問応答(Retrieval-Augmented Generation)のベンチマークテストプラットフォームです。医療情報検索と生成モデルの研究を促進するため、一連のデータセットと評価ツールを提供しています。

AI研究開発

79.8K