MLE Bench

簡介 :

MLE-bench是由OpenAI推出的一個基準測試,旨在衡量AI代理在機器學習工程方面的表現。該基準測試彙集了75個來自Kaggle的機器學習工程相關競賽,形成了一套多樣化的挑戰性任務,測試了訓練模型、準備數據集和運行實驗等現實世界中的機器學習工程技能。通過Kaggle公開的排行榜數據,為每項競賽建立了人類基準。使用開源代理框架評估了多個前沿語言模型在該基準上的表現,發現表現最佳的設置——OpenAI的o1-preview配合AIDE框架——在16.9%的競賽中至少達到了Kaggle銅牌的水平。此外,還研究了AI代理的各種資源擴展形式以及預訓練汙染的影響。MLE-bench的基準代碼已經開源,以促進未來對AI代理機器學習工程能力的理解。

需求人群 :

MLE-bench的目標受眾是機器學習工程師、數據科學家和AI研究人員。這些專業人員可以通過MLE-bench來評估和比較不同AI代理在機器學習工程任務上的表現,從而選擇最適合他們項目的AI工具。同時,研究人員可以通過該基準測試來進一步理解AI代理在機器學習工程領域的能力,推動相關技術的發展。

使用場景

機器學習工程師使用MLE-bench來測試和評估不同AI模型在特定任務上的性能。

數據科學家利用MLE-bench來比較不同AI代理在數據預處理和模型訓練上的效果。

AI研究人員使用MLE-bench來研究和改進AI代理在機器學習工程任務中的資源利用效率。

產品特色

評估AI代理在機器學習工程任務上的性能

提供75個來自Kaggle的多樣化機器學習工程競賽任務

使用Kaggle排行榜數據建立人類基準

開源代理框架評估前沿語言模型

研究AI代理的資源擴展和預訓練汙染影響

開源基準代碼,促進未來研究

使用教程

步驟1:訪問MLE-bench的官方網站或GitHub頁面。

步驟2:閱讀關於MLE-bench的介紹和使用方法。

步驟3:下載並安裝必要的軟件和依賴,如開源代理框架。

步驟4:根據指南設置並運行基準測試,評估你的AI代理或模型。

步驟5:分析測試結果,瞭解你的AI代理在機器學習工程任務上的表現。

步驟6:根據需要調整AI代理的配置或優化模型,以提高其在基準測試中的表現。

步驟7:參與社區討論,分享你的經驗和發現,或尋求幫助。

精選AI產品推薦

Deepeval

DeepEval提供了不同方面的度量來評估LLM對問題的回答,以確保答案是相關的、一致的、無偏見的、非有毒的。這些可以很好地與CI/CD管道集成在一起,允許機器學習工程師快速評估並檢查他們改進LLM應用程序時,LLM應用程序的性能是否良好。DeepEval提供了一種Python友好的離線評估方法,確保您的管道準備好投入生產。它就像是“針對您的管道的Pytest”,使生產和評估管道的過程與通過所有測試一樣簡單直接。

AI模型評測

170.0K

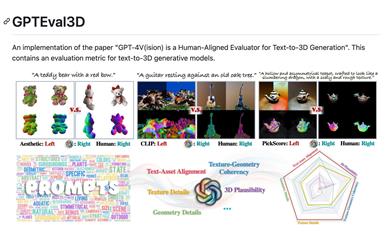

Gpteval3d

GPTEval3D是一個開源的3D生成模型評價工具,基於GPT-4V實現了對文本到3D生成模型的自動評測。它可以計算生成模型的ELO分數,並與現有模型進行對比排名。該工具簡單易用,支持用戶自定義評測數據集,可以充分發揮GPT-4V的評測效果,是研究3D生成任務的有力工具。

AI模型評測

77.0K