Aya Vision 8B

CohereForAIのAya Vision 8Bは、8億パラメーターの多言語視覚言語モデルであり、OCR、画像キャプション、視覚推論、要約、Q&Aなど、さまざまな視覚言語タスク向けに最適化されています。このモデルはC4AI Command R7B言語モデルとSigLIP2視覚エンコーダを組み合わせ、23言語をサポートし、16Kのコンテキスト長を備えています。主な利点としては、多言語サポート、強力な視覚理解能力、幅広い適用シーンなどが挙げられます。このモデルはオープンソースの重みとして公開され、世界中の研究コミュニティの発展を促進することを目的としています。CC-BY-NCライセンスに基づき、ユーザーはC4AIの許容利用ポリシーを遵守する必要があります。

AIモデル

48.3K

Figure AI Helix

Helixは、人型ロボットの汎用制御向けに設計された革新的な視覚?言語?行動モデルです。視覚認識、言語理解、動作制御を組み合わせることで、複雑な環境におけるロボットの長期的な課題を複数解決します。Helixの主な利点には、強力な汎化能力、効率的なデータ活用、タスク固有の微調整を必要としない単一ニューラルネットワークアーキテクチャが含まれます。このモデルは、家庭環境におけるロボットに即時の行動生成能力を提供することを目的としており、これまで見たことのない物体にも対応できます。Helixの登場は、日常生活の場面への適応という点で、ロボット工学における重要な一歩を示しています。

ロボット工学

43.6K

Siglip2

SigLIP2は、Googleが開発した多言語視覚言語エンコーダーで、改良された意味理解、局所化、および高密度特徴を備えています。ゼロショット画像分類に対応しており、追加のトレーニングなしで、テキスト記述から直接画像を分類できます。多言語環境で優れたパフォーマンスを発揮し、様々な視覚言語タスクに適用可能です。主な利点としては、効率的な言語画像アライメント能力、様々な解像度と動的解像度調整のサポート、強力なクロスリンガル汎化能力などが挙げられます。SigLIP2の登場は、特に迅速な展開と多言語サポートが必要な場面において、多言語視覚タスクに新たなソリューションを提供します。

AIモデル

47.7K

R1 V

R1-Vは、視覚言語モデル(VLM)の汎化能力に特化したプロジェクトです。検証可能な報酬による強化学習(RLVR)技術を用いることで、特に分布外(OOD)テストにおいて、VLMの視覚カウントタスクにおける汎化能力を大幅に向上させました。この技術の重要性は、わずか2.62ドルのトレーニングコストで、大規模モデルを効率的に最適化できる点にあり、視覚言語モデルの実用化に新たな道を切り開きます。プロジェクトの背景は、既存のVLMトレーニング方法の改善に基づいており、革新的なトレーニング戦略を通じて、複雑な視覚タスクにおけるモデルのパフォーマンス向上を目指しています。R1-Vのオープンソース性も、研究者や開発者が高度なVLM技術を探求し、応用するための重要なリソースとなっています。

AIモデル

54.4K

Paligemma 2 3b Pt 224

PaliGemma 2はGoogleによって開発された視覚言語モデルであり、SigLIP視覚モデルとGemma 2言語モデルの能力を組み合わせることで、画像とテキストの入力を受け取り、それに対応するテキスト出力を生成できます。このモデルは、画像キャプション生成や視覚質問応答など、様々な視覚言語タスクにおいて優れたパフォーマンスを発揮します。主な利点としては、強力な多言語サポート、効率的なトレーニングアーキテクチャ、そして様々なタスクにおける優れた性能が挙げられます。PaliGemma 2の開発背景には、視覚と言語間の複雑な相互作用の問題を解決し、研究者や開発者が関連分野でブレイクスルーを達成することを支援するという目的があります。

AIモデル

46.1K

Paligemma 2 3b Pt 448

PaliGemma 2は、Googleによって開発された視覚言語モデルであり、Gemma 2モデルの能力を受け継いでいます。画像とテキストの入力を処理し、テキスト出力を生成できます。画像キャプション生成、視覚的質問応答など、様々な視覚言語タスクにおいて優れた性能を発揮します。主な利点としては、強力な多言語サポート、効率的なトレーニングアーキテクチャ、幅広い適用性などが挙げられます。ソーシャルメディアコンテンツ生成やスマートカスタマーサービスなど、視覚とテキストデータを処理する必要がある様々なアプリケーションシナリオに適しています。

AIモデル

45.5K

Cogagent 9B 20241220

CogAgent-9B-20241220モデルは、GLM-4V-9B双言語オープンソースVLM基礎モデルに基づいており、データ収集と最適化、多段階トレーニング、戦略改善を通じて、GUI認識、推論予測精度、動作空間の完全性、タスクの汎化性において顕著な進歩を遂げました。このモデルは双言語(中国語と英語)のインタラクションをサポートし、スクリーンショットと言語入力を処理できます。このバージョンは既にZhipuAIのGLM-PC製品に適用されており、視覚言語モデルに基づくGUIエージェントの研究と応用を推進することを目的としています。

AIモデル

45.8K

Vision Parse

vision-parseは、視覚言語モデル(Vision LLMs)を使用してPDF文書をフォーマットされたMarkdownコンテンツに変換するツールです。OpenAI、LLama、Geminiなど、複数のモデルに対応しており、テキストや表をインテリジェントに認識して抽出するだけでなく、文書の階層構造、スタイル、インデントも保持します。高精度なコンテンツ抽出、フォーマットの維持、マルチモデルサポート、ローカルモデルのホスティングといった主な利点を備え、効率的な文書処理が必要なユーザーに適しています。

文書

53.5K

Cogagent

CogAgentは、スクリーンショットと自然言語を用いて、中国語と英語のバイリンガル対応を実現する、視覚言語モデル(VLM)ベースのGUIエージェントです。GUI認識、推論予測精度、操作空間の完全性、タスクの汎化において著しい進歩を遂げています。このモデルは既にZhipuAIのGLM-PC製品に適用されており、視覚言語モデルベースのGUIエージェントの研究開発を推進することを目指しています。

AIモデル

53.0K

POINTS Yi 1.5 9B Chat

POINTS-Yi-1.5-9B-Chatは、最新の視覚言語モデル技術と微信AIが開発した新技術を統合した視覚言語モデルです。事前学習データセットのフィルタリングやModel Soup技術などにおいて顕著なイノベーションがあり、事前学習データセットのサイズを大幅に削減し、モデルのパフォーマンスを向上させます。複数のベンチマークテストで優れた性能を発揮しており、視覚言語モデル分野における重要な進歩です。

AIモデル

48.0K

POINTS Qwen 2 5 7B Chat

POINTS-Qwen-2-5-7B-Chatは、微信AIの研究者によって提案された、視覚言語モデルの最新技術と新たな手法を統合したモデルです。事前学習データセットの選別やモデル蒸留などの技術により、モデル性能を大幅に向上させています。複数のベンチマークテストで優れた性能を示しており、視覚言語モデル分野における重要な進歩と言えます。

AIモデル

47.5K

Deepseek VL2

DeepSeek-VL2は、大規模なMixture-of-Experts (MoE) 方式の視覚言語モデルシリーズであり、前世代のDeepSeek-VLから大幅な性能向上を実現しています。このモデルシリーズは、視覚的な質問応答、光学文字認識 (OCR)、文書?表?グラフの理解、および視覚的局所化などのタスクにおいて卓越した能力を示します。DeepSeek-VL2には、活性化パラメータ数がそれぞれ10億、28億、45億の3つのバリエーションがあります: DeepSeek-VL2-Tiny、DeepSeek-VL2-Small、およびDeepSeek-VL2。活性化パラメータ数が同等またはそれ以下である既存のオープンソースの密集型およびMoEベースのモデルと比較して、DeepSeek-VL2は競争力のある、あるいは最先端の性能を達成しています。

AIモデル

65.1K

Florence VL

Florence-VLは、生成型視覚エンコーダと深層幅融合技術を導入することで、視覚情報と言語情報の処理能力を強化した視覚言語モデルです。この技術は、機械による画像とテキストの理解度を向上させ、マルチモーダルタスクにおいてより良い結果を得られるという点で重要です。Florence-VLはLLaVAプロジェクトを基に開発されており、事前学習済みモデルと微調整のためのコード、モデルチェックポイント、デモを提供しています。

AIモデル

49.4K

Qwen2 VL 2B

Qwen2-VL-2BはQwen-VLモデルの最新版であり、およそ1年間の革新的な成果を反映しています。このモデルは、MathVista、DocVQA、RealWorldQA、MTVQAなど、視覚理解のベンチマークテストにおいて最先端の性能を達成しています。20分を超えるビデオの理解にも対応し、ビデオベースの質問応答、対話、コンテンツ作成などを高品質にサポートします。Qwen2-VLは多言語にも対応しており、英語と中国語に加え、ほとんどのヨーロッパ言語、日本語、韓国語、アラビア語、ベトナム語などを含みます。モデルアーキテクチャの更新には、Naive Dynamic ResolutionとMultimodal Rotary Position Embedding (M-ROPE)が含まれ、マルチモーダル処理能力が強化されています。

AIモデル

49.7K

Llava O1

LLaVA-o1は、北京大学元組チームが開発した視覚言語モデルです。GPT-o1と同様に、自発的で体系的な推論を実行できます。Gemini-1.5-pro、GPT-4o-mini、Llama-3.2-90B-Vision-Instructなど、6つの難易度が高いマルチモーダルベンチマークテストにおいて、他のモデルを凌駕する成果を上げています。LLaVA-o1は段階的推論によって問題を解決し、視覚言語モデルにおける独自の強みを示しています。

段階的推論

49.1K

Promptfix

PromptFixは、拡散モデルが人間の指示に従って様々な画像処理タスクを実行できるようにする包括的なフレームワークです。大規模な指示従順データセットを構築し、高周波数ガイド付きサンプリング手法を提案してノイズ除去プロセスを制御し、補助プロンプトアダプターを設計して視覚言語モデルを用いてテキストプロンプトを強化することで、モデルのタスク汎化能力を高めています。PromptFixは、様々な画像処理タスクにおいて従来の方法を上回る性能を示し、ブラインドリストアおよび合成タスクにおいて優れたゼロショット能力を発揮します。

画像編集

52.4K

ROCKET 1

ROCKET-1は、オープンワールド環境における具象化された意思決定のために設計された視覚言語モデル(VLMs)です。このモデルは、視覚的?時間的コンテキストプロンプトプロトコルを通じて、VLMsとポリシーモデル間の通信を繋ぎ、過去と現在の観測からのオブジェクト分割を利用してポリシーと環境のインタラクションを導きます。ROCKET-1はこの方法により、VLMsの視覚言語推論能力を解き放ち、特に空間理解において、複雑な創造的なタスクを解決することを可能にします。Minecraftにおける実験では、この手法によりエージェントが以前は不可能だったタスクを達成できることが示され、具象化された意思決定における視覚的?時間的コンテキストプロンプトの有効性を強調しています。

モデルトレーニングとデプロイメント

46.9K

Visrag

VisRAGは、革新的な視覚言語モデル(VLM)に基づくRAG(Retrieval-Augmented Generation)手法です。従来のテキストベースのRAGとは異なり、VisRAGは文書を画像としてVLMで直接埋め込み、その後検索してVLMの生成能力を強化します。この手法は、元の文書データの情報を最大限に保持し、解析過程での情報損失を排除します。VisRAGモデルはマルチモーダル文書への適用において、情報検索と強化テキスト生成における強力な可能性を示しています。

研究機器

51.1K

Colpali

ColPaliは、視覚言語モデルに基づく高効率な文書検索ツールです。文書ページの画像を直接埋め込むことで、文書検索プロセスを簡素化します。ColPaliは、最新の視覚言語モデル技術、特にPaliGemmaモデルを活用し、遅延相互作用メカニズムにより多ベクトル検索を実現することで、検索パフォーマンスを向上させます。この技術は、索引速度の向上と問い合わせ遅延の低減だけでなく、グラフ、表、画像など、視覚要素を含む文書の検索において優れたパフォーマンスを発揮します。ColPaliの登場は、文書検索分野に新たな「視覚空間検索」パラダイムをもたらし、情報検索の効率性と正確性の向上に貢献します。

AI検索エンジン

45.8K

Helpful DoggyBot

Helpful DoggyBotは、四足歩行ロボットの室内移動OSです。前端の把持装置による物体操作を行い、シミュレーション環境で訓練された低レベルコントローラにより、登攀や全身傾斜などの敏捷な動作を実現します。さらに、事前学習済みの視覚言語モデル(VLMs)を統合することで、意味理解と命令生成を行います。本システムは、実際のデータ収集や訓練なしに、未見の環境においてゼロショット汎化でタスクを実行でき、例えば、ユーザーの指示に従って、登攀後のベッド脇にランダムに置かれたおもちゃを拾い上げるタスクを、60%の成功率で達成します。

AI機械人

45.8K

高品質新製品

Internlm XComposer 2.5

InternLM-XComposer-2.5は、長文コンテキストの入出力に対応した多機能大型視覚言語モデルです。様々なテキスト?画像の理解と創作アプリケーションにおいて優れた性能を発揮し、GPT-4Vと同等のレベルに達していますが、7BのLLMバックエンドのみを使用しています。24Kのインターリーブされた画像テキストコンテキストで学習されており、RoPE外挿により96Kの長文コンテキストにシームレスに拡張できます。この長文コンテキスト能力により、広範な入力と出力コンテキストを必要とするタスクで特に優れた性能を発揮します。さらに、超高解像度画像理解、細粒度ビデオ理解、複数回にわたる複数画像の対話、Webサイト作成、高品質な画像付き記事の作成などもサポートしています。

AIモデル

72.6K

Drivevlm

DriveVLMは、視覚言語モデル(VLMs)を利用してシーン理解と計画能力を強化した自動運転システムです。シーン記述、シーン分析、階層的計画を含む独自の推論モジュールを組み合わせることで、複雑で長尾のシーンに対する理解力を向上させます。さらに、VLMsにおける空間推論と計算需要の制約に対処するため、DriveVLMの利点と従来の自動運転プロセスを組み合わせたハイブリッドシステムであるDriveVLM-Dualを提案しています。nuScenesデータセットとSUP-ADデータセットでの実験により、DriveVLMとDriveVLM-Dualは、複雑で予測不可能な運転状況に対処する上で非常に有効であることが示されました。最終的に、DriveVLM-Dualは量産車に搭載され、現実世界の自動運転環境における有効性が検証されました。

AI自動運転

51.6K

Pixelprose

PixelProseは、tomg-group-umdによって作成された大規模データセットであり、最先端の視覚言語モデルGemini 1.0 Pro Visionを用いて、1600万件を超える詳細な画像記述を生成しています。このデータセットは、画像テキスト変換技術の開発と改良に非常に重要であり、画像記述生成、視覚的質問応答などのタスクに使用できます。

AI画像検出識別

53.3K

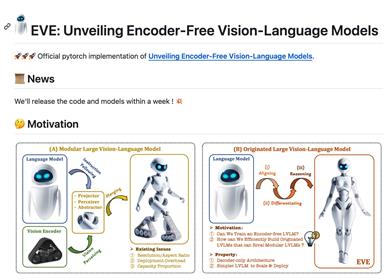

EVE

EVEは、大連理工大学、北京人工智能研究院、北京大学の研究者によって共同開発された、エンコーダフリーの視覚言語モデルです。様々なアスペクト比の画像において優れた能力を発揮し、Fuyu-8Bを上回り、モジュール型エンコーダベースのLVLMsに匹敵する性能を示します。EVEはデータ効率とトレーニング効率に優れ、33Mの公開データを用いた事前学習と、665KのLLaVA SFTデータを用いたEVE-7Bモデルのトレーニング、さらに1.2MのSFTデータを用いたEVE-7B (HD)モデルのトレーニングが行われています。EVEの開発は、効率的で透明性が高く、実用的な戦略を採用しており、クロスモーダルな純粋なデコーダアーキテクチャに新たな道を切り開いています。

AIモデル

48.0K

RL4VLM

RL4VLMは、強化学習によって大規模な視覚言語モデルを微調整し、意思決定を行うインテリジェントなエージェントにすることを目的としたオープンソースプロジェクトです。Yuexiang Zhai、Hao Bai、Zipeng Lin、Jiayi Pan、Shengbang Tong、Alane Suhr、Saining Xie、Yann LeCun、Yi Ma、Sergey Levineらの研究者によって開発されました。LLaVAモデルをベースとし、PPOアルゴリズムを用いた強化学習による微調整を行います。RL4VLMプロジェクトでは、詳細なコードベースの構造、入門ガイド、ライセンス情報、およびこの研究の引用方法に関する説明を提供しています。

AIモデル

54.6K

高品質新製品

Paligemma

PaliGemmaは、Googleが公開した高度な視覚言語モデルです。画像エンコーダSigLIPとテキストデコーダGemma-2Bを組み合わせることで、画像とテキストの理解、そしてそれらの相互作用を理解することを可能にしています。画像キャプション生成、視覚的質問応答、セグメンテーションなどの特定の下流タスク向けに設計されており、研究開発において重要なツールです。

AI画像検出識別

53.5K

Mmstar

MMStarは、大規模視覚言語モデルのマルチモーダル能力を評価することを目的としたベンチマークセットです。厳選された1500個の視覚言語サンプルを含み、6つのコア能力と18の細分化された次元を網羅しています。各サンプルは、人間のレビューを経て、視覚的依存性を確保し、データ漏洩を最小限に抑え、高度なマルチモーダル能力を必要とする問題に焦点を当てています。従来の精度指標に加えて、MMStarはデータ漏洩とマルチモーダル訓練による実際のパフォーマンス向上を測定するための2つの新しい指標を提案しています。研究者はMMStarを使用して、複数のタスクにおける視覚言語モデルのマルチモーダル能力を評価し、新しい指標を活用してモデルに潜む潜在的な問題を発見することができます。

AIモデル評価

52.4K

Minigemini

Mini-Geminiは、2Bから34Bパラメーターの様々なサイズを持つ、密集型およびMoE構造の大規模言語モデルです。画像の理解、推論、生成能力を備えたマルチモーダル視覚言語モデルです。LLaVAを基盤とし、2つの視覚エンコーダを用いて低解像度と高解像度の視覚埋め込みを生成します。高解像度領域と低解像度視覚クエリ間でパッチレベルの情報マイニングを行い、テキストと画像を融合することで、理解と生成タスクを実行します。COCO、GQA、OCR-VQA、VisualGenomeなど、複数の視覚理解ベンチマークに対応しています。

AI画像生成

152.9K

Spatialvlm

SpatialVLMは、Google DeepMindが開発した視覚言語モデルであり、空間関係の理解と推論が可能です。大規模合成データによる訓練を通じて、人間と同様に直感的な定量的空間推論能力を獲得しました。これにより、空間VQAタスクにおける性能が向上するだけでなく、連鎖的空間推論やロボット制御など、下流タスクへの新たな可能性も拓きます。

AIモデル

57.1K

Mousi

MouSiは、現在の巨大視覚言語モデル(VLMs)が直面する課題を解決することを目的とした、多モーダル視覚言語モデルです。個々の視覚エンコーダの能力を統合専門家技術によって協調させ、画像テキストマッチング、OCR、画像セグメンテーションなどを含みます。本モデルは、異なる視覚専門家からの出力を統合的に処理するための融合ネットワークを導入し、画像エンコーダと事前学習済みLLMs間のギャップを埋めます。さらに、MouSiは位置エンコーディングの無駄と長さの制限の問題を効果的に解決するための様々な位置エンコーディングスキームを検討しています。実験結果によると、複数の専門家を持つVLMsは、単独の視覚エンコーダよりも優れた性能を示し、統合する専門家が増えるにつれて顕著な性能向上を実現します。

AIモデル

54.4K

- 1

- 2

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

38.9K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.4K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

38.9K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.4K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M