Mmstar

紹介 :

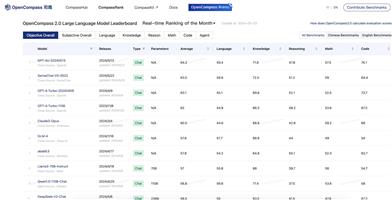

MMStarは、大規模視覚言語モデルのマルチモーダル能力を評価することを目的としたベンチマークセットです。厳選された1500個の視覚言語サンプルを含み、6つのコア能力と18の細分化された次元を網羅しています。各サンプルは、人間のレビューを経て、視覚的依存性を確保し、データ漏洩を最小限に抑え、高度なマルチモーダル能力を必要とする問題に焦点を当てています。従来の精度指標に加えて、MMStarはデータ漏洩とマルチモーダル訓練による実際のパフォーマンス向上を測定するための2つの新しい指標を提案しています。研究者はMMStarを使用して、複数のタスクにおける視覚言語モデルのマルチモーダル能力を評価し、新しい指標を活用してモデルに潜む潜在的な問題を発見することができます。

ターゲットユーザー :

MMStarは主に、大規模視覚言語モデルのマルチモーダルタスクにおける能力を評価?分析するために使用され、モデルの潜在的な問題を発見し、将来のモデル改良の指針となります。

使用シナリオ

研究者はMMStarを使用して、自身で訓練した視覚言語モデルの様々な視覚言語タスクにおけるパフォーマンスを評価できます。

モデル開発者はMMStarを使用して、自身のモデルに存在するデータ漏洩の問題を発見し、適切な対策を講じることができます。

ベンチマークの結果は、既存の視覚言語モデルをさらに改良するための指針と啓発となります。

製品特徴

1500個の高品質な視覚言語サンプルを含む

6つのコア能力と18の細分化された次元を網羅

人間のレビューにより視覚的依存性を確保し、データ漏洩を最小限に抑える

マルチモーダル能力向上とデータ漏洩の2つの新しい指標を提案

16種類の最先端視覚言語モデルをベンチマーク

おすすめAI製品

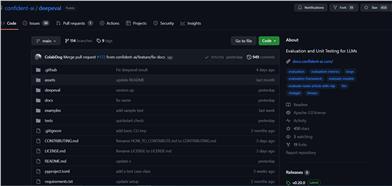

Deepeval

DeepEvalは、LLMが問題に対する回答を評価するための多角的な指標を提供し、回答が関連性があり、一貫性があり、偏りや有害な表現を含まないことを保証します。CI/CDパイプラインとの統合も容易で、機械学習エンジニアはLLMアプリケーションの改善に伴うパフォーマンスの向上を迅速に評価?検証できます。DeepEvalはPythonに優しいオフライン評価方法を提供し、パイプラインの運用準備を確実にします。それはまさに「パイプラインのためのPytest」と言えるもので、テストの通過と同じくらいシンプルで直接的な方法で、生産と評価パイプラインのプロセスを実現します。

AIモデル評価

158.7K

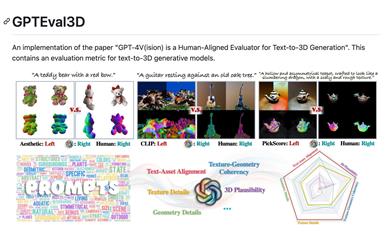

Gpteval3d

GPTEval3Dは、GPT-4Vを基盤としたオープンソースの3D生成モデル評価ツールです。テキストから3Dモデルを生成するモデルを自動的に評価し、ELOスコアを算出、既存モデルとの比較ランキングを提供します。シンプルで使いやすい設計となっており、ユーザーによるカスタム評価データセットもサポート。GPT-4Vの評価能力を最大限に活かし、3D生成タスク研究における強力なツールとなります。

AIモデル評価

74.0K