Qwen2.5 Coder 0.5B Instruct GPTQ Int8

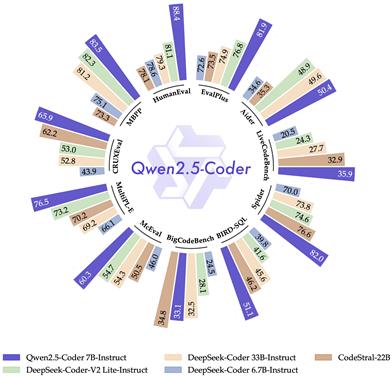

Qwen2.5-Coderは、コード生成、コード推論、コード修正に特化したQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンで訓練されており、コード生成、推論、修正能力が大幅に向上しています。Qwen2.5-Coder-32Bは、現在最も高度なオープンソースコード大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。さらに、Qwen2.5-Coderはコードエージェントなど、現実世界のアプリケーションに包括的な基盤を提供し、コーディング能力の向上に加え、数学や汎用能力の面でも優位性を維持しています。

コードアシスタント

49.4K

Qwen2.5 Coder 0.5B Instruct GPTQ Int4

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、5.5兆個のソースコード、テキストコードベース、合成データなどを用いてトレーニングされており、現在、オープンソースのコード言語モデルにおける最新技術となっています。このモデルは、プログラミング能力においてGPT-4oに匹敵するだけでなく、数学および一般的な能力においても優位性を維持しています。Qwen2.5-Coder-0.5B-Instruct-GPTQ-Int4モデルは、GPTQで量子化された4ビットの命令調整モデルであり、因果言語モデル、事前トレーニングと事後トレーニング、transformersアーキテクチャなどの特徴を備えています。

コードアシスタント

46.4K

Qwen2.5 Coder 0.5B Instruct GGUF

Qwen2.5-Coderは、コード生成、コード推論、コード修正に特化したQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに開発されたQwen2.5-Coder-32Bは、現在最先端のオープンソースコード言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。コードエージェントなどの実際のアプリケーションにおいて、コーディング能力の向上だけでなく、数学や汎用能力の優位性も維持することで、より包括的な基盤を提供します。

コード推論

50.0K

Qwen2.5 Coder 0.5B Instruct AWQ

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。Qwen2.5の強力な能力を基盤とし、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンに拡張トレーニングすることで、Qwen2.5-Coder-32Bは現在最先端のオープンソースコードLLMとなり、そのコーディング能力はGPT-4oに匹敵します。このモデルはAWQ量子化された4ビット指令調整済み0.5Bパラメータバージョンであり、因果言語モデル、事前学習と事後学習、Transformersアーキテクチャなどの特徴を備えています。

コード推論

45.5K

Qwen2.5 Coder 1.5B Instruct GPTQ Int4

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、5.5兆個のソースコード、テキストコード関連付け、合成データなどを含むトレーニングを行い、現在、オープンソースのコード言語モデルの中でもトップクラスの実力を誇り、そのコーディング能力はGPT-4に匹敵します。さらに、コードエージェントなど、より包括的な現実世界のアプリケーション基盤も備えており、コーディング能力の向上だけでなく、数学や汎用能力における優位性も維持しています。

コード推論

46.4K

Qwen2.5 Coder 1.5B Instruct GPTQ Int8

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、5.5兆個のソースコード、テキストコード関連付け、合成データなどを用いたトレーニングにより、現在のオープンソースコード言語モデルの中でもトップクラスの実力を誇ります。プログラミング能力の向上に加え、数学や汎用的な能力も維持しています。

コード推論

46.6K

Qwen2.5 Coder 1.5B Instruct GGUF

Qwen2.5-Coderは、コード生成、コード推論、コード修正のために設計されたQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに、トレーニングトークンを5.5兆に増やし、ソースコード、テキストコードベース、合成データなどを含めることで、Qwen2.5-Coder-32Bは現在最先端のオープンソースコード大規模言語モデルとなり、そのコーディング能力はGPT-4oに匹敵します。このモデルは1.5Bパラメーターの命令微調整バージョンで、GGUF形式を採用し、因果言語モデル、事前トレーニングと事後トレーニング段階、Transformersアーキテクチャなどの特徴を備えています。

コード推論

57.4K

Qwen2.5 Coder 1.5B Instruct AWQ

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、推論、修正のために設計されています。強力なQwen2.5をベースとしており、5.5兆個のソースコード、テキストコードベース、合成データなどを用いてトレーニングされたため、コード能力においてオープンソースコードLLMの最新レベルに達しています。コーディング能力の向上だけでなく、数学や一般的な能力における優位性も維持しています。

コード推論

45.8K

Qwen2.5 Coder 3B Instruct GPTQ Int8

Qwen2.5-Coder-3B-Instruct-GPTQ-Int8は、Qwen2.5-Coderシリーズの大規模言語モデルの一種であり、コード生成、コード推論、コード修正に特化して最適化されています。このモデルはQwen2.5をベースとしており、ソースコード、テキストコード関連付け、合成データなどを含む5.5兆個のトークンで学習されています。Qwen2.5-Coder-32Bは現在最先端のオープンソースコード大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。このモデルは、コードエージェントなどの現実世界のアプリケーションに、より包括的な基盤を提供し、コーディング能力を高めるだけでなく、数学および一般的な能力における優位性も維持しています。

コード推論

46.1K

Qwen2.5 Coder 3B Instruct GPTQ Int4

Qwen2.5-Coderは、コード生成、推論、修正のために設計されたQwen大規模言語モデルの最新シリーズです。Qwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンまでトレーニングトークンを拡張しました。Qwen2.5-Coder-32Bは、現在オープンソースのコードLLMの中でトップクラスであり、そのコーディング能力はGPT-4oに匹敵します。このモデルは、GPTQ量子化された4ビット命令微調整済み3BパラメーターQwen2.5-Coderモデルで、因果言語モデル、事前トレーニングと事後トレーニング段階、transformersアーキテクチャなどの特徴があります。

コード推論

46.9K

Qwen2.5 Coder 3B Instruct GGUF

Qwen2.5-Coderは、コード生成、コード推論、コード修正に特化したQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンでトレーニングされました。Qwen2.5-Coder-32Bは、現在最先端のオープンソースコード大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。このモデルは、コードエージェントなど、実践的なアプリケーションにおいてより包括的な基盤を提供し、コーディング能力を高めると同時に、数学や汎用能力における優位性を維持しています。

コード推論

45.3K

Qwen2.5 Coder 14B Instruct AWQ

Qwen2.5-Coderは、0.5億から32億パラメータまでの様々なモデルサイズを備えた、コード特化型の巨大言語モデルシリーズです。異なる開発者のニーズに対応します。コード生成、コード推論、コード修正において顕著な性能向上を達成しており、強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンで学習されています。Qwen2.5-Coder-32Bは、現在最先端のオープンソースコード生成巨大言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。さらに、最大128Kトークンのロングコンテキストをサポートし、AWQ 4-bit量子化技術を採用することで、モデルの効率性と性能を向上させています。

コード推論

50.5K

Qwen2.5 Coder 32B Instruct GPTQ Int4

Qwen2.5-Coder-32B-Instruct-GPTQ-Int4は、Qwen2.5をベースとした32億5千万パラメーターのコード生成大規模言語モデルであり、長文処理に対応し、最大128Kトークンをサポートします。コード生成、コード推論、コード修正において顕著な性能向上を実現しており、現在オープンソースのコード言語モデルの中でもトップクラスです。コーディング能力の強化に加え、数学や一般能力においても優れた性能を維持しています。

コード推論

46.1K

Qwen2.5 Coder 32B Instruct GGUF

Qwen2.5-Coderはコード生成に特化したモデルであり、コード生成などの分野で顕著な性能向上を実現しています。パラメータ規模は多様で、量子化にも対応しています。無料であり、開発者の効率と品質向上を目的としています。

コード推論

50.8K

Qwen2.5 Coder 32B Instruct AWQ

Qwen2.5-Coderは、コード生成に最適化された一連の大規模言語モデルです。0.5億、1.5億、3億、7億、14億、32億パラメータの6つの主要なモデルサイズを網羅し、様々な開発者のニーズに対応します。Qwen2.5-Coderは、コード生成、コード推論、コード修正において顕著な性能向上を実現しています。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンでトレーニングされ、現在最先端のオープンソースコードLLMとなっています。そのコーディング能力はGPT-4oに匹敵します。さらに、Qwen2.5-Coderはより包括的な基盤を提供し、現実世界のコードエージェントなどのアプリケーションシナリオに適しています。

コード推論

48.3K

Qwen2.5 Coder 0.5B Instruct

Qwen2.5-Coderは、コード生成、コード推論、コード修正に特化したQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンに拡張トレーニングを行い、Qwen2.5-Coder-32Bは現在最先端のオープンソースコードLLMとなり、そのコーディング能力はGPT-4oに匹敵します。このモデルはコーディング能力を向上させただけでなく、数学や一般能力における優位性も維持しており、コードエージェントなどの実用アプリケーションに、より包括的な基盤を提供します。

コードアシスタント

45.8K

Qwen2.5 Coder 0.5B

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンを追加してトレーニングすることで、コーディング能力を大幅に向上させました。Qwen2.5-Coder-32Bは、現在最先端のオープンソースコード大規模言語モデルであり、コーディング能力はGPT-4oに匹敵します。さらに、Qwen2.5-Coderは、コード代理などの実際的な用途のためのより包括的な基盤を提供し、コーディング能力を高めるだけでなく、数学および一般的な能力における優位性も維持しています。

コードアシスタント

50.8K

Qwen2.5 Coder 1.5B

Qwen2.5-Coder-1.5Bは、Qwen2.5-Coderシリーズの大規模言語モデルであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5を基盤とし、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンに拡張トレーニングすることで、現在のオープンソースコードLLMの中でもトップクラスの実力を誇り、コーディング能力はGPT-4oに匹敵します。さらに、数学と汎用能力も強化されており、コードエージェントなどの実際的なアプリケーションに、より包括的な基盤を提供します。

コードアシスタント

52.4K

Qwen2.5 Coder 1.5B Instruct

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。Qwen2.5の強力な能力を基盤とし、5.5兆個のソースコード、テキストコードベース、合成データなどを用いてトレーニングされています。現在、オープンソースのコード生成言語モデルの中でもトップクラスであり、コーディング能力はGPT-4oに匹敵します。コーディング能力の向上に加え、数学や一般的な能力においても優れており、コードエージェントなどの実用アプリケーションに包括的な基盤を提供します。

コードアシスタント

48.3K

Qwen2.5 Coder 3B

Qwen2.5-Coder-3Bは、Qwen2.5-Coderシリーズの大規模言語モデルであり、コード生成、推論、修正に特化しています。強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンで追加トレーニングを行い、コード生成、推論、修正において著しい改善を実現しました。Qwen2.5-Coder-32Bは現在最先端のオープンソースコード大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。さらに、Qwen2.5-Coder-3Bはコードエージェントなど、現実世界のアプリケーションに包括的な基盤を提供し、コーディング能力の向上に加え、数学や一般的な能力における優位性も維持しています。

コードアシスタント

62.7K

Qwen2.5 Coder 3B Instruct

Qwen2.5-Coderは、Qwen大規模言語モデルの最新シリーズであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンにトレーニングデータを増やすことで、コード生成、推論、修正能力を大幅に向上させました。Qwen2.5-Coder-3Bは、このシリーズの1つのモデルであり、30.9億パラメータ、36層、16個のAttentionヘッド(Q)と2個のAttentionヘッド(KV)、最大32,768トークンのコンテキスト長を備えています。このモデルは、現在オープンソースのコードLLMの中でもトップクラスであり、コーディング能力はGPT-4oに匹敵し、開発者にとって強力なコード支援ツールとなります。

コードアシスタント

46.1K

Qwen2.5 Coder 7B

Qwen2.5-Coder-7Bは、Qwen2.5をベースとした大規模言語モデルであり、コード生成、コード推論、コード修正に特化しています。5.5兆トークンを超えるトレーニングデータ(ソースコード、テキストコード接地、合成データなど)を用いて学習されており、現在公開されているコード言語モデルの最新成果です。プログラミング能力においてGPT-4oと同等のパフォーマンスを示すだけでなく、数学能力や一般的な能力においても優れており、最大128Kトークンの長文コンテキストにも対応しています。

コードアシスタント

47.5K

Qwen2.5 Coder 7B Instruct

Qwen2.5-Coder-7B-Instructは、Qwen2.5-Coderシリーズのコード特化型大規模言語モデルです。0.5億、1.5億、30億、70億、140億、320億パラメータの6種類の主要なモデルサイズを網羅し、様々な開発者のニーズに対応します。コード生成、コード推論、コード修正において顕著な性能向上を実現しており、強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンで学習されています。Qwen2.5-Coder-32Bは現在最先端のオープンソースコードLLMであり、そのコーディング能力はGPT-4oに匹敵します。さらに、最大128Kトークンの長文コンテキストに対応し、コードエージェントのような実際的なアプリケーションに包括的な基盤を提供します。

コードアシスタント

47.7K

Qwen2.5 Coder 技術レポート

Qwen2.5-Coderシリーズは、Qwen2.5アーキテクチャに基づくコード特化型モデルで、Qwen2.5-Coder-1.5BとQwen2.5-Coder-7Bの2つのモデルが含まれています。これらのモデルは、5.5兆トークンを超える大規模なコーパスで継続的に事前学習されており、精緻なデータクレンジング、拡張可能な合成データ生成、バランスの取れたデータミックスによって、汎用性を維持しながら、印象的なコード生成能力を発揮します。Qwen2.5-Coderは、コード生成、補完、推論、修正を含むさまざまなコード関連タスクにおいて、10以上のベンチマークテストで最先端の性能を達成し、同規模の他の大規模モデルを常に凌駕しています。このシリーズの公開は、コードインテリジェンス研究の限界を押し広げるだけでなく、そのライセンスによって、現実世界のアプリケーションにおけるより広範な採用を促進します。

コードアシスタント

62.9K

Qwen2.5 Coder 14B

Qwen2.5-Coder-14Bは、Qwenシリーズのコード専門の大規模言語モデルです。0.5億から32億パラメータまでの様々なモデルサイズを用意しており、開発者の多様なニーズに対応します。コード生成、コード推論、コード修正において顕著な性能向上を実現しており、強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンで学習されています。Qwen2.5-Coder-32Bは、現在最先端のオープンソースコードLLMであり、そのコーディング能力はGPT-4oに匹敵します。さらに、コードエージェントなどの現実世界のアプリケーションに包括的な基盤を提供し、コーディング能力の強化に加え、数学や汎用能力における強みも維持しています。最大128Kトークンのロングコンテキストに対応しています。

コードアシスタント

48.6K

Qwen2.5 Coder 14B Instruct

Qwen2.5-Coder-14B-Instructは、Qwen2.5-Coderシリーズの大規模言語モデルであり、コード生成、コード推論、コード修正に特化しています。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンまで拡張トレーニングを行い、現在オープンソースのコードLLMにおける最新技術となっています。コーディング能力の向上だけでなく、数学や汎用能力の優位性も維持しており、最大128Kトークンのロングコンテキストにも対応しています。

コードアシスタント

45.3K

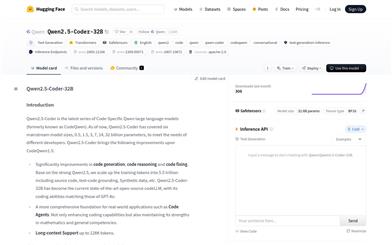

Qwen2.5 Coder 32B

Qwen2.5-Coder-32Bは、Qwen2.5をベースとしたコード生成モデルで、32億個のパラメータを持ちます。これは現在、オープンソースのコード言語モデルの中で最大規模のモデルの一つです。コード生成、コード推論、コード修正において顕著な改善が見られ、最大128Kトークンの長文処理に対応できるため、コードエージェントなどの実用的なアプリケーションシナリオに適しています。数学や一般的な能力も維持しており、長文処理にも対応するため、開発者にとって強力なコード開発支援ツールとなります。

コードアシスタント

47.7K

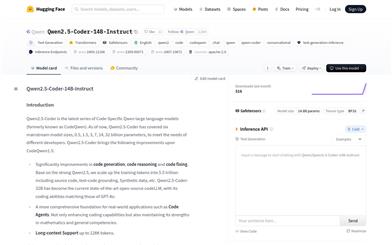

Qwen2.5 Coder 32B Instruct

Qwen2.5-Coderは、コード生成用に設計されたQwen大規模言語モデルシリーズで、0.5、1.5、3、7、14、32億パラメータの6つの主要なモデルサイズがあり、様々な開発者のニーズに対応します。このモデルは、コード生成、コード推論、コード修正において顕著な改善が見られ、強力なQwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンでトレーニングされました。Qwen2.5-Coder-32Bは、現在最も高度なオープンソースのコード生成大規模言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。コーディング能力の向上に加え、数学や汎用的な能力も維持しており、最大128Kトークンのロングコンテキストにも対応しています。

コードアシスタント

50.2K

高品質新製品

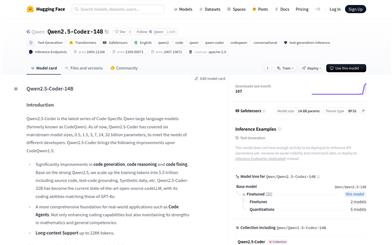

Qwen2.5 Coder

Qwen2.5-CoderはQwen2.5オープンソースファミリーの一員であり、コード生成、推論、修正などのタスクに特化しています。大規模なコードトレーニングデータの拡張により、コード能力が向上し、同時に数学および一般的な能力も維持されています。92種類のプログラミング言語に対応し、コード関連タスクにおいて著しい性能向上を実現しています。Qwen2.5-CoderはApache 2.0ライセンスを採用し、コードインテリジェンスの応用を加速することを目指しています。

AIコードアシスタント

55.5K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

44.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

42.8K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

41.4K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

41.7K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

43.1K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

40.6K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M