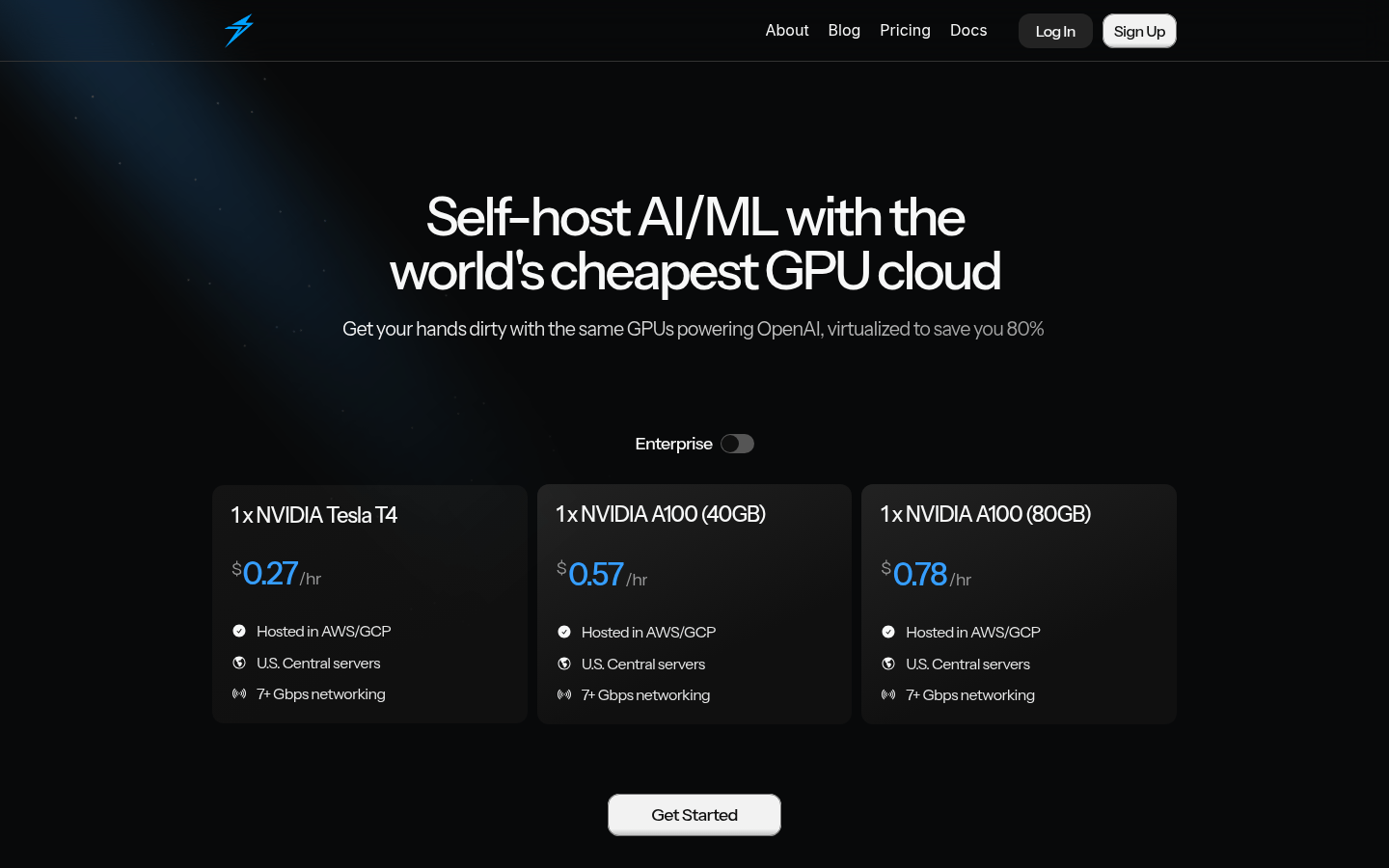

Thunder Compute

简介 :

Thunder Compute是一个专注于AI/ML开发的GPU云服务平台,通过虚拟化技术,帮助用户以极低的成本使用高性能GPU资源。其主要优点是价格低廉,相比传统云服务提供商可节省高达80%的成本。该平台支持多种主流GPU型号,如NVIDIA Tesla T4、A100等,并提供7+ Gbps的网络连接,确保数据传输的高效性。Thunder Compute的目标是为AI开发者和企业降低硬件成本,加速模型训练和部署,推动AI技术的普及和应用。

需求人群 :

该产品主要面向AI开发者、数据科学家、机器学习工程师以及需要高性能计算资源的企业。对于那些希望降低硬件成本、快速搭建AI开发环境并加速模型训练和部署的用户来说,Thunder Compute是一个理想的选择。其低廉的价格和灵活的部署方式,尤其适合预算有限的初创公司和研究团队。

使用场景

用户@userdotrandom表示,通过Thunder Compute快速创建实例,安装并运行Ollama模板,过程非常简单。

Jung Hoon Son博士表示,使用A100 GPU转录41小时视频仅花费6美元。

KronosAI的CEO Yujie Huang表示,与AWS相比,使用Thunder Compute为工程师设置环境更简单,且节省了大量成本。

产品特色

提供多种高性能GPU型号选择,满足不同AI/ML开发需求。

通过虚拟化技术实现成本优化,相比传统云服务可节省80%的成本。

支持快速创建GPU实例,一键部署常用工具(如Ollama、Comfy-ui等)。

提供简单易用的用户界面和命令行工具,方便用户创建、管理和监控实例。

7+ Gbps的高速网络连接,确保数据传输的高效性和稳定性。

实例模板功能,简化AI/ML开发环境的搭建过程。

支持在AWS/GCP等主流云平台托管,提供灵活的部署选项。

提供详细的文档和社区支持,帮助用户快速上手和解决问题。

使用教程

访问Thunder Compute官网,注册并登录账户。

选择合适的GPU型号和配置,创建GPU实例。

通过命令行工具或控制台连接到创建的实例。

使用实例模板快速安装和配置所需的AI工具(如Ollama等)。

开始运行模型训练或AI开发任务。

通过控制台或命令行工具监控实例运行状态。

根据需要调整实例配置或扩展资源。

完成任务后,释放实例资源以节省成本。

精选AI产品推荐

国外精选

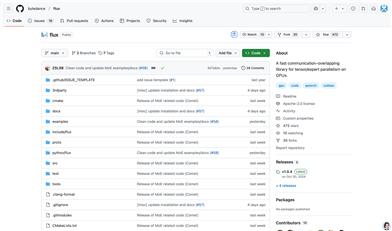

Ollama

Ollama是一款本地大语言模型工具,让用户能够快速运行Llama 2、Code Llama和其他模型。用户可以自定义和创建他们自己的模型。Ollama目前支持macOS和Linux,Windows版本即将推出。该产品定位于为用户提供本地化的大语言模型运行环境,以满足用户个性化的需求。

模型训练与部署

301.1K

中文精选

Kimi K1.5

Kimi k1.5 是由 MoonshotAI 开发的多模态语言模型,通过强化学习和长上下文扩展技术,显著提升了模型在复杂推理任务中的表现。该模型在多个基准测试中达到了行业领先水平,例如在 AIME 和 MATH-500 等数学推理任务中超越了 GPT-4o 和 Claude Sonnet 3.5。其主要优点包括高效的训练框架、强大的多模态推理能力以及对长上下文的支持。Kimi k1.5 主要面向需要复杂推理和逻辑分析的应用场景,如编程辅助、数学解题和代码生成等。

模型训练与部署

294.5K