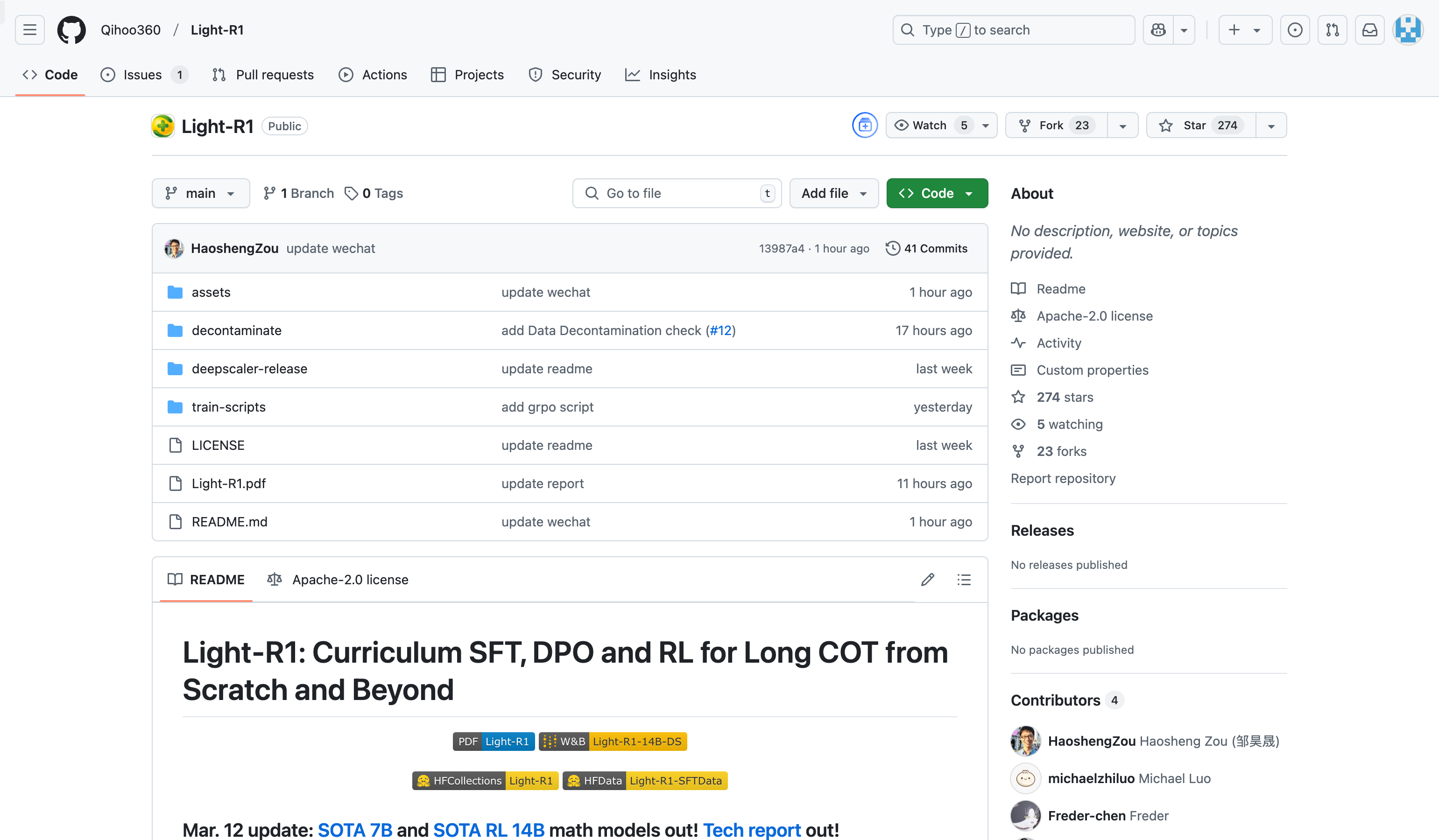

Light R1

简介 :

Light-R1 是一个由 Qihoo360 开发的开源项目,旨在通过课程式监督微调(SFT)、直接偏好优化(DPO)和强化学习(RL)训练长链推理模型。该项目通过去污染数据集和高效的训练方法,实现了从零开始的长链推理能力。其主要优点包括开源的训练数据、低成本的训练方式以及在数学推理领域的卓越性能。项目背景基于当前长链推理模型的训练需求,旨在提供一种透明且可复现的训练方法。项目目前免费开源,适合研究机构和开发者使用。

需求人群 :

目标受众包括人工智能研究者、机器学习工程师以及对长链推理模型感兴趣的开发者。该项目适合那些希望在有限资源下训练高性能长链推理模型的研究团队和企业,同时也为开源社区提供了宝贵的参考。

使用场景

使用 Light-R1-7B-DS 模型在 AIME24 测试中达到 59.1% 的准确率,显著优于其他同类模型。

通过课程式 SFT 和 DPO 训练,Light-R1-32B 在 AIME24 上达到 76.6% 的准确率,超越了 DeepSeek-R1-Distill-Qwen-32B。

开发者可以基于开源的训练代码和数据集,快速复现 Light-R1 的训练过程,并进行定制化改进。

产品特色

提供从零开始的长链推理训练方法,无需依赖预训练的长链推理能力

开源完整的训练数据集和代码,便于研究者复现和改进

采用课程式学习,通过 SFT 和 DPO 提升模型性能

支持强化学习(RL)训练,进一步优化模型表现

在数学推理领域表现出色,特别是在 AIME24 和 AIME25 等基准测试中

使用教程

1. 克隆 Light-R1 项目代码到本地。

2. 下载并安装项目依赖的 Python 包。

3. 使用开源的训练数据集运行 SFT 训练脚本。

4. 在 SFT 基础上运行 DPO 训练脚本,进一步优化模型。

5. 使用训练好的模型进行推理或继续进行 RL 训练。

精选AI产品推荐

Elicit

Elicit是一款能够以超人速度分析研究论文的AI助手。它可以自动完成繁琐的研究任务,如论文摘要、数据提取和综合研究发现。用户可以搜索相关论文、获取一句话摘要、从论文中提取详细信息并进行整理、寻找主题和概念等。Elicit的准确度高,使用方便,已受到广大研究者的信赖和好评。

研究工具

627.6K

中文精选

Findin AI

Findin AI 是一款旨在通过人工智能技术全面提速学术研究工作流的工具。它通过文献筛选、论文阅读、笔记摘录、主题研究、文献综述和学术写作等功能,帮助用户高效管理文献和知识,提升研究效率。产品利用AI技术,如自动总结、一键获取参考文献、文献问答等,大幅减少研究过程中的重复劳动,使研究者能够专注于创新和深度思考。

研究工具

300.0K