SWE Bench Verified

简介 :

SWE-bench Verified是OpenAI发布的一个经过人工验证的SWE-bench子集,旨在更可靠地评估AI模型解决现实世界软件问题的能力。它通过提供代码库和问题描述,挑战AI生成解决所描述问题的补丁。这个工具的开发是为了提高模型自主完成软件工程任务的能力评估的准确性,是OpenAI准备框架中中等风险级别的关键组成部分。

需求人群 :

SWE-bench Verified主要面向AI研究者和软件开发者,他们需要评估和理解大型语言模型在软件工程任务中的表现和能力。通过这个工具,用户可以更准确地衡量AI模型的编程能力和问题解决技巧,进而优化和提升模型的性能。

使用场景

研究者使用SWE-bench Verified来测试和比较不同AI模型在解决编程问题上的表现。

教育机构利用该工具作为教学辅助,帮助学生理解AI在编程领域的应用。

软件开发团队使用SWE-bench Verified来评估和选择最适合其项目的AI编程助手。

产品特色

从GitHub问题中提取并创建测试样本

提供FAIL_TO_PASS和PASS_TO_PASS测试以验证代码的正确性

人工注释筛选,确保测试样本的质量和问题描述的明确性

使用容器化的Docker环境简化评估过程,提高可靠性

与SWE-bench作者合作开发新的评估工具

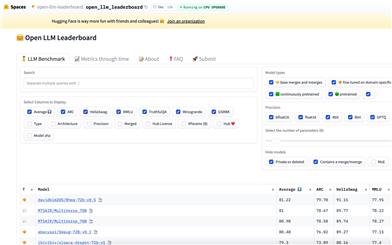

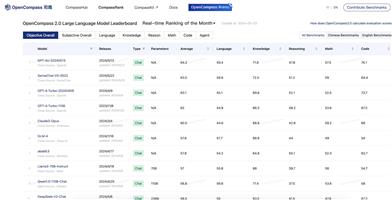

GPT-4o在SWE-bench Verified上的表现显著提高,解决了33.2%的样本

使用教程

步骤一:下载并安装SWE-bench Verified工具。

步骤二:准备或选择一个GitHub代码库以及相关的问题描述。

步骤三:使用SWE-bench Verified提供的环境和测试框架对AI模型进行评估。

步骤四:运行FAIL_TO_PASS和PASS_TO_PASS测试,检查AI模型生成的补丁是否解决了问题并且没有破坏现有功能。

步骤五:根据测试结果分析AI模型的性能,并据此进行模型优化。

步骤六:将评估结果和反馈整合到模型训练和迭代过程中,以提高模型的软件工程能力。