MLE Bench

简介 :

MLE-bench是由OpenAI推出的一个基准测试,旨在衡量AI代理在机器学习工程方面的表现。该基准测试汇集了75个来自Kaggle的机器学习工程相关竞赛,形成了一套多样化的挑战性任务,测试了训练模型、准备数据集和运行实验等现实世界中的机器学习工程技能。通过Kaggle公开的排行榜数据,为每项竞赛建立了人类基准。使用开源代理框架评估了多个前沿语言模型在该基准上的表现,发现表现最佳的设置——OpenAI的o1-preview配合AIDE框架——在16.9%的竞赛中至少达到了Kaggle铜牌的水平。此外,还研究了AI代理的各种资源扩展形式以及预训练污染的影响。MLE-bench的基准代码已经开源,以促进未来对AI代理机器学习工程能力的理解。

需求人群 :

MLE-bench的目标受众是机器学习工程师、数据科学家和AI研究人员。这些专业人员可以通过MLE-bench来评估和比较不同AI代理在机器学习工程任务上的表现,从而选择最适合他们项目的AI工具。同时,研究人员可以通过该基准测试来进一步理解AI代理在机器学习工程领域的能力,推动相关技术的发展。

使用场景

机器学习工程师使用MLE-bench来测试和评估不同AI模型在特定任务上的性能。

数据科学家利用MLE-bench来比较不同AI代理在数据预处理和模型训练上的效果。

AI研究人员使用MLE-bench来研究和改进AI代理在机器学习工程任务中的资源利用效率。

产品特色

评估AI代理在机器学习工程任务上的性能

提供75个来自Kaggle的多样化机器学习工程竞赛任务

使用Kaggle排行榜数据建立人类基准

开源代理框架评估前沿语言模型

研究AI代理的资源扩展和预训练污染影响

开源基准代码,促进未来研究

使用教程

步骤1:访问MLE-bench的官方网站或GitHub页面。

步骤2:阅读关于MLE-bench的介绍和使用方法。

步骤3:下载并安装必要的软件和依赖,如开源代理框架。

步骤4:根据指南设置并运行基准测试,评估你的AI代理或模型。

步骤5:分析测试结果,了解你的AI代理在机器学习工程任务上的表现。

步骤6:根据需要调整AI代理的配置或优化模型,以提高其在基准测试中的表现。

步骤7:参与社区讨论,分享你的经验和发现,或寻求帮助。

精选AI产品推荐

Deepeval

DeepEval提供了不同方面的度量来评估LLM对问题的回答,以确保答案是相关的、一致的、无偏见的、非有毒的。这些可以很好地与CI/CD管道集成在一起,允许机器学习工程师快速评估并检查他们改进LLM应用程序时,LLM应用程序的性能是否良好。DeepEval提供了一种Python友好的离线评估方法,确保您的管道准备好投入生产。它就像是“针对您的管道的Pytest”,使生产和评估管道的过程与通过所有测试一样简单直接。

AI模型评测

171.9K

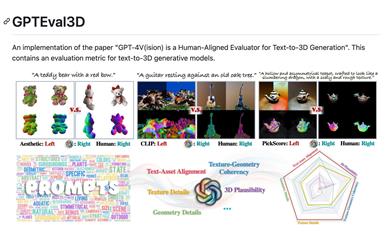

Gpteval3d

GPTEval3D是一个开源的3D生成模型评价工具,基于GPT-4V实现了对文本到3D生成模型的自动评测。它可以计算生成模型的ELO分数,并与现有模型进行对比排名。该工具简单易用,支持用户自定义评测数据集,可以充分发挥GPT-4V的评测效果,是研究3D生成任务的有力工具。

AI模型评测

79.5K