Datalearner預訓練模型平臺

該平臺是一個專注於AI預訓練模型的資源平臺,整合了大量不同類型、規模和應用場景的預訓練模型。其重要性在於為AI開發者和研究人員提供了便捷的模型獲取渠道,降低了模型開發的門檻。主要優點包括模型分類細緻、多維度篩選功能強大、信息展示詳細且提供智能推薦。產品背景是隨著AI技術的發展,對預訓練模型的需求日益增長,平臺應運而生。平臺主要定位為AI模型資源平臺,部分模型免費商用,部分可能需要付費,具體價格因模型而異。

AI模型

40.3K

Magma

Magma 是微軟研究團隊推出的一個多模態基礎模型,旨在通過視覺、語言和動作的結合,實現複雜任務的規劃和執行。它通過大規模的視覺語言數據預訓練,具備了語言理解、空間智能和動作規劃的能力,能夠在 UI 導航、機器人操作等任務中表現出色。該模型的出現為多模態 AI 代理任務提供了一個強大的基礎框架,具有廣泛的應用前景。

智能體

57.7K

MILS

MILS是一個由Facebook Research發佈的開源項目,旨在展示大型語言模型(LLMs)在未經過任何訓練的情況下,能夠處理視覺和聽覺任務的能力。該技術通過利用預訓練的模型和優化算法,實現了對圖像、音頻和視頻的自動描述生成。這一技術突破為多模態人工智能的發展提供了新的思路,展示了LLMs在跨模態任務中的潛力。該模型主要面向研究人員和開發者,為他們提供了一個強大的工具來探索多模態應用。目前該項目是免費開源的,旨在推動學術研究和技術發展。

AI模型

50.8K

Timesfm 2.0 500m Pytorch

TimesFM是一個由Google Research開發的預訓練時間序列預測模型,用於時間序列預測任務。該模型在多個數據集上進行了預訓練,能夠處理不同頻率和長度的時間序列數據。其主要優點包括高性能、可擴展性強以及易於使用。該模型適用於需要準確預測時間序列數據的各種應用場景,如金融、氣象、能源等領域。該模型在Hugging Face平臺上免費提供,用戶可以方便地下載和使用。

AI模型

64.0K

Openemma

OpenEMMA是一個開源項目,復現了Waymo的EMMA模型,提供了一個端到端框架用於自動駕駛車輛的運動規劃。該模型利用預訓練的視覺語言模型(VLMs)如GPT-4和LLaVA,整合文本和前視攝像頭輸入,實現對未來自身路徑點的精確預測,並提供決策理由。OpenEMMA的目標是為研究人員和開發者提供易於獲取的工具,以推進自動駕駛研究和應用。

模型訓練與部署

58.5K

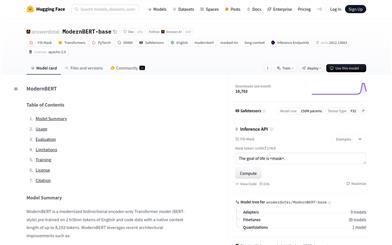

Modernbert Base

ModernBERT-base是一個現代化的雙向編碼器Transformer模型,預訓練於2萬億英文和代碼數據,原生支持長達8192個token的上下文。該模型採用了Rotary Positional Embeddings (RoPE)、Local-Global Alternating Attention和Unpadding等最新架構改進,使其在長文本處理任務中表現出色。ModernBERT-base適用於需要處理長文檔的任務,如檢索、分類和大型語料庫中的語義搜索。模型訓練數據主要為英文和代碼,因此可能在其他語言上的表現會有所降低。

AI模型

52.2K

Syncammaster

SynCamMaster是一種先進的視頻生成技術,它能夠從多樣化的視角同步生成多攝像機視頻。這項技術通過預訓練的文本到視頻模型,增強了視頻內容在不同視角下的動態一致性,對於虛擬拍攝等應用場景具有重要意義。該技術的主要優點包括能夠處理開放世界視頻的任意視角生成,整合6自由度攝像機姿態,並設計了一種漸進式訓練方案,利用多攝像機圖像和單目視頻作為補充,顯著提升了模型性能。

視頻生成

57.1K

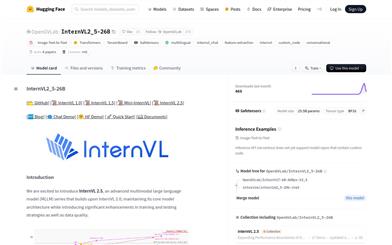

Internvl2 5 26B

InternVL2_5-26B是一個先進的多模態大型語言模型(MLLM),在InternVL 2.0的基礎上,通過引入顯著的訓練和測試策略增強以及數據質量提升,進一步發展而來。該模型保持了其前身的“ViT-MLP-LLM”核心模型架構,並集成了新增量預訓練的InternViT與各種預訓練的大型語言模型(LLMs),例如InternLM 2.5和Qwen 2.5,使用隨機初始化的MLP投影器。InternVL 2.5系列模型在多模態任務中展現出卓越的性能,尤其在視覺感知和多模態能力方面。

AI模型

56.3K

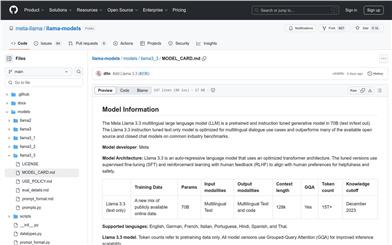

Meta Llama 3.3

Meta Llama 3.3是一個70B參數的多語言大型預訓練語言模型(LLM),專為多語言對話用例優化,並在常見行業基準測試中表現優於許多現有的開源和封閉聊天模型。該模型採用優化的Transformer架構,並使用監督式微調(SFT)和基於人類反饋的強化學習(RLHF)來符合人類的有用性和安全性偏好。

聊天機器人

46.4K

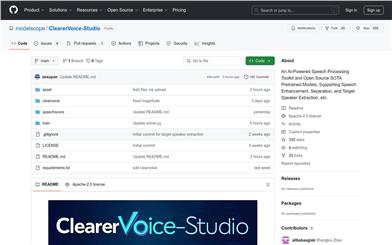

Clearervoice Studio

ClearerVoice-Studio是一個開源的AI驅動語音處理工具包,專為研究人員、開發者和最終用戶設計。它提供了語音增強、語音分離、目標說話人提取等功能,並提供了最新的預訓練模型以及訓練和推理腳本,全部可通過此倉庫訪問。該工具包以其預訓練模型、易用性、全面功能和社區驅動的特點而受到青睞。

開發與工具

159.0K

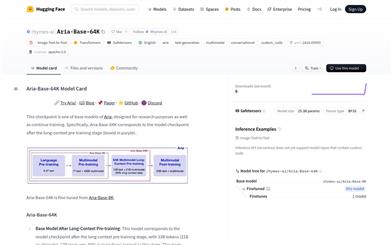

Aria Base 64K

Aria-Base-64K是Aria系列的基礎模型之一,專為研究目的和繼續訓練而設計。該模型在長文本預訓練階段後形成,經過33B個token(21B多模態,12B語言,69%為長文本)的訓練。它適合於長視頻問答數據集或長文檔問答數據集的繼續預訓練或微調,即使在資源有限的情況下,也可以通過短指令調優數據集進行後訓練,並轉移到長文本問答場景。該模型能夠理解多達250張高分辨率圖像或多達500張中等分辨率圖像,並在語言和多模態場景中保持強大的基礎性能。

AI模型

43.3K

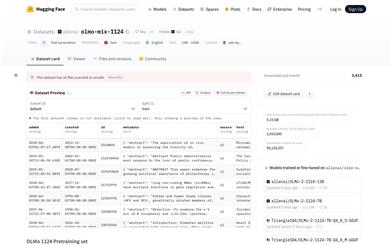

Olmo Mix 1124

allenai/olmo-mix-1124數據集是由Hugging Face提供的一個大規模多模態預訓練數據集,主要用於訓練和優化自然語言處理模型。該數據集包含了大量的文本信息,覆蓋了多種語言,並且可以用於各種文本生成任務。它的重要性在於提供了一個豐富的資源,使得研究人員和開發者能夠訓練出更加精準和高效的語言模型,進而推動自然語言處理技術的發展。

AI模型

44.7K

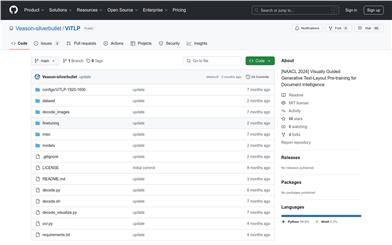

Vitlp

ViTLP是一個視覺引導的生成文本佈局預訓練模型,旨在提高文檔智能處理的效率和準確性。該模型結合了OCR文本定位和識別功能,能夠在文檔圖像上進行快速準確的文本檢測和識別。ViTLP模型的預訓練版本ViTLP-medium(380M參數)在計算資源和預訓練數據集規模的限制下,提供了一個平衡的解決方案,既保證了模型的性能,又優化了推理速度和內存使用。ViTLP的推理速度在Nvidia 4090上處理一頁文檔圖像通常在5到10秒內,與大多數OCR引擎相比具有競爭力。

文檔

65.4K

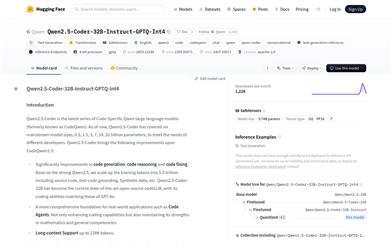

Qwen2.5 Coder 32B Instruct GPTQ Int4

Qwen2.5-Coder-32B-Instruct-GPTQ-Int4是基於Qwen2.5的代碼生成大型語言模型,具有32.5億參數量,支持長文本處理,最大支持128K tokens。該模型在代碼生成、代碼推理和代碼修復方面有顯著提升,是當前開源代碼語言模型中的佼佼者。它不僅增強了編碼能力,還保持了在數學和通用能力方面的優勢。

代碼推理

46.9K

Qwen2.5 Coder 0.5B Instruct

Qwen2.5-Coder是Qwen大型語言模型的最新系列,專注於代碼生成、代碼推理和代碼修復。基於強大的Qwen2.5,通過擴展訓練令牌到5.5萬億,包括源代碼、文本代碼基礎、合成數據等,Qwen2.5-Coder-32B已成為當前最先進的開源代碼LLM,其編碼能力與GPT-4o相匹配。該模型不僅增強了編碼能力,還保持了在數學和通用能力方面的優勢,為實際應用如代碼代理提供了更全面的基礎。

代碼助手

45.0K

Qwen2.5 Coder 3B

Qwen2.5-Coder-3B是Qwen2.5-Coder系列中的一個大型語言模型,專注於代碼生成、推理和修復。基於強大的Qwen2.5,該模型通過增加訓練令牌至5.5萬億,包括源代碼、文本代碼基礎、合成數據等,實現了在代碼生成、推理和修復方面的顯著改進。Qwen2.5-Coder-32B已成為當前最先進的開源代碼大型語言模型,其編碼能力與GPT-4o相匹配。此外,Qwen2.5-Coder-3B還為現實世界的應用提供了更全面的基礎,如代碼代理,不僅增強了編碼能力,還保持了在數學和通用能力方面的優勢。

代碼助手

62.9K

Qwen2.5 Coder Technical Report

Qwen2.5-Coder系列是基於Qwen2.5架構的代碼特定模型,包括Qwen2.5-Coder-1.5B和Qwen2.5-Coder-7B兩個模型。這些模型在超過5.5萬億個token的大規模語料庫上繼續預訓練,並通過精細的數據清洗、可擴展的合成數據生成和平衡的數據混合,展現出令人印象深刻的代碼生成能力,同時保持了通用性。Qwen2.5-Coder在包括代碼生成、補全、推理和修復在內的多種代碼相關任務上取得了超過10個基準測試的最新性能,並且一致性地超越了同等大小的更大模型。該系列的發佈不僅推動了代碼智能研究的邊界,而且通過其許可授權,鼓勵開發者在現實世界的應用中更廣泛地採用。

代碼助手

88.6K

Aya Expanse 8b

Aya Expanse是一個具有高級多語言能力的開放權重研究模型。它專注於將高性能的預訓練模型與Cohere For AI一年的研究成果相結合,包括數據套利、多語言偏好訓練、安全調整和模型合併。該模型是一個強大的多語言大型語言模型,服務於23種語言,包括阿拉伯語、中文(簡體和繁體)、捷克語、荷蘭語、英語、法語、德語、希臘語、希伯來語、印地語、印尼語、意大利語、日語、韓語、波斯語、波蘭語、葡萄牙語、羅馬尼亞語、俄語、西班牙語、土耳其語、烏克蘭語和越南語。

AI模型

45.0K

DTLR

DTLR是一個基於檢測的手寫文本行識別模型,基於DINO-DETR進行改進,用於文本識別和字符檢測。該模型在合成數據上預訓練,然後在真實數據集上進行微調。它對於OCR(光學字符識別)領域具有重要意義,特別是在處理手寫文本時,能夠提高識別的準確性和效率。

AI模型

61.0K

Olmoe

OLMoE是一個完全開放的、最先進的專家混合模型,具有1.3億活躍參數和6.9億總參數。該模型的所有數據、代碼和日誌都已發佈。它提供了論文'OLMoE: Open Mixture-of-Experts Language Models'的所有資源概覽。該模型在預訓練、微調、適應和評估方面都具有重要應用,是自然語言處理領域的一個里程碑。

AI模型

44.7K

Opencity

OpenCity是一個開源的時空基礎模型,專注於交通預測領域。該模型通過整合Transformer架構和圖神經網絡,有效捕捉和標準化交通數據中的複雜時空依賴關係,實現對不同城市環境的零樣本泛化。它在大規模、異構的交通數據集上進行預訓練,學習到豐富、可泛化的表示,能夠無縫應用於多種交通預測場景。

AI模型

56.9K

優質新品

EXAONE 3.0 7.8B Instruct

EXAONE-3.0-7.8B-Instruct是LG AI Research開發的一款具有7.8億參數的雙語(英語和韓語)預訓練生成模型。模型通過8T的精選token進行預訓練,並經過監督式微調和直接偏好優化進行後訓練,展現出與同類大小的開放模型相比極具競爭力的基準性能。

AI模型

46.1K

優質新品

Llama3

Meta Llama 3 是 Meta 推出的最新大型語言模型,旨在為個人、創作者、研究人員和各類企業解鎖大型語言模型的能力。該模型包含從8B到70B參數的不同規模版本,支持預訓練和指令調優。模型通過 GitHub 倉庫提供,用戶可以通過下載模型權重和分詞器進行本地推理。Meta Llama 3 的發佈標誌著大型語言模型技術的進一步普及和應用,具有廣泛的研究和商業潛力。

AI模型

49.4K

Meta Llama 3.1 405B

Meta Llama 3.1-405B 是由 Meta 開發的一系列大型多語言預訓練語言模型,包含8B、70B和405B三種規模的模型。這些模型經過優化的變壓器架構,使用監督式微調(SFT)和強化學習與人類反饋(RLHF)進行調優,以符合人類對幫助性和安全性的偏好。Llama 3.1 模型支持多種語言,包括英語、德語、法語、意大利語、葡萄牙語、印地語、西班牙語和泰語。該模型在多種自然語言生成任務中表現出色,並在行業基準測試中超越了許多現有的開源和封閉聊天模型。

AI模型

96.6K

Vitmatte

ViTMatte是一個基於預訓練純視覺變換器(Plain Vision Transformers, ViTs)的圖像摳圖系統。它利用混合注意力機制和卷積頸部來優化性能與計算之間的平衡,並引入了細節捕獲模塊以補充摳圖所需的細節信息。ViTMatte是首個通過簡潔的適配釋放ViT在圖像摳圖領域潛力的工作,繼承了ViT在預訓練策略、簡潔的架構設計和靈活的推理策略等方面的優勢。在Composition-1k和Distinctions-646這兩個最常用的圖像摳圖基準測試中,ViTMatte達到了最先進的性能,並以較大優勢超越了先前的工作。

AI圖像編輯

54.4K

優質新品

Index 1.9B Pure

Index-1.9B-Pure是Index系列模型中的輕量版本,專為文本生成而設計。它在2.8T的中英文語料上進行了預訓練,與同等級模型相比,在多個評測基準上表現領先。該模型特別過濾了所有指令相關數據,以驗證指令對benchmark的影響,適用於需要高質量文本生成的領域。

AI內容生成

48.0K

優質新品

Index 1.9B Chat

Index-1.9B-Chat是一個基於19億參數的對話生成模型,它通過SFT和DPO對齊技術,結合RAG實現fewshots角色扮演定製,具有較高的對話趣味性和定製性。該模型在2.8T中英文為主的語料上預訓練,並且在多個評測基準上表現領先。

AI聊天機器人

52.2K

優質新品

雅意信息抽取大模型

雅意信息抽取大模型(YAYI-UIE)由中科聞歌算法團隊研發,是一款在百萬級人工構造的高質量信息抽取數據上進行指令微調的模型。它能夠統一訓練信息抽取任務,包括命名實體識別(NER)、關係抽取(RE)和事件抽取(EE),覆蓋了通用、安全、金融、生物、醫療、商業等多個場景的結構化抽取。該模型的開源旨在促進中文預訓練大模型開源社區的發展,並通過開源共建雅意大模型生態。

AI模型

74.5K

Qwen2

Qwen2是一系列經過預訓練和指令調整的模型,支持多達27種語言,包括英語和中文。這些模型在多個基準測試中表現出色,特別是在編碼和數學方面有顯著提升。Qwen2模型的上下文長度支持高達128K個token,適用於處理長文本任務。此外,Qwen2-72B-Instruct模型在安全性方面與GPT-4相當,顯著優於Mistral-8x22B模型。

AI模型

153.7K

國外精選

GLM 4V 9B

GLM-4V-9B是智譜AI推出的新一代預訓練模型,支持1120*1120高分辨率下的中英雙語多輪對話,以及視覺理解能力。在多模態評測中,GLM-4V-9B展現出超越GPT-4-turbo-2024-04-09、Gemini 1.0 Pro、Qwen-VL-Max和Claude 3 Opus的卓越性能。

AI模型

80.9K

- 1

- 2

精選AI產品推薦

中文精選

騰訊混元圖像 2.0

騰訊混元圖像 2.0 是騰訊最新發布的 AI 圖像生成模型,顯著提升了生成速度和畫質。通過超高壓縮倍率的編解碼器和全新擴散架構,使得圖像生成速度可達到毫秒級,避免了傳統生成的等待時間。同時,模型通過強化學習算法與人類美學知識的結合,提升了圖像的真實感和細節表現,適合設計師、創作者等專業用戶使用。

圖片生成

80.6K

國外精選

Lovart

Lovart 是一款革命性的 AI 設計代理,能夠將創意提示轉化為藝術作品,支持從故事板到品牌視覺的多種設計需求。其重要性在於打破傳統設計流程,節省時間並提升創意靈感。Lovart 當前處於測試階段,用戶可加入等候名單,隨時體驗設計的樂趣。

AI設計工具

63.8K

Fastvlm

FastVLM 是一種高效的視覺編碼模型,專為視覺語言模型設計。它通過創新的 FastViTHD 混合視覺編碼器,減少了高分辨率圖像的編碼時間和輸出的 token 數量,使得模型在速度和精度上表現出色。FastVLM 的主要定位是為開發者提供強大的視覺語言處理能力,適用於各種應用場景,尤其在需要快速響應的移動設備上表現優異。

AI模型

51.1K

Keysync

KeySync 是一個針對高分辨率視頻的無洩漏唇同步框架。它解決了傳統唇同步技術中的時間一致性問題,同時通過巧妙的遮罩策略處理表情洩漏和麵部遮擋。KeySync 的優越性體現在其在唇重建和跨同步方面的先進成果,適用於自動配音等實際應用場景。

視頻編輯

48.3K

Manus

Manus 是由 Monica.im 研發的全球首款真正自主的 AI 代理產品,能夠直接交付完整的任務成果,而不僅僅是提供建議或答案。它採用 Multiple Agent 架構,運行在獨立虛擬機中,能夠通過編寫和執行代碼、瀏覽網頁、操作應用等方式直接完成任務。Manus 在 GAIA 基準測試中取得了 SOTA 表現,展現了強大的任務執行能力。其目標是成為用戶在數字世界的‘代理人’,幫助用戶高效完成各種複雜任務。

個人助理

1.5M

Trae國內版

Trae是一款專為中文開發場景設計的AI原生IDE,將AI技術深度集成於開發環境中。它通過智能代碼補全、上下文理解等功能,顯著提升開發效率和代碼質量。Trae的出現填補了國內AI集成開發工具的空白,滿足了中文開發者對高效開發工具的需求。其定位為高端開發工具,旨在為專業開發者提供強大的技術支持,目前尚未明確公開價格,但預計會採用付費模式以匹配其高端定位。

開發與工具

137.7K

國外精選

Pika

Pika是一個視頻製作平臺,用戶可以上傳自己的創意想法,Pika會自動生成相關的視頻。主要功能有:支持多種創意想法轉視頻,視頻效果專業,操作簡單易用。平臺採用免費試用模式,定位面向創意者和視頻愛好者。

視頻生成

18.7M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M