Openemma

簡介 :

OpenEMMA是一個開源項目,復現了Waymo的EMMA模型,提供了一個端到端框架用於自動駕駛車輛的運動規劃。該模型利用預訓練的視覺語言模型(VLMs)如GPT-4和LLaVA,整合文本和前視攝像頭輸入,實現對未來自身路徑點的精確預測,並提供決策理由。OpenEMMA的目標是為研究人員和開發者提供易於獲取的工具,以推進自動駕駛研究和應用。

需求人群 :

目標受眾為自動駕駛領域的研究人員和開發者,他們需要一個端到端的框架來實現和測試自動駕駛算法。OpenEMMA提供的開源工具能夠幫助他們快速搭建起自己的自動駕駛系統,並且通過預訓練模型加速研發進程。

使用場景

研究人員使用OpenEMMA在nuScenes數據集上測試新的自動駕駛算法。

開發者利用OpenEMMA提供的框架開發出自己的自動駕駛決策系統。

教育機構使用OpenEMMA作為教學工具,向學生展示自動駕駛技術的實際應用。

產品特色

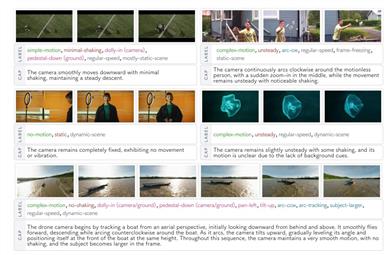

• 利用預訓練的視覺語言模型(VLMs)整合文本和視覺輸入

• 精確預測自動駕駛車輛的未來路徑點

• 提供模型決策的理由和解釋

• 支持YOLO-3D等外部工具進行關鍵物體檢測

• 支持多種模型,如GPT-4、LLaVA、Llama和Qwen2

• 生成預測路徑的可視化圖像和編譯視頻

• 支持nuScenes數據集進行模型訓練和測試

使用教程

1. 設置Conda環境並激活:conda create -n openemma python=3.8; conda activate openemma

2. 克隆OpenEMMA倉庫:git clone git@github.com:taco-group/OpenEMMA.git; cd OpenEMMA

3. 安裝依賴:pip install -r requirements.txt

4. 設置GPT-4 API訪問權限:export OPENAI_API_KEY="your_openai_api_key"

5. 準備輸入數據:下載並解壓nuScenes數據集

6. 運行OpenEMMA:python main.py --model-path [model] --dataroot [dataset_dir] --version [version] --method openemma

7. 解讀輸出:包括路徑點、決策理由、標註圖像和編譯視頻

精選AI產品推薦

Elicit

Elicit是一款能夠以超人速度分析研究論文的AI助手。它可以自動完成繁瑣的研究任務,如論文摘要、數據提取和綜合研究發現。用戶可以搜索相關論文、獲取一句話摘要、從論文中提取詳細信息並進行整理、尋找主題和概念等。Elicit的準確度高,使用方便,已受到廣大研究者的信賴和好評。

研究工具

625.1K

中文精選

Findin AI

Findin AI 是一款旨在通過人工智能技術全面提速學術研究工作流的工具。它通過文獻篩選、論文閱讀、筆記摘錄、主題研究、文獻綜述和學術寫作等功能,幫助用戶高效管理文獻和知識,提升研究效率。產品利用AI技術,如自動總結、一鍵獲取參考文獻、文獻問答等,大幅減少研究過程中的重複勞動,使研究者能夠專注於創新和深度思考。

研究工具

297.3K