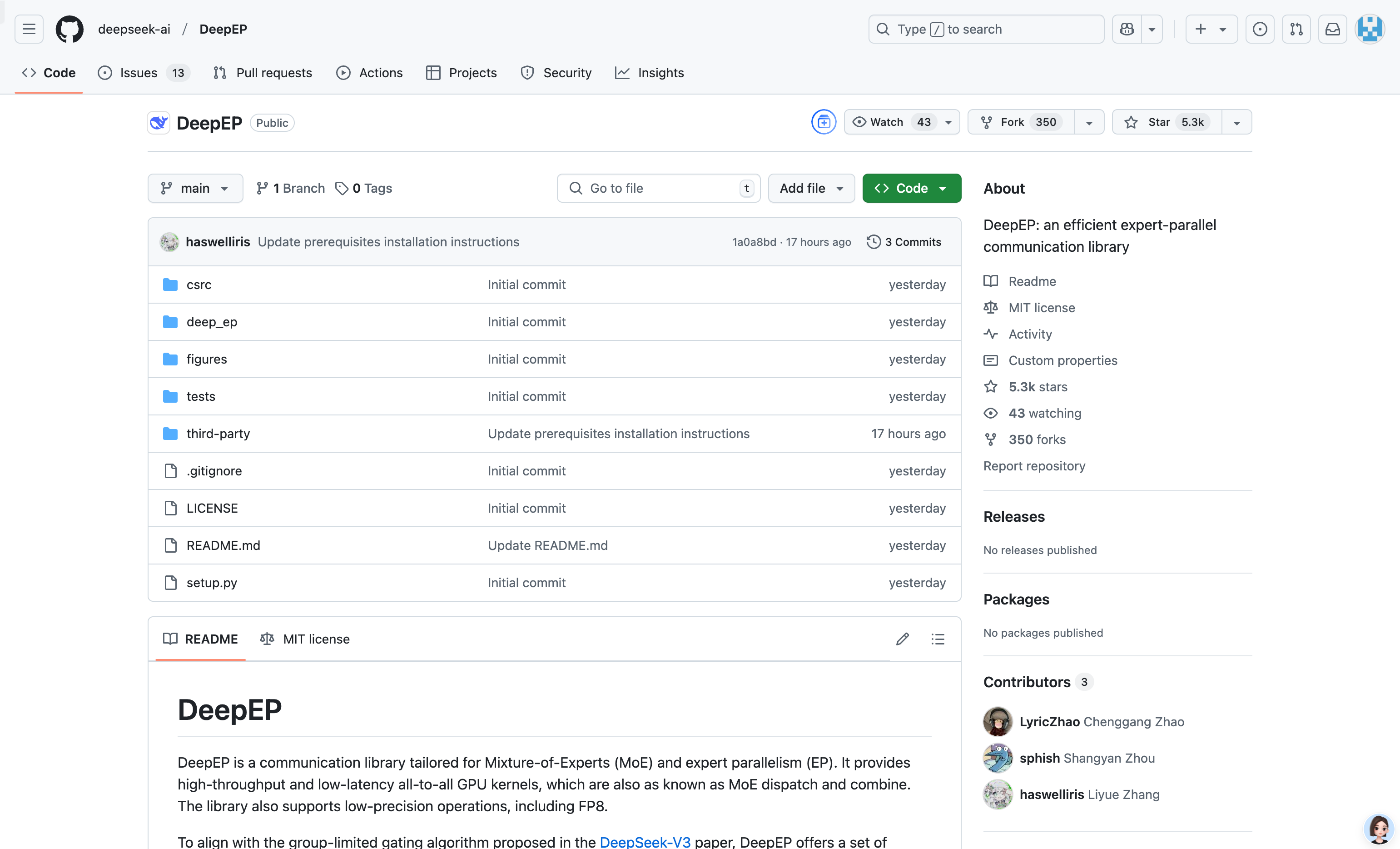

Deepep

簡介 :

DeepEP 是一個專為混合專家模型(MoE)和專家並行(EP)設計的通信庫。它提供了高吞吐量和低延遲的全連接 GPU 內核,支持低精度操作(如 FP8)。該庫針對非對稱域帶寬轉發進行了優化,適合訓練和推理預填充任務。此外,它還支持流處理器(SM)數量控制,並引入了一種基於鉤子的通信-計算重疊方法,不佔用任何 SM 資源。DeepEP 的實現雖然與 DeepSeek-V3 論文略有差異,但其優化的內核和低延遲設計使其在大規模分佈式訓練和推理任務中表現出色。

需求人群 :

該產品適用於需要在大規模分佈式環境中高效運行混合專家模型(MoE)的研究人員、工程師和企業用戶。它特別適合那些需要優化通信性能、降低延遲並提高計算資源利用率的深度學習項目。無論是用於訓練大型語言模型還是進行高效的推理任務,DeepEP 都能提供顯著的性能提升。

使用場景

在大規模分佈式訓練中,使用 DeepEP 的高吞吐量內核加速 MoE 模型的 dispatch 和 combine 操作,顯著提高訓練效率。

在推理階段,利用 DeepEP 的低延遲內核進行快速解碼,適合對即時性要求較高的應用場景。

通過通信-計算重疊方法,DeepEP 在不佔用額外 GPU 資源的情況下,進一步優化了推理任務的性能。

產品特色

支持高吞吐量和低延遲的全連接 GPU 內核,適用於 MoE 模型的 dispatch 和 combine 操作。

優化了非對稱域帶寬轉發,例如從 NVLink 域到 RDMA 域的數據轉發。

支持低延遲內核,使用純 RDMA 通信,適合延遲敏感的推理解碼任務。

提供基於鉤子的通信-計算重疊方法,不佔用 GPU SM 資源,提高資源利用率。

支持多種網絡配置,包括 InfiniBand 和 RDMA over Converged Ethernet (RoCE)。

使用教程

1. 確保系統滿足硬件要求,如 Hopper 架構的 GPU 和支持 RDMA 的網絡設備。

2. 安裝依賴項,包括 Python 3.8 及以上版本、CUDA 12.3 及以上版本和 PyTorch 2.1 及以上版本。

3. 下載並安裝 DeepEP 的依賴庫 NVSHMEM,按照官方提供的安裝指南進行操作。

4. 使用 `python setup.py install` 命令安裝 DeepEP。

5. 在項目中導入 `deep_ep` 模塊,並根據需要調用其提供的 dispatch 和 combine 等功能。

精選AI產品推薦

Pseudoeditor

PseudoEditor是一款免費在線偽代碼編輯器。它具有語法高亮、自動完成等功能,幫助您更輕鬆地編寫偽代碼。您還可以使用我們的偽代碼編譯器功能進行測試。無需下載,即可立即使用。

開發與工具

4.5M

Erbuilder

Softbuilder的AI-powered ER diagrams generation是一款基於人工智能技術的數據建模工具,能夠根據自然語言的數據模型描述、用戶故事或需求自動生成ER圖。通過使用OpenAI GPT,它能夠快速生成精美的ER圖,大大提高了數據建模的效率。此外,它還提供數據模型文檔、驗證、探索等功能,可滿足各種數據建模需求。Softbuilder的AI-powered ER diagrams generation適用於各類企業和組織,幫助用戶輕鬆創建和管理數據模型。

開發與工具

4.1M