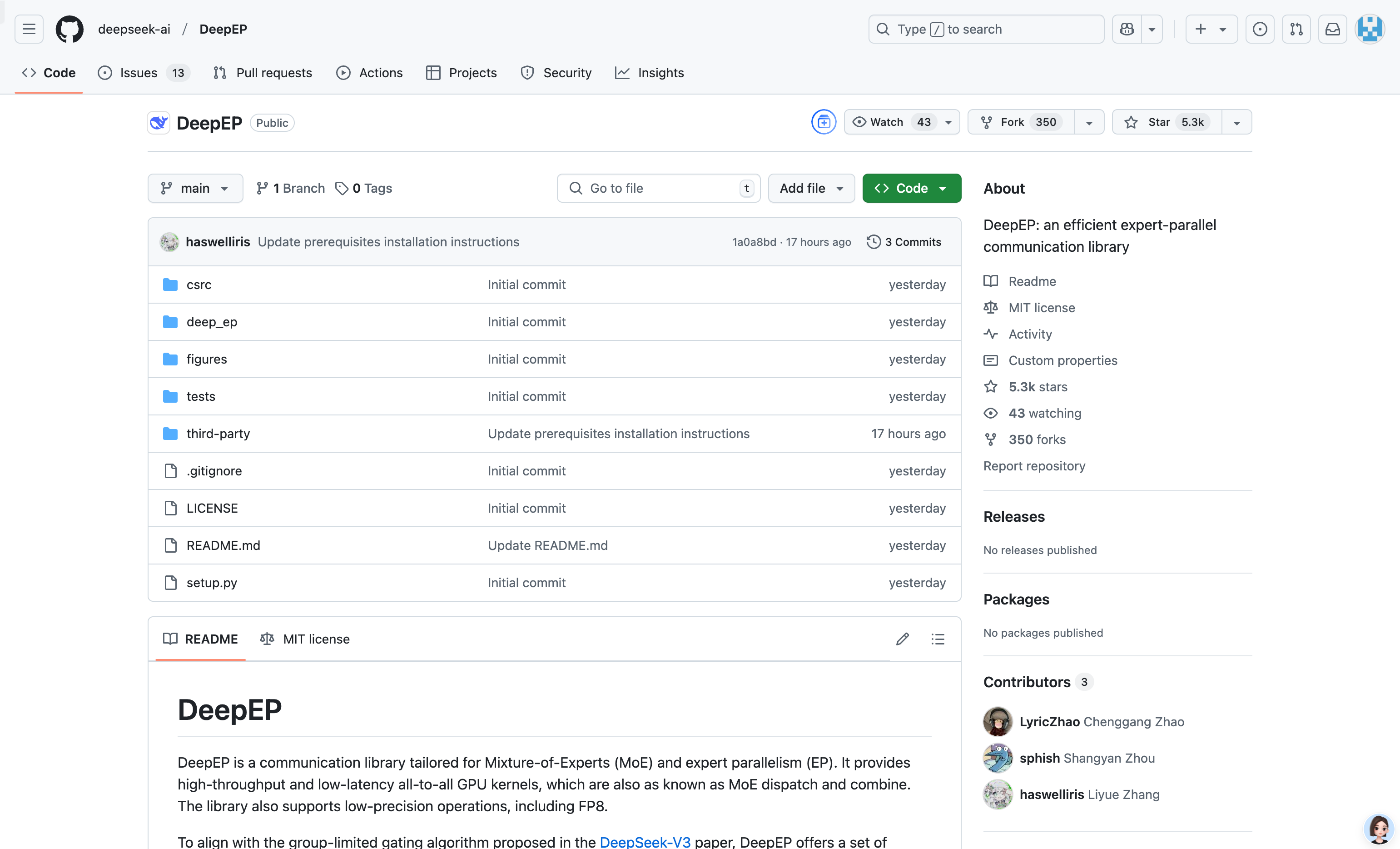

Deepep

紹介 :

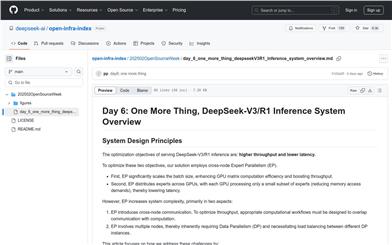

DeepEPは、混合専門家モデル(MoE)と専門家並列処理(EP)用に設計された通信ライブラリです。高スループットと低遅延の全結合GPUカーネルを提供し、低精度演算(FP8など)をサポートしています。非対称ドメイン帯域幅転送向けに最適化されており、プリフェッチタスクのトレーニングと推論に適しています。さらに、ストリームプロセッサ(SM)数の制御をサポートし、フックベースの通信計算オーバーラップ手法を導入しており、SMリソースを消費しません。DeepEPの実装はDeepSeek-V3論文とは多少異なりますが、最適化されたカーネルと低遅延設計により、大規模分散トレーニングと推論タスクで優れたパフォーマンスを発揮します。

ターゲットユーザー :

大規模分散環境で混合専門家モデル(MoE)を効率的に実行する必要がある研究者、エンジニア、企業ユーザー向けです。通信性能の最適化、遅延の低減、計算資源の利用率向上を必要とするディープラーニングプロジェクトに特に適しています。大規模言語モデルのトレーニングや効率的な推論タスクに使用する場合でも、DeepEP は顕著な性能向上をもたらします。

使用シナリオ

大規模分散トレーニングにおいて、DeepEPの高スループットカーネルを使用してMoEモデルのdispatchとcombine操作を高速化し、トレーニング効率を大幅に向上させます。

推論段階では、DeepEPの低遅延カーネルを使用して高速デコードを行い、リアルタイム性が求められるアプリケーションシナリオに適しています。

通信計算オーバーラップ手法により、DeepEPは追加のGPUリソースを消費することなく、推論タスクのパフォーマンスをさらに最適化します。

製品特徴

MoEモデルのdispatchとcombine操作に適した、高スループットと低遅延の全結合GPUカーネルをサポートします。

NVLinkドメインからRDMAドメインへのデータ転送など、非対称ドメイン帯域幅転送を最適化しています。

低遅延カーネルをサポートし、純粋なRDMA通信を使用するため、遅延に敏感な推論デコードタスクに適しています。

フックベースの通信計算オーバーラップ手法を提供し、GPU SMリソースを消費しないため、リソース利用率が向上します。

InfiniBandやRDMA over Converged Ethernet(RoCE)など、複数のネットワーク構成をサポートします。

使用チュートリアル

1. HopperアーキテクチャのGPUとRDMA対応のネットワークデバイスなど、システムがハードウェア要件を満たしていることを確認します。

2. Python 3.8以上、CUDA 12.3以上、PyTorch 2.1以上のバージョンを含む依存関係をインストールします。

3. DeepEPの依存ライブラリNVSHMEMをダウンロードしてインストールします。公式のインストールガイドに従って操作してください。

4. `python setup.py install`コマンドを使用してDeepEPをインストールします。

5. プロジェクトで`deep_ep`モジュールをインポートし、必要に応じて提供されているdispatchやcombineなどの機能を呼び出します。

おすすめAI製品

Pseudoeditor

PseudoEditorは無料で使用できるオンライン擬似コードエディタです。構文の強調表示や自動補完などの機能を備えており、擬似コードの作成を容易にします。さらに、内蔵の擬似コードコンパイラ機能でテストすることも可能です。ダウンロード不要ですぐにご利用いただけます。

開発とツール

3.8M

Coze

Cozeは、次世代AIチャットボット構築プラットフォームです。AIチャットボットアプリケーションの迅速な作成、デバッグ、最適化が可能です。コーディング不要で、チャットボットを簡単に作成し、様々なプラットフォームに公開できます。豊富なプラグインも提供しており、データとの連携、アイデアをボットスキルへの変換、長期記憶の装備、会話の開始など、ボットの機能を拡張できます。

開発とツール

3.7M