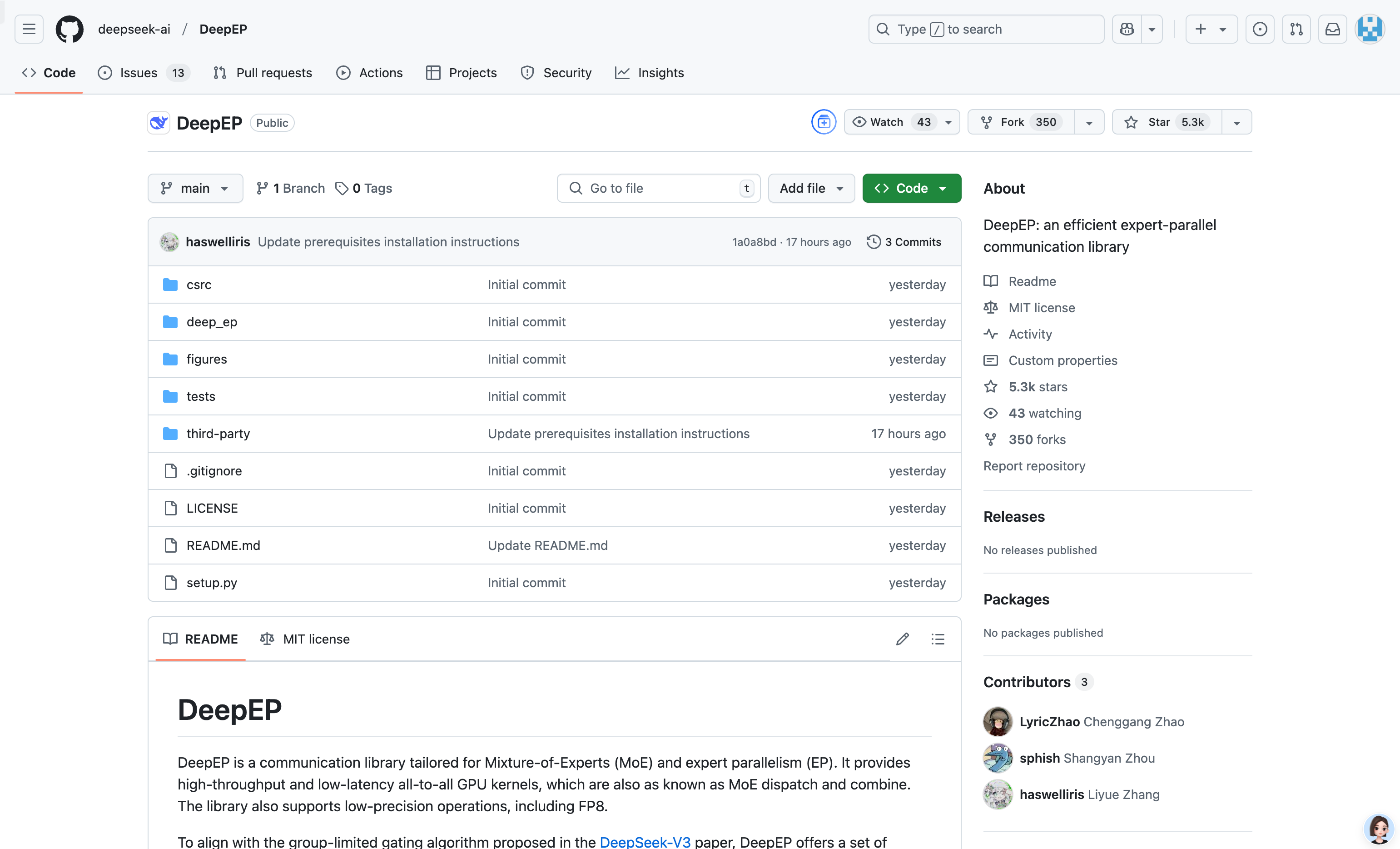

Deepep

简介 :

DeepEP 是一个专为混合专家模型(MoE)和专家并行(EP)设计的通信库。它提供了高吞吐量和低延迟的全连接 GPU 内核,支持低精度操作(如 FP8)。该库针对非对称域带宽转发进行了优化,适合训练和推理预填充任务。此外,它还支持流处理器(SM)数量控制,并引入了一种基于钩子的通信-计算重叠方法,不占用任何 SM 资源。DeepEP 的实现虽然与 DeepSeek-V3 论文略有差异,但其优化的内核和低延迟设计使其在大规模分布式训练和推理任务中表现出色。

需求人群 :

该产品适用于需要在大规模分布式环境中高效运行混合专家模型(MoE)的研究人员、工程师和企业用户。它特别适合那些需要优化通信性能、降低延迟并提高计算资源利用率的深度学习项目。无论是用于训练大型语言模型还是进行高效的推理任务,DeepEP 都能提供显著的性能提升。

使用场景

在大规模分布式训练中,使用 DeepEP 的高吞吐量内核加速 MoE 模型的 dispatch 和 combine 操作,显著提高训练效率。

在推理阶段,利用 DeepEP 的低延迟内核进行快速解码,适合对实时性要求较高的应用场景。

通过通信-计算重叠方法,DeepEP 在不占用额外 GPU 资源的情况下,进一步优化了推理任务的性能。

产品特色

支持高吞吐量和低延迟的全连接 GPU 内核,适用于 MoE 模型的 dispatch 和 combine 操作。

优化了非对称域带宽转发,例如从 NVLink 域到 RDMA 域的数据转发。

支持低延迟内核,使用纯 RDMA 通信,适合延迟敏感的推理解码任务。

提供基于钩子的通信-计算重叠方法,不占用 GPU SM 资源,提高资源利用率。

支持多种网络配置,包括 InfiniBand 和 RDMA over Converged Ethernet (RoCE)。

使用教程

1. 确保系统满足硬件要求,如 Hopper 架构的 GPU 和支持 RDMA 的网络设备。

2. 安装依赖项,包括 Python 3.8 及以上版本、CUDA 12.3 及以上版本和 PyTorch 2.1 及以上版本。

3. 下载并安装 DeepEP 的依赖库 NVSHMEM,按照官方提供的安装指南进行操作。

4. 使用 `python setup.py install` 命令安装 DeepEP。

5. 在项目中导入 `deep_ep` 模块,并根据需要调用其提供的 dispatch 和 combine 等功能。

精选AI产品推荐

Pseudoeditor

PseudoEditor是一款免费在线伪代码编辑器。它具有语法高亮、自动完成等功能,帮助您更轻松地编写伪代码。您还可以使用我们的伪代码编译器功能进行测试。无需下载,即可立即使用。

开发与工具

4.5M

Erbuilder

Softbuilder的AI-powered ER diagrams generation是一款基于人工智能技术的数据建模工具,能够根据自然语言的数据模型描述、用户故事或需求自动生成ER图。通过使用OpenAI GPT,它能够快速生成精美的ER图,大大提高了数据建模的效率。此外,它还提供数据模型文档、验证、探索等功能,可满足各种数据建模需求。Softbuilder的AI-powered ER diagrams generation适用于各类企业和组织,帮助用户轻松创建和管理数据模型。

开发与工具

4.1M