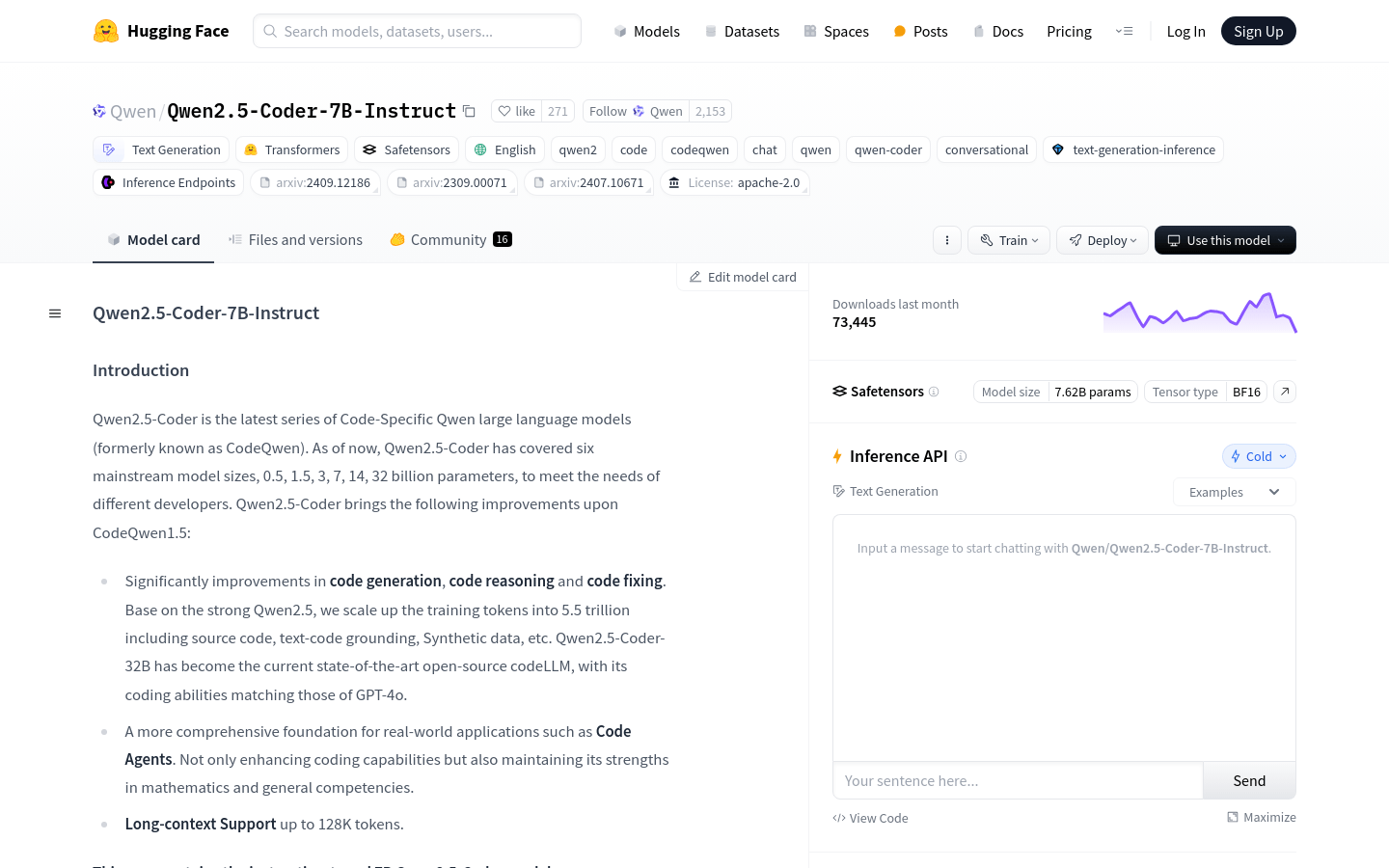

Qwen2.5 Coder 7B Instruct

簡介 :

Qwen2.5-Coder-7B-Instruct是Qwen2.5-Coder系列中的一款代碼特定大型語言模型,覆蓋了0.5、1.5、3、7、14、32億參數的六種主流模型尺寸,以滿足不同開發者的需求。該模型在代碼生成、代碼推理和代碼修復方面有顯著提升,基於強大的Qwen2.5,訓練令牌擴展到5.5萬億,包括源代碼、文本代碼基礎、合成數據等。Qwen2.5-Coder-32B已成為當前最先進的開源代碼LLM,其編碼能力與GPT-4o相匹配。此外,該模型還支持長達128K令牌的長上下文,併為實際應用如代碼代理提供了更全面的基礎。

需求人群 :

目標受眾為開發者和編程人員,特別是那些需要處理大量代碼和複雜項目的人員。Qwen2.5-Coder-7B-Instruct能夠提供代碼生成、推理和修復等高級功能,幫助他們提高開發效率和代碼質量。

使用場景

開發者使用Qwen2.5-Coder-7B-Instruct生成一個快速排序算法的代碼。

軟件工程師利用模型修復現有代碼庫中的bug。

數據科學家使用模型生成數據處理和分析的代碼。

產品特色

代碼生成:顯著提升代碼生成能力,支持多種編程語言。

代碼推理:增強代碼理解能力,幫助開發者推理代碼邏輯。

代碼修復:自動檢測並修復代碼中的錯誤。

長上下文支持:支持長達128K令牌的長上下文,適合處理大型代碼庫。

基於Transformers架構:使用RoPE、SwiGLU、RMSNorm和Attention QKV偏置等先進技術。

參數數量:擁有7.61B個參數,非嵌入參數為6.53B。

層數和注意力頭:具有28層和28個Q的注意力頭以及4個KV的注意力頭。

適用於實際應用:不僅增強編碼能力,還保持在數學和通用能力方面的優勢。

使用教程

1. 訪問Hugging Face平臺並找到Qwen2.5-Coder-7B-Instruct模型。

2. 根據頁面提供的代碼片段,導入AutoModelForCausalLM和AutoTokenizer。

3. 使用模型名稱加載模型和分詞器。

4. 準備輸入提示,例如編寫一個特定功能的代碼請求。

5. 將提示轉換為模型可以理解的格式,使用tokenizer處理。

6. 將處理後的輸入傳遞給模型,並設置生成參數,如最大新令牌數。

7. 模型生成響應後,使用tokenizer解碼生成的令牌以獲取最終結果。

8. 根據需要調整生成參數,以優化代碼生成的效果。

精選AI產品推薦

Trae

Trae 是一款面向開發者的 AI 驅動的集成開發環境(IDE)。它通過智能代碼補全、多模態交互以及對整個代碼庫的上下文分析等功能,幫助開發者更高效地編寫代碼。Trae 的主要優點在於其強大的 AI 能力,能夠理解開發者的需求並提供精準的代碼生成和修改建議。該產品目前提供免費版本,旨在幫助開發者減少重複性任務,專注於創造性工作,從而提升編程效率和生產力。

代碼助手

1.8M

Fitten Code

Fitten Code是一個GPT驅動的代碼生成和完成工具,支持多種語言:Python、Javascript、Typescript、Java等。它能夠自動為您的代碼補充缺失的部分,節省您寶貴的開發時間。基於AI大模型對代碼進行語義級翻譯,支持多種編程語言互譯。同時,它能夠根據您的代碼自動生成相關注釋,為您的代碼提供清晰易懂的解釋和文檔。除此之外,它還擁有智能bug查找、解釋代碼、自動生成單元測試的功能,以及根據代碼自動產生相應的測試用例等功能。

代碼助手

990.3K