Light R1

簡介 :

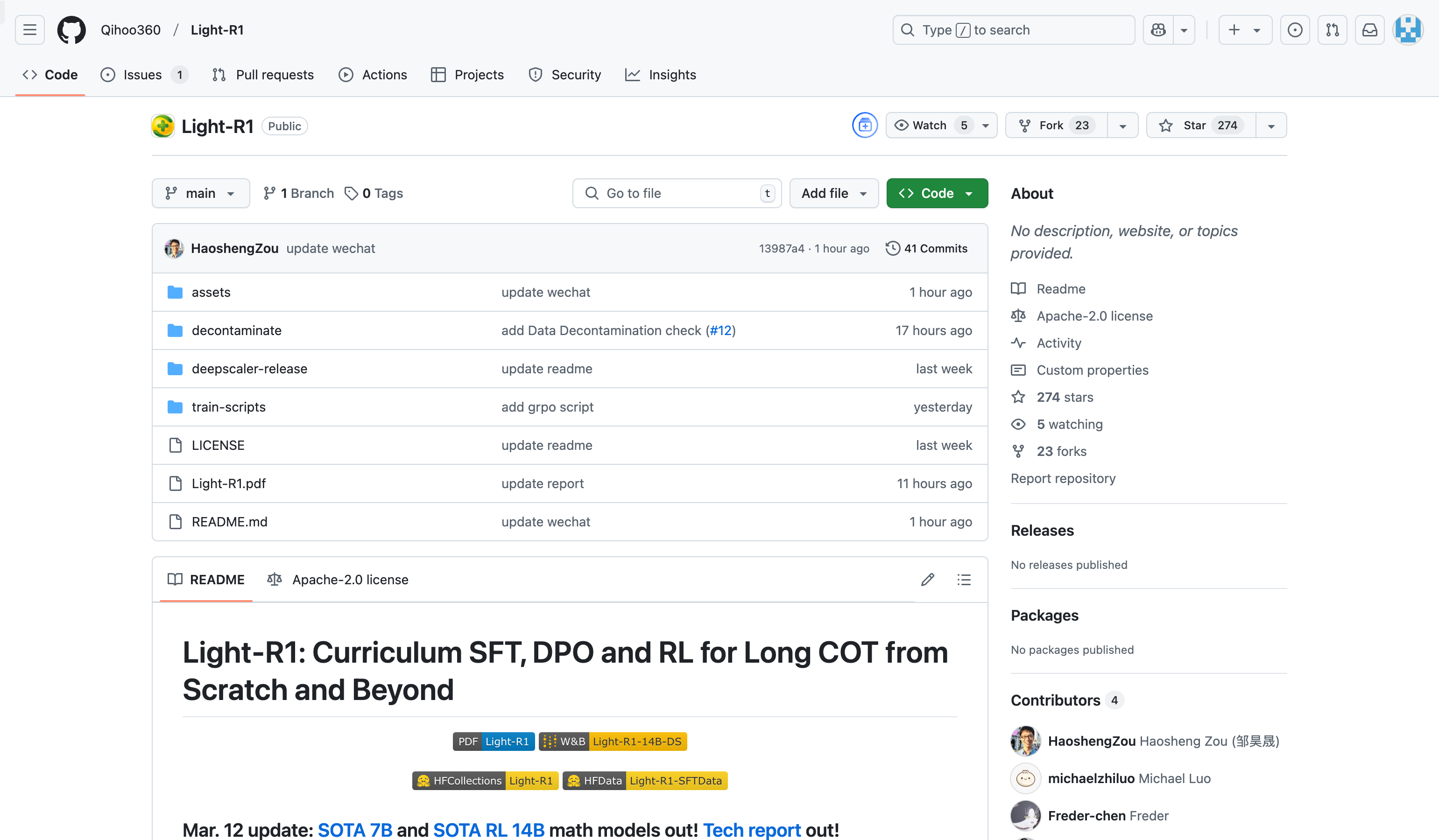

Light-R1 是一個由 Qihoo360 開發的開源項目,旨在通過課程式監督微調(SFT)、直接偏好優化(DPO)和強化學習(RL)訓練長鏈推理模型。該項目通過去汙染數據集和高效的訓練方法,實現了從零開始的長鏈推理能力。其主要優點包括開源的訓練數據、低成本的訓練方式以及在數學推理領域的卓越性能。項目背景基於當前長鏈推理模型的訓練需求,旨在提供一種透明且可復現的訓練方法。項目目前免費開源,適合研究機構和開發者使用。

需求人群 :

目標受眾包括人工智能研究者、機器學習工程師以及對長鏈推理模型感興趣的開發者。該項目適合那些希望在有限資源下訓練高性能長鏈推理模型的研究團隊和企業,同時也為開源社區提供了寶貴的參考。

使用場景

使用 Light-R1-7B-DS 模型在 AIME24 測試中達到 59.1% 的準確率,顯著優於其他同類模型。

通過課程式 SFT 和 DPO 訓練,Light-R1-32B 在 AIME24 上達到 76.6% 的準確率,超越了 DeepSeek-R1-Distill-Qwen-32B。

開發者可以基於開源的訓練代碼和數據集,快速復現 Light-R1 的訓練過程,並進行定製化改進。

產品特色

提供從零開始的長鏈推理訓練方法,無需依賴預訓練的長鏈推理能力

開源完整的訓練數據集和代碼,便於研究者復現和改進

採用課程式學習,通過 SFT 和 DPO 提升模型性能

支持強化學習(RL)訓練,進一步優化模型表現

在數學推理領域表現出色,特別是在 AIME24 和 AIME25 等基準測試中

使用教程

1. 克隆 Light-R1 項目代碼到本地。

2. 下載並安裝項目依賴的 Python 包。

3. 使用開源的訓練數據集運行 SFT 訓練腳本。

4. 在 SFT 基礎上運行 DPO 訓練腳本,進一步優化模型。

5. 使用訓練好的模型進行推理或繼續進行 RL 訓練。

精選AI產品推薦

Elicit

Elicit是一款能夠以超人速度分析研究論文的AI助手。它可以自動完成繁瑣的研究任務,如論文摘要、數據提取和綜合研究發現。用戶可以搜索相關論文、獲取一句話摘要、從論文中提取詳細信息並進行整理、尋找主題和概念等。Elicit的準確度高,使用方便,已受到廣大研究者的信賴和好評。

研究工具

625.1K

中文精選

Findin AI

Findin AI 是一款旨在通過人工智能技術全面提速學術研究工作流的工具。它通過文獻篩選、論文閱讀、筆記摘錄、主題研究、文獻綜述和學術寫作等功能,幫助用戶高效管理文獻和知識,提升研究效率。產品利用AI技術,如自動總結、一鍵獲取參考文獻、文獻問答等,大幅減少研究過程中的重複勞動,使研究者能夠專注於創新和深度思考。

研究工具

297.3K