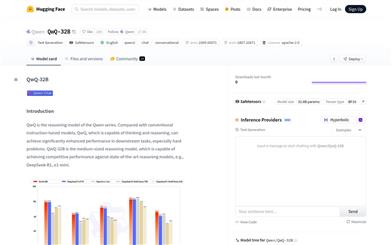

Qwq 32B

QwQ-32BはQwenシリーズの推論モデルであり、複雑な問題の思考と推論能力に特化しています。下流タスクにおいて優れたパフォーマンスを発揮し、特に難問解決においてその力を発揮します。このモデルはQwen2.5アーキテクチャをベースに、事前学習と強化学習による最適化が行われており、325億のパラメーターを持ち、最大131072トークンの完全なコンテキスト長を処理できます。主な利点としては、強力な推論能力、効率的な長文処理能力、柔軟な展開オプションなどが挙げられます。このモデルは、学術研究、プログラミング支援、創作執筆など、深い思考と複雑な推論を必要とする場面に適しています。

AIモデル

49.4K

ART

ARTは、深層学習に基づいた画像生成技術であり、可変多層透明画像の生成に特化しています。匿名領域レイアウトとTransformerアーキテクチャにより、効率的な多層画像生成を実現しています。この技術の主な利点としては、効率性、柔軟性、そして多層画像生成のサポートが挙げられます。グラフィックデザインやVFXなど、画像レイヤーの正確な制御が必要なシーンに適しています。現時点では価格と具体的なターゲットユーザーは明示されていませんが、その技術特性から、専門ユーザーやエンタープライズアプリケーション向けである可能性が高いです。

AI設計ツール

43.6K

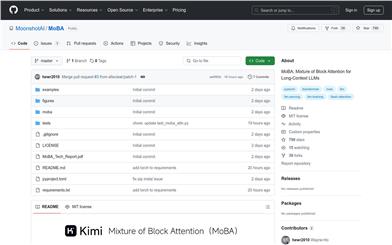

Moba

MoBA(Mixture of Block Attention)は、長文コンテキストを扱う大規模言語モデル向けに設計された革新的なアテンション機構です。コンテキストを複数のブロックに分割し、各クエリトークンが最も関連性の高いブロックに注目することで、効率的な長シーケンス処理を実現します。MoBAの主な利点は、フルアテンションとスパースアテンションをシームレスに切り替えられることで、性能と計算効率の両立を可能にしている点です。文書解析やコード生成など、長文処理が必要なタスクに適用可能であり、計算コストの大幅な削減と、高いモデル性能の維持を両立します。MoBAのオープンソース実装は、研究者や開発者に強力なツールを提供し、長文処理分野における大規模言語モデルの応用を促進します。

モデルトレーニングとデプロイメント

47.7K

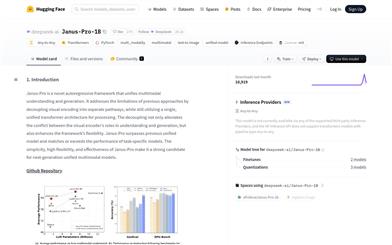

Janus Pro 1B

Janus-Pro-1Bは、多様なモダリティの理解と生成に特化した革新的な多様なモダリティモデルです。視覚エンコーディングパスを分離することで、従来の方法が理解と生成タスクにおいて抱えていた矛盾を解消し、同時に単一の統一されたTransformerアーキテクチャを維持しています。この設計により、モデルの柔軟性が向上するだけでなく、多様なモダリティタスクにおいて優れた性能を発揮し、特定タスクのモデルを上回る結果も得られています。DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-baseを基盤とし、視覚エンコーダーとしてSigLIP-Lを採用、384x384の画像入力をサポートし、専用のイメージ生成トクナイザを使用しています。オープンソースであり柔軟性が高いため、次世代の多様なモダリティモデルの有力候補となっています。

AIモデル

71.2K

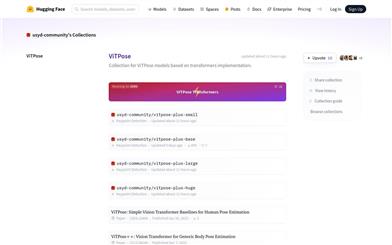

Vitpose

ViTPoseは、Transformerアーキテクチャに基づく人体姿勢推定モデル群です。Transformerの強力な特徴抽出能力を活用し、人体姿勢推定タスクに対してシンプルかつ効果的なベースラインを提供します。ViTPoseモデルは複数のデータセットで優れた性能を示し、高い精度と効率性を備えています。シドニー大学のコミュニティによって保守?更新されており、様々な規模のバージョンが提供され、多様なアプリケーションシナリオのニーズに対応します。Hugging Faceプラットフォーム上でオープンソースとして提供されており、ユーザーは容易にこれらのモデルをダウンロード?デプロイし、人体姿勢推定に関する研究やアプリケーション開発を行うことができます。

AIモデル

50.5K

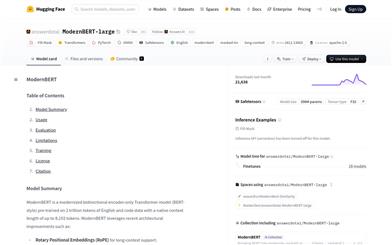

Modernbert Large

ModernBERT-largeは、最新のアーキテクチャ改良(回転位置埋め込み(RoPE)による長文コンテキスト対応、局所-グローバル交互注意機構による長入力の効率化、パディング不要とFlash Attentionによる推論効率向上など)を取り入れた、現代的な双方向エンコーダーTransformerモデル(BERTスタイル)です。2兆個の英語とコードのデータで事前学習されており、最大8192トークンのネイティブなコンテキスト長を備えています。長文書の処理が必要な検索、分類、大規模コーパスでの意味検索などのタスクに適しています。モデルの訓練データは主に英語とコードであるため、他の言語でのパフォーマンスは低い可能性があります。

AI検索

46.9K

Modernbert

ModernBERTは、Answer.AIとLightOnが共同で発表した次世代エンコーダーモデルであり、BERTモデルを全面的にアップグレードしたものです。より長いシーケンス長、優れた下流性能、そして高速な処理速度を提供します。最新のTransformerアーキテクチャの改良を採用し、特に効率性に重点を置いており、大規模で多様なデータソースを用いてトレーニングされています。エンコーダーモデルとして、ModernBERTは様々な自然言語処理タスクで優れた性能を発揮し、特にコード検索と理解においてその力を発揮します。基本版(139Mパラメータ)と大型版(395Mパラメータ)の2つのモデルサイズを提供しており、様々な規模のアプリケーションニーズに対応できます。

AIモデル

45.0K

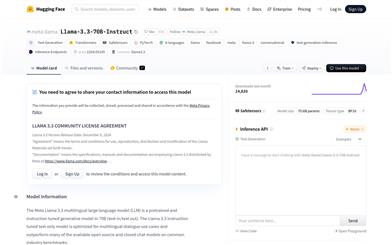

Llama 3.3 70B Instruct

Llama-3.3-70B-Instructは、Metaが開発した70億パラメーターの大規模言語モデルで、多言語対話シーン向けに最適化されています。このモデルは最適化されたTransformerアーキテクチャを使用し、教師あり微調整(SFT)と人間からのフィードバックに基づく強化学習(RLHF)によって、有用性と安全性を向上させています。複数の言語に対応し、テキスト生成タスクを処理できるため、自然言語処理分野における重要な技術です。

チャットボット

51.1K

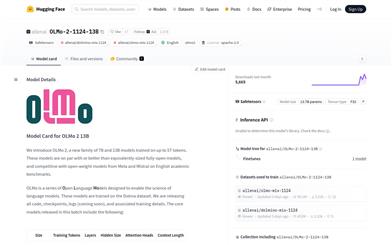

Olmo 2 13B

OLMo 2 13BはAllen Institute for AI (Ai2)によって開発された、Transformerベースの自己回帰言語モデルです。英語の学術ベンチマークテストに特化しており、5兆トークンという大規模なデータセットで訓練されました。同規模のオープンソースモデルと同等かそれ以上の性能を示し、MetaやMistralのオープンウェイトモデルと英語学術ベンチマークにおいて競合しています。OLMo 2 13Bの公開には、すべてのコード、チェックポイント、ログ、および関連するトレーニングの詳細が含まれており、言語モデルの科学研究を促進することを目的としています。

AIモデル

50.0K

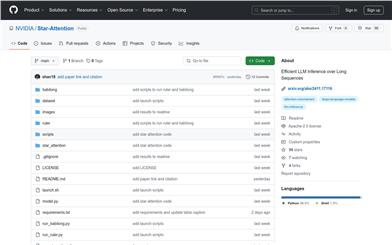

Star Attention

Star-AttentionはNVIDIAが提案した新しいブロックスパース注意力機構であり、Transformerベースの大型言語モデル(LLM)の長系列における推論効率を向上させることを目的としています。この技術は二段階の操作によって推論速度を大幅に向上させながら、95~100%の精度を維持します。ほとんどのTransformerベースのLLMと互換性があり、追加のトレーニングや微調整なしで直接使用でき、Flash AttentionやKVキャッシュ圧縮技術などの他の最適化手法と組み合わせて使用することで、さらに性能を向上させることができます。

モデルトレーニングとデプロイメント

47.5K

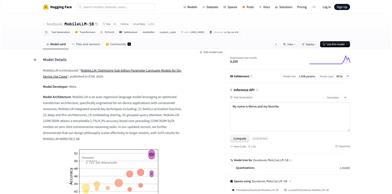

Mobilellm 1B

Metaが開発した自己回帰言語モデルです。最適化されたアーキテクチャにより、リソース制限のあるデバイスにも対応しています。様々な技術を統合し、ゼロショット推論にも対応するなど、多くの利点を持ちながら、無料で利用可能です。自然言語処理の研究者や開発者を対象としています。

AIモデル

46.1K

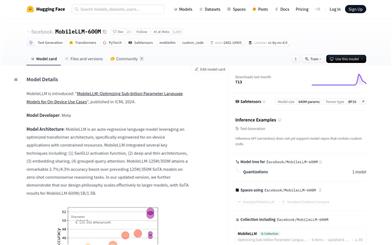

Mobilellm 600M

MobileLLM-600Mは、Metaが開発した自己回帰言語モデルであり、リソースの制約されたデバイス向けアプリケーション用に設計された、最適化されたTransformerアーキテクチャを採用しています。このモデルは、SwiGLU活性化関数、深層薄型アーキテクチャ、埋め込み共有、グループ化クエリ注意機構などの重要な技術を統合しています。MobileLLM-600Mは、ゼロショット常識推論タスクにおいて顕著な性能向上を実現し、以前の1億2500万/3億5000万パラメーターの最先端モデルと比較して、それぞれ2.7%/4.3%の精度向上を達成しました。このモデルの設計理念は、MobileLLM-1B/1.5Bなどのより大規模なモデルにも拡張でき、いずれも最先端の結果を達成しています。

AIモデル

45.8K

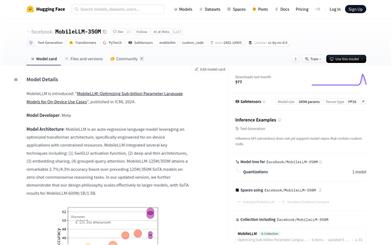

Mobilellm 350M

MobileLLM-350MはMetaによって開発された、自己回帰型言語モデルです。最適化されたTransformerアーキテクチャを採用しており、リソースの限られた環境でのデバイス向けアプリケーションに適しています。SwiGLU活性化関数、深層薄型アーキテクチャ、埋め込み共有、グループ化クエリ?アテンションなどの重要な技術を統合することで、ゼロショット常識推論タスクにおける精度の大幅な向上を実現しています。MobileLLM-350Mは、小さなモデルサイズを維持しながら、より大きなモデルに匹敵する性能を提供し、デバイス上の自然言語処理アプリケーションに最適な選択肢です。

AIモデル

43.3K

オアシス

オアシスは、Decart AIが開発した、プレイ可能なリアルタイムのオープンワールドAIモデルです。Transformerによるエンドツーエンド生成に基づくインタラクティブなビデオゲームであり、フレーム単位で生成されます。オアシスは、ユーザーのキーボードとマウスからの入力を受け取り、リアルタイムでゲームプレイを生成し、内部で物理演算、ゲームルール、グラフィックをシミュレートします。ゲームプレイを直接観察することで学習し、ユーザーは移動、ジャンプ、アイテムの拾い上げ、ブロックの破壊などの操作が可能です。より複雑なインタラクティブな世界を研究するための基礎モデルとしての第一歩と捉えられており、将来的には従来のゲームエンジンに取って代わる可能性を秘めています。オアシスの実現には、モデルアーキテクチャの改良と、ユーザーとモデル間のリアルタイムインタラクションを実現するためのモデル推論技術のブレークスルーが必要でした。Decart AIは最新の拡散訓練とTransformerモデル手法を採用し、大規模言語モデル(LLM)と組み合わせることで、ユーザーの即時的な行動に基づいてビデオを生成できる自己回帰モデルを訓練しました。さらに、Decart AIは、NVIDIA H100 Tensor Core GPUのピークパフォーマンスを最大限に活用し、Etchedの提供予定であるSohuチップにも対応できる独自の推論フレームワークを開発しました。

ゲーム開発

93.8K

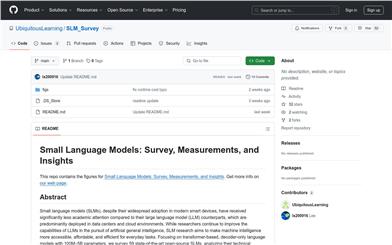

SLM Survey

SLM_Surveyは、小型言語モデル(SLMs)に特化した研究プロジェクトです。調査と計測を通じて、これらのモデルに関する深い理解と技術評価を提供することを目的としています。本プロジェクトは、Transformerベースのデコーダーのみの言語モデルを対象とし、パラメーター数は1億から50億の間です。59個の最先端のオープンソースSLMを調査し、その技術革新を分析し、常識推論、コンテキスト学習、数学、プログラミングなど複数の分野で能力を評価しました。さらに、推論遅延とメモリ使用量を含む実行時コストについてもベンチマークテストを実施しました。これらの研究は、SLM分野の研究推進に重要な価値を持ちます。

AI研究開発

46.1K

高品質新製品

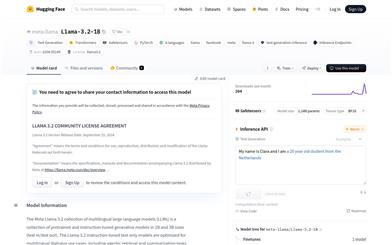

Llama 3.2 1B

Llama-3.2-1BはMeta社が公開した多言語大規模言語モデルであり、テキスト生成タスクに特化しています。最適化されたTransformerアーキテクチャを使用し、教師あり微調整(SFT)と人間のフィードバックによる強化学習(RLHF)によって、有用性と安全性に関する人間の好みを反映するように調整されています。英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語の8言語に対応し、様々な対話ユースケースにおいて優れた性能を発揮します。

AIモデル

50.2K

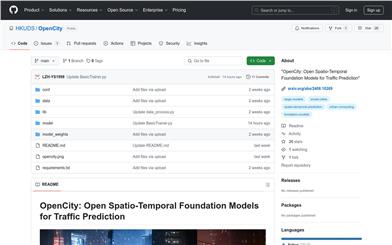

Opencity

OpenCityは、交通予測分野に特化したオープンソースの時空間基礎モデルです。Transformerアーキテクチャとグラフニューラルネットワークを統合することで、交通データにおける複雑な時空間依存関係を効果的に捉え、標準化し、様々な都市環境へのゼロショット汎化を実現します。大規模かつ異種混合の交通データセットで事前学習を行い、豊富で汎化可能な表現を獲得しており、様々な交通予測シナリオにシームレスに適用可能です。

AIモデル

43.6K

Bailing TTS

Bailing-TTSは、Giant NetworkのAI Labが開発した、高品質な中国語方言音声の生成に特化した大規模テキスト音声変換(TTS)モデルシリーズです。持続的な半教師あり学習と特化型Transformerアーキテクチャを採用し、多段階の訓練プロセスを経て、テキストと音声トークンの効果的なアライメントを実現し、高品質な中国語方言音声合成を可能にしています。実験において、人間の発話に近い自然な音声合成効果を示しており、方言音声合成分野において重要な意義を持っています。

AI音声合成

142.7K

Tele FLM 1T

Tele-FLM-1Tは、約2Tトークンで訓練された、1Tパラメーターのオープンソース多言語大規模言語モデルです。デコーダーのみのTransformerアーキテクチャに基づいており、その規模において卓越した性能を示し、場合によってはより大きなモデルをも凌駕します。モデルの重みの共有に加え、コア設計、エンジニアリングプラクティス、トレーニングの詳細も提供しており、学術界と産業界の双方に貢献することを期待しています。

AIモデル

44.7K

高品質新製品

DCLM 7B

DCLM-Baseline-7Bは、DataComp for Language Models (DCLM)チームによって開発された、7億パラメーターの言語モデルです。主に英語を使用します。このモデルは、体系的なデータ整理技術によって言語モデルの性能向上を目指しています。モデルの訓練にはPyTorchとOpenLMフレームワークを使用し、最適化アルゴリズムはAdamW、学習率は2e-3、重み減衰は0.05、バッチサイズは2048シーケンス、シーケンス長は2048トークン、総訓練トークン数は2.5Tに達しました。モデル訓練にはH100 GPUを使用しました。

AIモデル

54.6K

高品質新製品

Mamba Codestral 7B V0.1

Mamba-Codestral-7B-v0.1は、Mistral AIチームが開発したMamba2アーキテクチャに基づくオープンソースコードモデルです。性能は最先端のTransformerベースのコードモデルと同等で、複数の業界標準ベンチマークテストで優れた結果を示しています。効率的なコード生成と理解能力を提供し、プログラミングとソフトウェア開発の分野に適しています。

AIコード生成

54.6K

Flashattention

FlashAttentionは、深層学習におけるTransformerモデル向けに設計された、オープンソースのアテンション機構ライブラリです。計算効率とメモリ使用効率の向上を目的としており、IO感知型のアプローチによってアテンション計算を最適化し、メモリ消費量を削減しつつ、正確な計算結果を維持します。FlashAttention-2では並列性とタスク割り当てがさらに改善され、FlashAttention-3ではHopper GPU向けに最適化され、FP16とBF16データ型をサポートしています。

AIモデル

48.0K

Videollama2 7B 16F Base

VideoLLaMA2-7B-16F-Baseは、DAMO-NLP-SGチームが開発した大規模動画言語モデルで、動画質問応答(Visual Question Answering)と動画字幕生成に特化しています。高度な時空間モデリングと音声理解能力を備え、マルチモーダル動画コンテンツ分析を強力に支援します。視覚的質問応答と動画字幕生成タスクにおいて卓越した性能を発揮し、複雑な動画コンテンツを処理し、正確な説明と回答を生成できます。

AI動画生成

51.3K

Easyanimate

EasyAnimateは、Transformerアーキテクチャに基づくパイプラインであり、AI写真および動画の生成に使用できます。Diffusion Transformer向けの基底モデルとLoRAモデルのトレーニングをサポートします。予めトレーニングされたEasyAnimateモデルから直接予測を行い、異なる解像度、約6秒(24fps)の動画を生成できます。ユーザーは独自の基底モデルとLoRAモデルをトレーニングして、特定のスタイル変換を実行することも可能です。

AI動画生成

66.2K

Create Tsi

create-tsiは、低コードでAIアプリケーションを生成するための生成AI RAG(Retrieval-Augmented Generation)ツールキットです。LlamaIndexと、Open Telekom Cloud上でT-Systemsがホストする大規模言語モデル(LLM)を活用することで、AIアプリケーションの作成プロセスを簡素化し、迅速かつ柔軟な開発を可能にします。create-tsiを使用すると、チャットボットの生成、エージェントの記述、特定のユースケースへのカスタマイズが容易になります。

AI開発助手

49.1K

高品質新製品

Spacebyte

SpaceByteは、大規模言語モデルで広く使用されているトークナイゼーション技術がもたらすいくつかの欠点を解決することを目的とした、全く新しいバイトレベルのデコードアーキテクチャです。トークナイゼーションはモデルのパフォーマンスを大幅に向上させる一方、性能バイアスの導入、敵対的攻撃に対する脆弱性の増加、文字レベルのモデリング効果の低下、モデリング複雑性の増加などの欠点も数多く存在します。SpaceByteは、トークナイザーの利点を維持しつつ、上記の欠点を効果的に解決します。バイトレベルのTransformerを基盤として使用し、特に単語境界を示すスペースなどのバイトに遭遇した際に、モデルの階層の中間により大きなTransformerブロックを挿入します。このアーキテクチャは、同じトレーニングと推論計算リソースの予算下で、他のバイトレベルのモデルを凌駕するだけでなく、トークナイゼーションを使用するTransformerモデルと同等の性能を達成することもできます。

AIモデル

48.6K

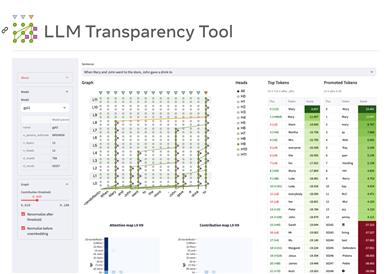

LLM透明性ツール

LLM Transparency Tool(LLM-TT)は、Transformerベースの言語モデルの内部動作メカニズムを分析するためのオープンソースの対話型ツールキットです。ユーザーはモデルを選択し、プロンプトを追加して推論を実行することで、モデルの注意機構の流れと情報伝達経路を視覚的に表示できます。このツールは、モデルの透明性を高め、研究者や開発者が言語モデルをより深く理解し、改善するのに役立つことを目的としています。

AIモデル

59.3K

Infini Attention

Googleが開発した「Infini-attention」技術は、Transformerベースの大規模言語モデルを拡張し、無限長の入力を処理することを目指しています。圧縮メモリ機構により無限長の入力処理を実現し、複数の長シーケンスタスクで優れた性能を発揮します。技術的手法には、圧縮メモリ機構、局所的および長期的な注意機構の組み合わせ、ストリーミング処理能力などが含まれます。実験結果では、長文脈言語モデル、キーコンテキストブロック検索、書籍要約タスクにおいて性能優位性が示されています。

AIモデル

52.7K

Qwen1.5 32B

Qwen1.5は、Transformerアーキテクチャに基づくデコーダ言語モデルシリーズであり、様々な規模のモデルが含まれています。SwiGLU活性化関数、Attention QKVバイアス、グループクエリAttentionなどの特徴を備えています。複数の自然言語とコードをサポートしています。SFT、RLHFなどの後続の学習を行うことを推奨します。価格は無料です。

AIモデル

57.1K

Starcoder2

StarCoder2は、1500億パラメータのTransformerモデルです。GitHubを含む600種類以上のプログラミング言語データセットで事前学習されており、Grouped Query Attentionなどの技術が使用されています。このモデルはコード生成タスクに使用でき、複数のプログラミング言語に対応しています。

AIコード生成

129.4K

- 1

- 2

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

40.8K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

40.3K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

39.7K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

39.5K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

40.3K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

39.2K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M