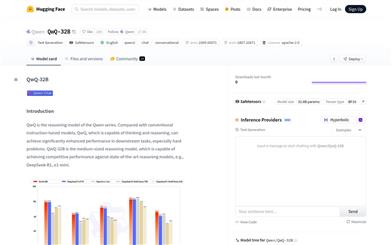

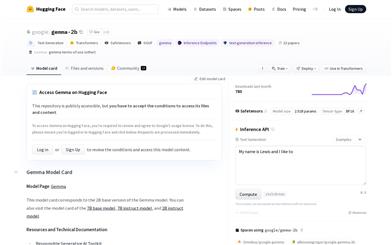

Qwq 32B

QwQ-32B 是 Qwen 系列的推理模型,专注于复杂问题的思考和推理能力。它在下游任务中表现出色,尤其是在解决难题方面。该模型基于 Qwen2.5 架构,经过预训练和强化学习优化,具有 325 亿参数,支持 131072 个完整上下文长度的处理能力。其主要优点包括强大的推理能力、高效的长文本处理能力和灵活的部署选项。该模型适用于需要深度思考和复杂推理的场景,如学术研究、编程辅助和创意写作等。

AI模型

77.8K

ART

ART 是一种基于深度学习的图像生成技术,专注于生成可变多层透明图像。它通过匿名区域布局和 Transformer 架构,实现了高效的多层图像生成。该技术的主要优点包括高效性、灵活性以及对多层图像生成的支持。它适用于需要精确控制图像层的场景,如图形设计、视觉特效等领域。目前未明确提及价格和具体定位,但其技术特性表明它可能面向专业用户和企业级应用。

AI设计工具

80.6K

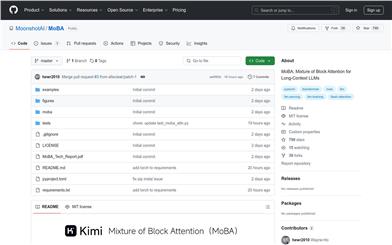

Moba

MoBA(Mixture of Block Attention)是一种创新的注意力机制,专为长文本上下文的大语言模型设计。它通过将上下文划分为块,并让每个查询令牌学习关注最相关的块,从而实现高效的长序列处理。MoBA 的主要优点是能够在全注意力和稀疏注意力之间无缝切换,既保证了性能,又提高了计算效率。该技术适用于需要处理长文本的任务,如文档分析、代码生成等,能够显著降低计算成本,同时保持模型的高性能表现。MoBA 的开源实现为研究人员和开发者提供了强大的工具,推动了大语言模型在长文本处理领域的应用。

模型训练与部署

54.1K

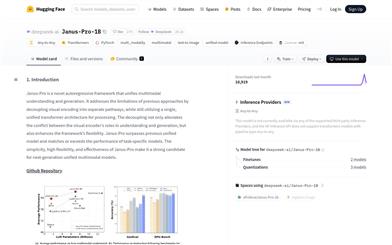

Janus Pro 1B

Janus-Pro-1B 是一个创新的多模态模型,专注于统一多模态理解和生成。它通过分离视觉编码路径,解决了传统方法在理解和生成任务中的冲突问题,同时保持了单个统一的 Transformer 架构。这种设计不仅提高了模型的灵活性,还使其在多模态任务中表现出色,甚至超越了特定任务的模型。该模型基于 DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-base 构建,使用 SigLIP-L 作为视觉编码器,支持 384x384 的图像输入,并采用特定的图像生成 tokenizer。其开源性和灵活性使其成为下一代多模态模型的有力候选。

AI模型

71.5K

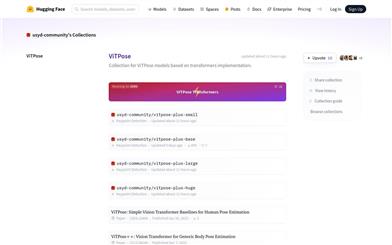

Vitpose

ViTPose是一系列基于Transformer架构的人体姿态估计模型。它利用Transformer的强大特征提取能力,为人体姿态估计任务提供了简单而有效的基线。ViTPose模型在多个数据集上表现出色,具有较高的准确性和效率。该模型由悉尼大学社区维护和更新,提供了多种不同规模的版本,以满足不同应用场景的需求。在Hugging Face平台上,ViTPose模型以开源的形式供用户使用,用户可以方便地下载和部署这些模型,进行人体姿态估计相关的研究和应用开发。

AI模型

53.8K

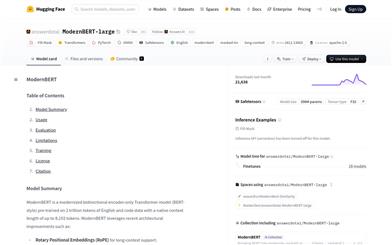

Modernbert Large

ModernBERT-large是一个现代化的双向编码器Transformer模型(BERT风格),在2万亿个英文和代码数据上预训练,具有长达8192个token的原生上下文长度。该模型采用了最新的架构改进,如旋转位置嵌入(RoPE)以支持长上下文,局部-全局交替注意力以提高长输入的效率,以及无填充和Flash Attention以提高推理效率。ModernBERT-long适合处理需要处理长文档的任务,如检索、分类和大型语料库中的语义搜索。模型训练数据主要是英文和代码,因此可能在其他语言上的表现会较低。

AI搜索

52.2K

Modernbert

ModernBERT是由Answer.AI和LightOn共同发布的新一代编码器模型,它是BERT模型的全面升级版,提供了更长的序列长度、更好的下游性能和更快的处理速度。ModernBERT采用了最新的Transformer架构改进,特别关注效率,并使用了现代数据规模和来源进行训练。作为编码器模型,ModernBERT在各种自然语言处理任务中表现出色,尤其是在代码搜索和理解方面。它提供了基础版(139M参数)和大型版(395M参数)两种模型尺寸,适合各种规模的应用需求。

AI模型

51.3K

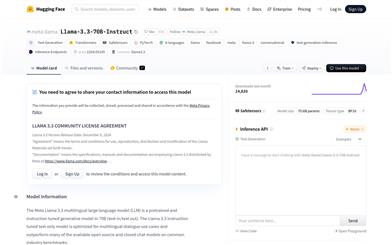

Llama 3.3 70B Instruct

Llama-3.3-70B-Instruct是由Meta开发的一个70亿参数的大型语言模型,专门针对多语言对话场景进行了优化。该模型使用优化的Transformer架构,并通过监督式微调(SFT)和基于人类反馈的强化学习(RLHF)来提高其有用性和安全性。它支持多种语言,并能够处理文本生成任务,是自然语言处理领域的一项重要技术。

聊天机器人

59.3K

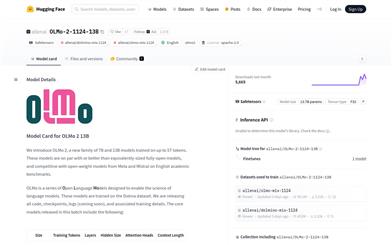

Olmo 2 13B

OLMo 2 13B是由Allen Institute for AI (Ai2)开发的一款基于Transformer的自回归语言模型,专注于英文学术基准测试。该模型在训练过程中使用了高达5万亿个token,展现出与同等规模的全开放模型相媲美或更优的性能,并在英语学术基准上与Meta和Mistral的开放权重模型竞争。OLMo 2 13B的发布包括所有代码、检查点、日志和相关的训练细节,旨在推动语言模型的科学研究。

AI模型

48.0K

Star Attention

Star-Attention是NVIDIA提出的一种新型块稀疏注意力机制,旨在提高基于Transformer的大型语言模型(LLM)在长序列上的推理效率。该技术通过两个阶段的操作显著提高了推理速度,同时保持了95-100%的准确率。它与大多数基于Transformer的LLM兼容,无需额外训练或微调即可直接使用,并且可以与其他优化方法如Flash Attention和KV缓存压缩技术结合使用,进一步提升性能。

模型训练与部署

50.5K

Mobilellm 1B

Meta 开发的自回归语言模型,采用优化架构,适合资源受限设备。优点多,如集成多种技术,支持零样本推理等,价格免费,面向自然语言处理研究人员和开发者。

AI模型

46.4K

Mobilellm 600M

MobileLLM-600M是由Meta开发的自回归语言模型,采用了优化的Transformer架构,专为资源受限的设备端应用而设计。该模型集成了SwiGLU激活函数、深度薄架构、嵌入共享和分组查询注意力等关键技术。MobileLLM-600M在零样本常识推理任务上取得了显著的性能提升,与之前的125M/350M SoTA模型相比,分别提高了2.7%/4.3%的准确率。该模型的设计理念可扩展至更大模型,如MobileLLM-1B/1.5B,均取得了SoTA结果。

AI模型

49.1K

Mobilellm 350M

MobileLLM-350M是由Meta开发的自回归语言模型,采用优化的Transformer架构,专为设备端应用设计,以满足资源受限的环境。该模型整合了SwiGLU激活函数、深层薄架构、嵌入共享和分组查询注意力等关键技术,实现了在零样本常识推理任务上的显著准确率提升。MobileLLM-350M在保持较小模型尺寸的同时,提供了与更大模型相媲美的性能,是设备端自然语言处理应用的理想选择。

AI模型

45.3K

Oasis

Oasis是由Decart AI开发的首个可玩、实时、开放世界的AI模型,它是一个互动视频游戏,由Transformer端到端生成,基于逐帧生成。Oasis能够接收用户键盘和鼠标输入,实时生成游戏玩法,内部模拟物理、游戏规则和图形。该模型通过直接观察游戏玩法学习,允许用户移动、跳跃、拾取物品、破坏方块等。Oasis被视为研究更复杂交互世界的基础模型的第一步,未来可能取代传统的游戏引擎。Oasis的实现需要模型架构的改进和模型推理技术的突破,以实现用户与模型的实时交互。Decart AI采用了最新的扩散训练和Transformer模型方法,并结合了大型语言模型(LLMs)来训练一个自回归模型,该模型可以根据用户即时动作生成视频。此外,Decart AI还开发了专有的推理框架,以提供NVIDIA H100 Tensor Core GPU的峰值利用率,并支持Etched即将推出的Sohu芯片。

游戏生成

119.0K

SLM Survey

SLM_Survey是一个专注于小型语言模型(SLMs)的研究项目,旨在通过调研和测量,提供对这些模型的深入了解和技术评估。该项目涵盖了基于Transformer的、仅解码器的语言模型,参数范围在100M至5B之间。通过对59个最先进的开源SLMs进行调研,分析了它们的技术创新,并在多个领域评估了它们的能力,包括常识推理、上下文学习、数学和编程。此外,还对它们的运行时成本进行了基准测试,包括推理延迟和内存占用。这些研究对于推动SLMs领域的研究具有重要价值。

AI学术研究

47.2K

ACE: All Round Creator And Editor Following Instructions Via Diffusion Transformer

ACE是一个基于扩散变换的全能创造者和编辑器,它能够通过统一的条件格式Long-context Condition Unit (LCU)输入,实现多种视觉生成任务的联合训练。ACE通过高效的数据收集方法解决了训练数据缺乏的问题,并通过多模态大型语言模型生成准确的文本指令。ACE在视觉生成领域具有显著的性能优势,可以轻松构建响应任何图像创建请求的聊天系统,避免了视觉代理通常采用的繁琐流程。

AI图像生成

56.6K

优质新品

Llama 3.2 1B

Llama-3.2-1B是由Meta公司发布的多语言大型语言模型,专注于文本生成任务。该模型使用优化的Transformer架构,并通过监督式微调(SFT)和人类反馈的强化学习(RLHF)进行调优,以符合人类对有用性和安全性的偏好。该模型支持8种语言,包括英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语,并在多种对话使用案例中表现优异。

AI模型

52.7K

Opencity

OpenCity是一个开源的时空基础模型,专注于交通预测领域。该模型通过整合Transformer架构和图神经网络,有效捕捉和标准化交通数据中的复杂时空依赖关系,实现对不同城市环境的零样本泛化。它在大规模、异构的交通数据集上进行预训练,学习到丰富、可泛化的表示,能够无缝应用于多种交通预测场景。

AI模型

59.3K

Bailing TTS

Bailing-TTS是由Giant Network的AI Lab开发的大型文本到语音(TTS)模型系列,专注于生成高质量的中文方言语音。该模型采用持续的半监督学习和特定的Transformer架构,通过多阶段训练过程,有效对齐文本和语音标记,实现中文方言的高质量语音合成。Bailing-TTS在实验中展现出接近人类自然表达的语音合成效果,对于方言语音合成领域具有重要意义。

AI语音合成

206.7K

Tele FLM 1T

Tele-FLM-1T是一个开源的1T多语言大型语言模型,基于解码器仅Transformer架构,经过约2T tokens的训练。该模型在规模上展现出卓越的性能,有时甚至超越了更大的模型。除了分享模型权重外,还提供了核心设计、工程实践和训练细节,期待对学术和工业社区都有所裨益。

AI模型

48.3K

优质新品

DCLM 7B

DCLM-Baseline-7B是一个7亿参数的语言模型,由DataComp for Language Models (DCLM)团队开发,主要使用英语。该模型旨在通过系统化的数据整理技术来提高语言模型的性能。模型训练使用了PyTorch与OpenLM框架,优化器为AdamW,学习率为2e-3,权重衰减为0.05,批次大小为2048序列,序列长度为2048个token,总训练token数达到了2.5T。模型训练硬件使用了H100 GPU。

AI模型

58.5K

优质新品

Mamba Codestral 7B V0.1

Mamba-Codestral-7B-v0.1 是 Mistral AI Team 开发的基于 Mamba2 架构的开源代码模型,性能与最先进的基于 Transformer 的代码模型相当。它在多个行业标准基准测试中表现出色,提供高效的代码生成和理解能力,适用于编程和软件开发领域。

AI代码生成

57.4K

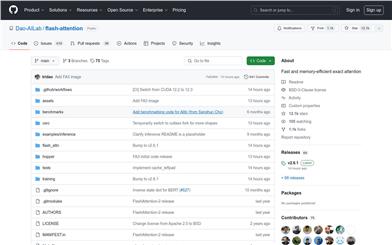

Flashattention

FlashAttention是一个开源的注意力机制库,专为深度学习中的Transformer模型设计,以提高计算效率和内存使用效率。它通过IO感知的方法优化了注意力计算,减少了内存占用,同时保持了精确的计算结果。FlashAttention-2进一步改进了并行性和工作分配,而FlashAttention-3针对Hopper GPU进行了优化,支持FP16和BF16数据类型。

AI模型

49.1K

Videollama2 7B 16F Base

VideoLLaMA2-7B-16F-Base是由DAMO-NLP-SG团队开发的大型视频语言模型,专注于视频问答(Visual Question Answering)和视频字幕生成。该模型结合了先进的空间-时间建模和音频理解能力,为多模态视频内容分析提供了强大的支持。它在视觉问答和视频字幕生成任务上展现出卓越的性能,能够处理复杂的视频内容并生成准确的描述和答案。

AI视频生成

56.6K

优质新品

Spacebyte

SpaceByte是一种全新的字节级解码架构,旨在解决大型语言模型中广泛使用的Tokenization技术所带来的一些弊端。Tokenization虽能显著提升模型性能,但也存在诸多缺陷,如引入性能偏差、增加对抗攻击脆弱性、降低字符级建模效果及增加建模复杂度等。SpaceByte在保留Tokenizer的优势基础上,有效解决了上述缺陷。它使用字节级Transformer作为基础,并在模型层次中间插入更大的Transformer块,尤其是在遇到空格等通常表示单词边界的字节时。该架构在相同的训练和推理计算资源预算下,不但超越了其他字节级模型,甚至可以与Tokenization的Transformer模型取得相当的性能。

AI模型

52.2K

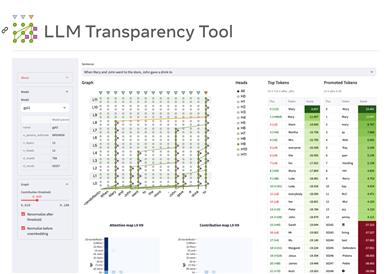

LLM Transparency Tool

LLM Transparency Tool(LLM-TT)是一个开源的交互式工具包,用于分析基于Transformer的语言模型的内部工作机制。它允许用户选择模型、添加提示并运行推理,通过可视化的方式展示模型的注意力流动和信息传递路径。该工具旨在提高模型的透明度,帮助研究人员和开发者更好地理解和改进语言模型。

AI模型

65.4K

Infini Attention

Google开发的“Infini-attention”技术旨在扩展基于Transformer的大语言模型以处理无限长的输入,通过压缩记忆机制实现无限长输入处理,并在多个长序列任务上取得优异表现。技术方法包括压缩记忆机制、局部与长期注意力的结合和流式处理能力等。实验结果显示在长上下文语言建模、密钥上下文块检索和书籍摘要任务上的性能优势。

AI模型

55.5K

Qwen1.5 32B

Qwen1.5 是基于 Transformer 架构的解码器语言模型系列,包括不同规模的模型。具有 SwiGLU 激活、注意力 QKV 偏置、组查询注意力等特性。支持多种自然语言和代码。推荐进行后续训练,如 SFT、RLHF 等。定价免费。

AI模型

58.0K

Starcoder2

StarCoder2是一个1500亿参数的Transformer模型,在包括GitHub在内的600多种编程语言数据集上进行了预训练,使用了Grouped Query Attention等技术。该模型可用于代码生成任务,支持多种编程语言。

AI代码生成

134.7K

Gemma 2b

Gemma-2b是谷歌推出的开源预训练语言模型系列,提供了多个不同规模的变体。它可以生成高质量的文本,广泛应用于问答、摘要、推理等领域。相比其他同类模型,它模型规模较小,可以部署在不同的硬件环境中。Gemma系列追求安全、高效的人工智能技术,使更多研究者和开发者可以接触前沿的语言模型技术。

AI模型

168.1K

- 1

- 2

精选AI产品推荐

中文精选

Nocode

NoCode 是一款无需编程经验的平台,允许用户通过自然语言描述创意并快速生成应用,旨在降低开发门槛,让更多人能实现他们的创意。该平台提供实时预览和一键部署功能,非常适合非技术背景的用户,帮助他们将想法转化为现实。

开发平台

97.2K

优质新品

Listenhub

ListenHub 是一款轻量级的 AI 播客生成工具,支持中文和英语,基于前沿 AI 技术,能够快速生成用户感兴趣的播客内容。其主要优点包括自然对话和超真实人声效果,使得用户能够随时随地享受高品质的听觉体验。ListenHub 不仅提升了内容生成的速度,还兼容移动端,便于用户在不同场合使用。产品定位为高效的信息获取工具,适合广泛的听众需求。

音频生成

81.1K

国外精选

Lovart

Lovart 是一款革命性的 AI 设计代理,能够将创意提示转化为艺术作品,支持从故事板到品牌视觉的多种设计需求。其重要性在于打破传统设计流程,节省时间并提升创意灵感。Lovart 当前处于测试阶段,用户可加入等候名单,随时体验设计的乐趣。

AI设计工具

100.7K

Fastvlm

FastVLM 是一种高效的视觉编码模型,专为视觉语言模型设计。它通过创新的 FastViTHD 混合视觉编码器,减少了高分辨率图像的编码时间和输出的 token 数量,使得模型在速度和精度上表现出色。FastVLM 的主要定位是为开发者提供强大的视觉语言处理能力,适用于各种应用场景,尤其在需要快速响应的移动设备上表现优异。

AI模型

83.4K

国外精选

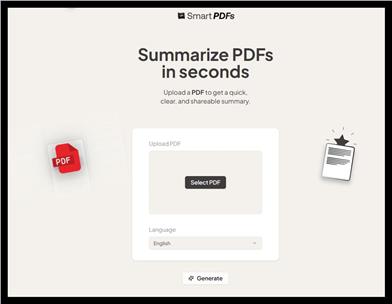

Smart PDFs

Smart PDFs 是一个在线工具,利用 AI 技术快速分析 PDF 文档,并生成简明扼要的总结。它适合需要快速获取文档要点的用户,如学生、研究人员和商务人士。该工具使用 Llama 3.3 模型,支持多种语言,是提高工作效率的理想选择,完全免费使用。

文章摘要

51.3K

Keysync

KeySync 是一个针对高分辨率视频的无泄漏唇同步框架。它解决了传统唇同步技术中的时间一致性问题,同时通过巧妙的遮罩策略处理表情泄漏和面部遮挡。KeySync 的优越性体现在其在唇重建和跨同步方面的先进成果,适用于自动配音等实际应用场景。

视频编辑

78.9K

Anyvoice

AnyVoice是一款领先的AI声音生成器,采用先进的深度学习模型,将文本转换为与人类无法区分的自然语音。其主要优点包括超真实的声音效果、多语言支持、快速生成能力以及语音定制功能。该产品适用于多种场景,如内容创作、教育、商业和娱乐制作等,旨在为用户提供高效、便捷的语音生成解决方案。目前产品提供免费试用,适合不同层次的用户。

音频生成

651.1K

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M