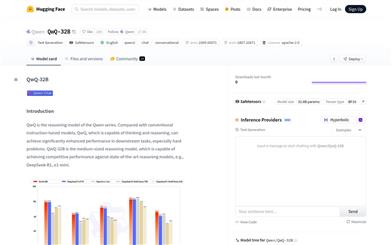

Qwq 32B

QwQ-32B 是 Qwen 系列的推理模型,專注於複雜問題的思考和推理能力。它在下游任務中表現出色,尤其是在解決難題方面。該模型基於 Qwen2.5 架構,經過預訓練和強化學習優化,具有 325 億參數,支持 131072 個完整上下文長度的處理能力。其主要優點包括強大的推理能力、高效的長文本處理能力和靈活的部署選項。該模型適用於需要深度思考和複雜推理的場景,如學術研究、編程輔助和創意寫作等。

AI模型

75.9K

ART

ART 是一種基於深度學習的圖像生成技術,專注於生成可變多層透明圖像。它通過匿名區域佈局和 Transformer 架構,實現了高效的多層圖像生成。該技術的主要優點包括高效性、靈活性以及對多層圖像生成的支持。它適用於需要精確控制圖像層的場景,如圖形設計、視覺特效等領域。目前未明確提及價格和具體定位,但其技術特性表明它可能面向專業用戶和企業級應用。

AI設計工具

77.3K

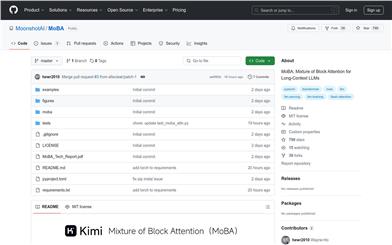

Moba

MoBA(Mixture of Block Attention)是一種創新的注意力機制,專為長文本上下文的大語言模型設計。它通過將上下文劃分為塊,並讓每個查詢令牌學習關注最相關的塊,從而實現高效的長序列處理。MoBA 的主要優點是能夠在全注意力和稀疏注意力之間無縫切換,既保證了性能,又提高了計算效率。該技術適用於需要處理長文本的任務,如文檔分析、代碼生成等,能夠顯著降低計算成本,同時保持模型的高性能表現。MoBA 的開源實現為研究人員和開發者提供了強大的工具,推動了大語言模型在長文本處理領域的應用。

模型訓練與部署

51.3K

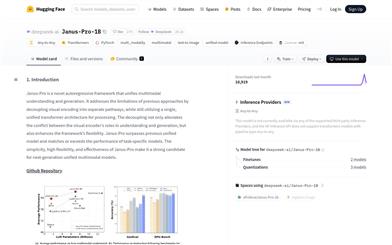

Janus Pro 1B

Janus-Pro-1B 是一個創新的多模態模型,專注於統一多模態理解和生成。它通過分離視覺編碼路徑,解決了傳統方法在理解和生成任務中的衝突問題,同時保持了單個統一的 Transformer 架構。這種設計不僅提高了模型的靈活性,還使其在多模態任務中表現出色,甚至超越了特定任務的模型。該模型基於 DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-base 構建,使用 SigLIP-L 作為視覺編碼器,支持 384x384 的圖像輸入,並採用特定的圖像生成 tokenizer。其開源性和靈活性使其成為下一代多模態模型的有力候選。

AI模型

69.3K

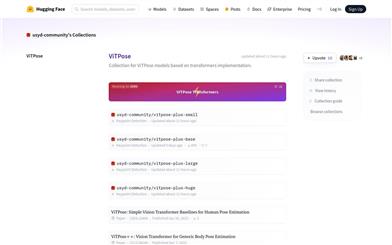

Vitpose

ViTPose是一系列基於Transformer架構的人體姿態估計模型。它利用Transformer的強大特徵提取能力,為人體姿態估計任務提供了簡單而有效的基線。ViTPose模型在多個數據集上表現出色,具有較高的準確性和效率。該模型由悉尼大學社區維護和更新,提供了多種不同規模的版本,以滿足不同應用場景的需求。在Hugging Face平臺上,ViTPose模型以開源的形式供用戶使用,用戶可以方便地下載和部署這些模型,進行人體姿態估計相關的研究和應用開發。

AI模型

50.5K

Modernbert Large

ModernBERT-large是一個現代化的雙向編碼器Transformer模型(BERT風格),在2萬億個英文和代碼數據上預訓練,具有長達8192個token的原生上下文長度。該模型採用了最新的架構改進,如旋轉位置嵌入(RoPE)以支持長上下文,局部-全局交替注意力以提高長輸入的效率,以及無填充和Flash Attention以提高推理效率。ModernBERT-long適合處理需要處理長文檔的任務,如檢索、分類和大型語料庫中的語義搜索。模型訓練數據主要是英文和代碼,因此可能在其他語言上的表現會較低。

AI搜索

50.0K

Modernbert

ModernBERT是由Answer.AI和LightOn共同發佈的新一代編碼器模型,它是BERT模型的全面升級版,提供了更長的序列長度、更好的下游性能和更快的處理速度。ModernBERT採用了最新的Transformer架構改進,特別關注效率,並使用了現代數據規模和來源進行訓練。作為編碼器模型,ModernBERT在各種自然語言處理任務中表現出色,尤其是在代碼搜索和理解方面。它提供了基礎版(139M參數)和大型版(395M參數)兩種模型尺寸,適合各種規模的應用需求。

AI模型

48.0K

Llama 3.3 70B Instruct

Llama-3.3-70B-Instruct是由Meta開發的一個70億參數的大型語言模型,專門針對多語言對話場景進行了優化。該模型使用優化的Transformer架構,並通過監督式微調(SFT)和基於人類反饋的強化學習(RLHF)來提高其有用性和安全性。它支持多種語言,並能夠處理文本生成任務,是自然語言處理領域的一項重要技術。

聊天機器人

56.9K

Olmo 2 13B

OLMo 2 13B是由Allen Institute for AI (Ai2)開發的一款基於Transformer的自迴歸語言模型,專注於英文學術基準測試。該模型在訓練過程中使用了高達5萬億個token,展現出與同等規模的全開放模型相媲美或更優的性能,並在英語學術基準上與Meta和Mistral的開放權重模型競爭。OLMo 2 13B的發佈包括所有代碼、檢查點、日誌和相關的訓練細節,旨在推動語言模型的科學研究。

AI模型

45.5K

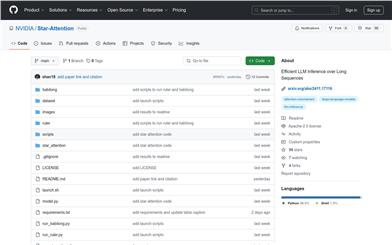

Star Attention

Star-Attention是NVIDIA提出的一種新型塊稀疏注意力機制,旨在提高基於Transformer的大型語言模型(LLM)在長序列上的推理效率。該技術通過兩個階段的操作顯著提高了推理速度,同時保持了95-100%的準確率。它與大多數基於Transformer的LLM兼容,無需額外訓練或微調即可直接使用,並且可以與其他優化方法如Flash Attention和KV緩存壓縮技術結合使用,進一步提升性能。

模型訓練與部署

48.0K

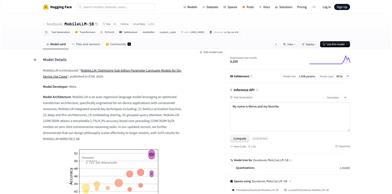

Mobilellm 1B

Meta 開發的自迴歸語言模型,採用優化架構,適合資源受限設備。優點多,如集成多種技術,支持零樣本推理等,價格免費,面向自然語言處理研究人員和開發者。

AI模型

44.4K

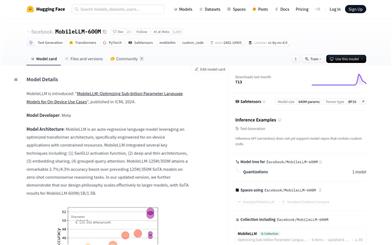

Mobilellm 600M

MobileLLM-600M是由Meta開發的自迴歸語言模型,採用了優化的Transformer架構,專為資源受限的設備端應用而設計。該模型集成了SwiGLU激活函數、深度薄架構、嵌入共享和分組查詢注意力等關鍵技術。MobileLLM-600M在零樣本常識推理任務上取得了顯著的性能提升,與之前的125M/350M SoTA模型相比,分別提高了2.7%/4.3%的準確率。該模型的設計理念可擴展至更大模型,如MobileLLM-1B/1.5B,均取得了SoTA結果。

AI模型

46.9K

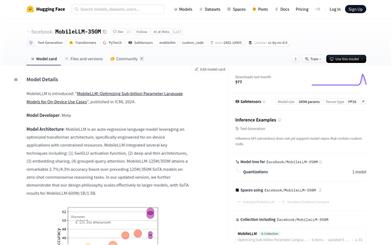

Mobilellm 350M

MobileLLM-350M是由Meta開發的自迴歸語言模型,採用優化的Transformer架構,專為設備端應用設計,以滿足資源受限的環境。該模型整合了SwiGLU激活函數、深層薄架構、嵌入共享和分組查詢注意力等關鍵技術,實現了在零樣本常識推理任務上的顯著準確率提升。MobileLLM-350M在保持較小模型尺寸的同時,提供了與更大模型相媲美的性能,是設備端自然語言處理應用的理想選擇。

AI模型

43.3K

Oasis

Oasis是由Decart AI開發的首個可玩、即時、開放世界的AI模型,它是一個互動視頻遊戲,由Transformer端到端生成,基於逐幀生成。Oasis能夠接收用戶鍵盤和鼠標輸入,即時生成遊戲玩法,內部模擬物理、遊戲規則和圖形。該模型通過直接觀察遊戲玩法學習,允許用戶移動、跳躍、拾取物品、破壞方塊等。Oasis被視為研究更復雜交互世界的基礎模型的第一步,未來可能取代傳統的遊戲引擎。Oasis的實現需要模型架構的改進和模型推理技術的突破,以實現用戶與模型的即時交互。Decart AI採用了最新的擴散訓練和Transformer模型方法,並結合了大型語言模型(LLMs)來訓練一個自迴歸模型,該模型可以根據用戶即時動作生成視頻。此外,Decart AI還開發了專有的推理框架,以提供NVIDIA H100 Tensor Core GPU的峰值利用率,並支持Etched即將推出的Sohu芯片。

遊戲生成

115.6K

SLM Survey

SLM_Survey是一個專注於小型語言模型(SLMs)的研究項目,旨在通過調研和測量,提供對這些模型的深入瞭解和技術評估。該項目涵蓋了基於Transformer的、僅解碼器的語言模型,參數範圍在100M至5B之間。通過對59個最先進的開源SLMs進行調研,分析了它們的技術創新,並在多個領域評估了它們的能力,包括常識推理、上下文學習、數學和編程。此外,還對它們的運行時成本進行了基準測試,包括推理延遲和內存佔用。這些研究對於推動SLMs領域的研究具有重要價值。

AI學術研究

45.3K

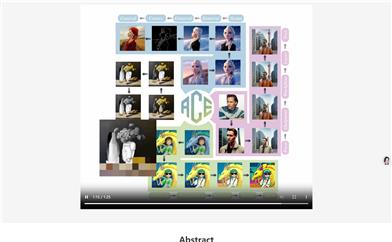

ACE: All Round Creator And Editor Following Instructions Via Diffusion Transformer

ACE是一個基於擴散變換的全能創造者和編輯器,它能夠通過統一的條件格式Long-context Condition Unit (LCU)輸入,實現多種視覺生成任務的聯合訓練。ACE通過高效的數據收集方法解決了訓練數據缺乏的問題,並通過多模態大型語言模型生成準確的文本指令。ACE在視覺生成領域具有顯著的性能優勢,可以輕鬆構建響應任何圖像創建請求的聊天系統,避免了視覺代理通常採用的繁瑣流程。

AI圖像生成

53.8K

優質新品

Llama 3.2 1B

Llama-3.2-1B是由Meta公司發佈的多語言大型語言模型,專注於文本生成任務。該模型使用優化的Transformer架構,並通過監督式微調(SFT)和人類反饋的強化學習(RLHF)進行調優,以符合人類對有用性和安全性的偏好。該模型支持8種語言,包括英語、德語、法語、意大利語、葡萄牙語、印地語、西班牙語和泰語,並在多種對話使用案例中表現優異。

AI模型

50.8K

Opencity

OpenCity是一個開源的時空基礎模型,專注於交通預測領域。該模型通過整合Transformer架構和圖神經網絡,有效捕捉和標準化交通數據中的複雜時空依賴關係,實現對不同城市環境的零樣本泛化。它在大規模、異構的交通數據集上進行預訓練,學習到豐富、可泛化的表示,能夠無縫應用於多種交通預測場景。

AI模型

56.9K

Bailing TTS

Bailing-TTS是由Giant Network的AI Lab開發的大型文本到語音(TTS)模型系列,專注於生成高質量的中文方言語音。該模型採用持續的半監督學習和特定的Transformer架構,通過多階段訓練過程,有效對齊文本和語音標記,實現中文方言的高質量語音合成。Bailing-TTS在實驗中展現出接近人類自然表達的語音合成效果,對於方言語音合成領域具有重要意義。

AI語音合成

203.7K

Tele FLM 1T

Tele-FLM-1T是一個開源的1T多語言大型語言模型,基於解碼器僅Transformer架構,經過約2T tokens的訓練。該模型在規模上展現出卓越的性能,有時甚至超越了更大的模型。除了分享模型權重外,還提供了核心設計、工程實踐和訓練細節,期待對學術和工業社區都有所裨益。

AI模型

46.1K

優質新品

DCLM 7B

DCLM-Baseline-7B是一個7億參數的語言模型,由DataComp for Language Models (DCLM)團隊開發,主要使用英語。該模型旨在通過系統化的數據整理技術來提高語言模型的性能。模型訓練使用了PyTorch與OpenLM框架,優化器為AdamW,學習率為2e-3,權重衰減為0.05,批次大小為2048序列,序列長度為2048個token,總訓練token數達到了2.5T。模型訓練硬件使用了H100 GPU。

AI模型

55.8K

優質新品

Mamba Codestral 7B V0.1

Mamba-Codestral-7B-v0.1 是 Mistral AI Team 開發的基於 Mamba2 架構的開源代碼模型,性能與最先進的基於 Transformer 的代碼模型相當。它在多個行業標準基準測試中表現出色,提供高效的代碼生成和理解能力,適用於編程和軟件開發領域。

AI代碼生成

54.4K

Flashattention

FlashAttention是一個開源的注意力機制庫,專為深度學習中的Transformer模型設計,以提高計算效率和內存使用效率。它通過IO感知的方法優化了注意力計算,減少了內存佔用,同時保持了精確的計算結果。FlashAttention-2進一步改進了並行性和工作分配,而FlashAttention-3針對Hopper GPU進行了優化,支持FP16和BF16數據類型。

AI模型

46.6K

Videollama2 7B 16F Base

VideoLLaMA2-7B-16F-Base是由DAMO-NLP-SG團隊開發的大型視頻語言模型,專注於視頻問答(Visual Question Answering)和視頻字幕生成。該模型結合了先進的空間-時間建模和音頻理解能力,為多模態視頻內容分析提供了強大的支持。它在視覺問答和視頻字幕生成任務上展現出卓越的性能,能夠處理複雜的視頻內容並生成準確的描述和答案。

AI視頻生成

54.6K

優質新品

Spacebyte

SpaceByte是一種全新的字節級解碼架構,旨在解決大型語言模型中廣泛使用的Tokenization技術所帶來的一些弊端。Tokenization雖能顯著提升模型性能,但也存在諸多缺陷,如引入性能偏差、增加對抗攻擊脆弱性、降低字符級建模效果及增加建模複雜度等。SpaceByte在保留Tokenizer的優勢基礎上,有效解決了上述缺陷。它使用字節級Transformer作為基礎,並在模型層次中間插入更大的Transformer塊,尤其是在遇到空格等通常表示單詞邊界的字節時。該架構在相同的訓練和推理計算資源預算下,不但超越了其他字節級模型,甚至可以與Tokenization的Transformer模型取得相當的性能。

AI模型

50.0K

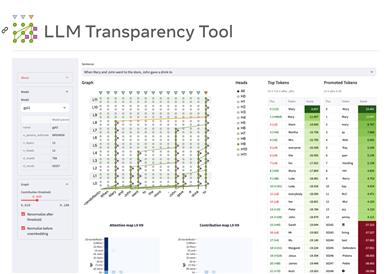

LLM Transparency Tool

LLM Transparency Tool(LLM-TT)是一個開源的交互式工具包,用於分析基於Transformer的語言模型的內部工作機制。它允許用戶選擇模型、添加提示並運行推理,通過可視化的方式展示模型的注意力流動和信息傳遞路徑。該工具旨在提高模型的透明度,幫助研究人員和開發者更好地理解和改進語言模型。

AI模型

62.9K

Infini Attention

Google開發的“Infini-attention”技術旨在擴展基於Transformer的大語言模型以處理無限長的輸入,通過壓縮記憶機制實現無限長輸入處理,並在多個長序列任務上取得優異表現。技術方法包括壓縮記憶機制、局部與長期注意力的結合和流式處理能力等。實驗結果顯示在長上下文語言建模、密鑰上下文塊檢索和書籍摘要任務上的性能優勢。

AI模型

53.0K

Qwen1.5 32B

Qwen1.5 是基於 Transformer 架構的解碼器語言模型系列,包括不同規模的模型。具有 SwiGLU 激活、注意力 QKV 偏置、組查詢注意力等特性。支持多種自然語言和代碼。推薦進行後續訓練,如 SFT、RLHF 等。定價免費。

AI模型

55.2K

Starcoder2

StarCoder2是一個1500億參數的Transformer模型,在包括GitHub在內的600多種編程語言數據集上進行了預訓練,使用了Grouped Query Attention等技術。該模型可用於代碼生成任務,支持多種編程語言。

AI代碼生成

131.7K

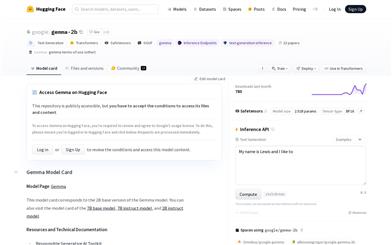

Gemma 2b

Gemma-2b是谷歌推出的開源預訓練語言模型系列,提供了多個不同規模的變體。它可以生成高質量的文本,廣泛應用於問答、摘要、推理等領域。相比其他同類模型,它模型規模較小,可以部署在不同的硬件環境中。Gemma系列追求安全、高效的人工智能技術,使更多研究者和開發者可以接觸前沿的語言模型技術。

AI模型

165.3K

- 1

- 2

精選AI產品推薦

中文精選

騰訊混元圖像 2.0

騰訊混元圖像 2.0 是騰訊最新發布的 AI 圖像生成模型,顯著提升了生成速度和畫質。通過超高壓縮倍率的編解碼器和全新擴散架構,使得圖像生成速度可達到毫秒級,避免了傳統生成的等待時間。同時,模型通過強化學習算法與人類美學知識的結合,提升了圖像的真實感和細節表現,適合設計師、創作者等專業用戶使用。

圖片生成

80.6K

國外精選

Lovart

Lovart 是一款革命性的 AI 設計代理,能夠將創意提示轉化為藝術作品,支持從故事板到品牌視覺的多種設計需求。其重要性在於打破傳統設計流程,節省時間並提升創意靈感。Lovart 當前處於測試階段,用戶可加入等候名單,隨時體驗設計的樂趣。

AI設計工具

63.8K

Fastvlm

FastVLM 是一種高效的視覺編碼模型,專為視覺語言模型設計。它通過創新的 FastViTHD 混合視覺編碼器,減少了高分辨率圖像的編碼時間和輸出的 token 數量,使得模型在速度和精度上表現出色。FastVLM 的主要定位是為開發者提供強大的視覺語言處理能力,適用於各種應用場景,尤其在需要快速響應的移動設備上表現優異。

AI模型

51.1K

Keysync

KeySync 是一個針對高分辨率視頻的無洩漏唇同步框架。它解決了傳統唇同步技術中的時間一致性問題,同時通過巧妙的遮罩策略處理表情洩漏和麵部遮擋。KeySync 的優越性體現在其在唇重建和跨同步方面的先進成果,適用於自動配音等實際應用場景。

視頻編輯

48.3K

Manus

Manus 是由 Monica.im 研發的全球首款真正自主的 AI 代理產品,能夠直接交付完整的任務成果,而不僅僅是提供建議或答案。它採用 Multiple Agent 架構,運行在獨立虛擬機中,能夠通過編寫和執行代碼、瀏覽網頁、操作應用等方式直接完成任務。Manus 在 GAIA 基準測試中取得了 SOTA 表現,展現了強大的任務執行能力。其目標是成為用戶在數字世界的‘代理人’,幫助用戶高效完成各種複雜任務。

個人助理

1.5M

Trae國內版

Trae是一款專為中文開發場景設計的AI原生IDE,將AI技術深度集成於開發環境中。它通過智能代碼補全、上下文理解等功能,顯著提升開發效率和代碼質量。Trae的出現填補了國內AI集成開發工具的空白,滿足了中文開發者對高效開發工具的需求。其定位為高端開發工具,旨在為專業開發者提供強大的技術支持,目前尚未明確公開價格,但預計會採用付費模式以匹配其高端定位。

開發與工具

137.7K

國外精選

Pika

Pika是一個視頻製作平臺,用戶可以上傳自己的創意想法,Pika會自動生成相關的視頻。主要功能有:支持多種創意想法轉視頻,視頻效果專業,操作簡單易用。平臺採用免費試用模式,定位面向創意者和視頻愛好者。

視頻生成

18.7M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M