Video MME

紹介 :

Video-MMEは、多モーダル大規模言語モデル(MLLMs)のビデオ分析における性能評価に特化したベンチマークテストです。MLLMsによる連続的な視覚データの処理能力に関する既存評価方法の空白を埋め、研究者にとって質が高く包括的な評価プラットフォームを提供します。本ベンチマークテストは、様々な長さのビデオを網羅し、MLLMsの中核能力を評価します。

ターゲットユーザー :

Video-MMEの対象ユーザーは、人工知能分野の研究者や開発者、特にビデオ理解と多モーダルインタラクションに特化した専門家です。本ベンチマークは、これらのユーザーに標準化されたテストプラットフォームを提供し、保有するMLLMsモデルの評価と改善を支援します。

使用シナリオ

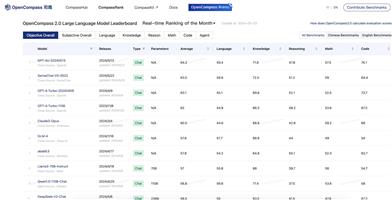

Gemini 1.5 Proによる様々なビデオの長さとサブカテゴリにおける精度スコア

GPT-4oとGPT-4Vのビデオ分析タスクにおけるパフォーマンス比較

LLaVA-NeXT-Videoモデルによる様々なビデオタスクにおけるスコア結果

製品特徴

短尺、中尺、長尺ビデオの精度スコアを提供

6つの主要分野と30のサブカテゴリに分類されたビデオタイプを含む

ビデオの長さとタスクの種類を網羅

新規収集され、人手でアノテーションされたデータを使用(既存のビデオデータセットではない)

ビデオカテゴリの階層、ビデオの長さ、タスクの種類の分布に関する統計情報を提供

他のベンチマークテストとの比較を行い、Video-MMEの独自性を強調

使用チュートリアル

Video-MMEの公式ウェブサイトにアクセスする

様々なビデオの長さとタスクの種類に対する評価基準を理解する

興味のあるMLLMsモデルを選択して性能テストを行う

モデルを提出して、様々なビデオサブカテゴリにおけるパフォーマンス結果を取得する

結果を分析し、他のモデルやベンチマークと比較する

評価結果を利用してMLLMsモデルを最適化および改善する

おすすめAI製品

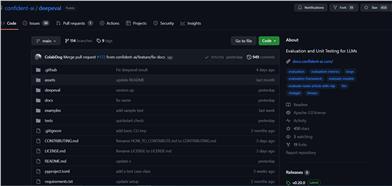

Deepeval

DeepEvalは、LLMが問題に対する回答を評価するための多角的な指標を提供し、回答が関連性があり、一貫性があり、偏りや有害な表現を含まないことを保証します。CI/CDパイプラインとの統合も容易で、機械学習エンジニアはLLMアプリケーションの改善に伴うパフォーマンスの向上を迅速に評価?検証できます。DeepEvalはPythonに優しいオフライン評価方法を提供し、パイプラインの運用準備を確実にします。それはまさに「パイプラインのためのPytest」と言えるもので、テストの通過と同じくらいシンプルで直接的な方法で、生産と評価パイプラインのプロセスを実現します。

AIモデル評価

159.8K

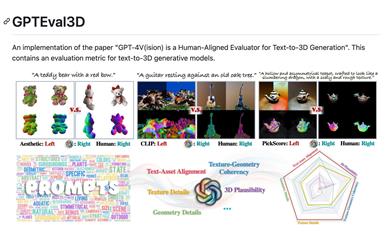

Gpteval3d

GPTEval3Dは、GPT-4Vを基盤としたオープンソースの3D生成モデル評価ツールです。テキストから3Dモデルを生成するモデルを自動的に評価し、ELOスコアを算出、既存モデルとの比較ランキングを提供します。シンプルで使いやすい設計となっており、ユーザーによるカスタム評価データセットもサポート。GPT-4Vの評価能力を最大限に活かし、3D生成タスク研究における強力なツールとなります。

AIモデル評価

75.6K