マルチモーダル大規模言語モデル

紹介 :

本ツールは、最新の独自開発およびオープンソースのMLLMを定性的研究することにより、テキスト、コード、画像、動画の4つのモダリティから、その汎化能力、信頼性、因果推論能力を評価し、MLLMの透明性を高めることを目的としています。これらの属性は、様々な下流アプリケーションを支えるMLLMの信頼性を定義する上で重要な要素であると考えています。具体的には、クローズドソースのGPT-4とGemini、ならびに6つのオープンソースLLMおよびMLLMを評価しました。全体として、230個の手動設計された事例を評価し、定性的な結果は12個のスコア(モダリティ4つ×属性3つ)に要約されています。合計で14の経験的知見を明らかにし、独自開発とオープンソースのMLLMの能力と限界を理解し、より信頼性の高い多様なモダリティの下流アプリケーションをサポートすることに役立てます。

ターゲットユーザー :

多様なモダリティの大規模言語モデルのパフォーマンスと信頼性の評価に使用

使用シナリオ

新しいマルチモーダル大規模言語モデルのテキスト生成におけるパフォーマンス評価に使用

オープンソースMLLMの画像処理における信頼性評価に使用

独自開発MLLMの動画コンテンツ理解における汎化能力評価に使用

製品特徴

MLLMの汎化能力、信頼性、因果推論能力の評価

様々な下流アプリケーションのサポート

おすすめAI製品

Deepeval

DeepEvalは、LLMが問題に対する回答を評価するための多角的な指標を提供し、回答が関連性があり、一貫性があり、偏りや有害な表現を含まないことを保証します。CI/CDパイプラインとの統合も容易で、機械学習エンジニアはLLMアプリケーションの改善に伴うパフォーマンスの向上を迅速に評価?検証できます。DeepEvalはPythonに優しいオフライン評価方法を提供し、パイプラインの運用準備を確実にします。それはまさに「パイプラインのためのPytest」と言えるもので、テストの通過と同じくらいシンプルで直接的な方法で、生産と評価パイプラインのプロセスを実現します。

AIモデル評価

159.8K

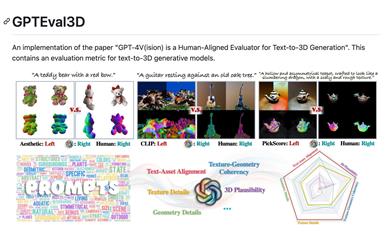

Gpteval3d

GPTEval3Dは、GPT-4Vを基盤としたオープンソースの3D生成モデル評価ツールです。テキストから3Dモデルを生成するモデルを自動的に評価し、ELOスコアを算出、既存モデルとの比較ランキングを提供します。シンプルで使いやすい設計となっており、ユーザーによるカスタム評価データセットもサポート。GPT-4Vの評価能力を最大限に活かし、3D生成タスク研究における強力なツールとなります。

AIモデル評価

75.6K