Tensordock

紹介 :

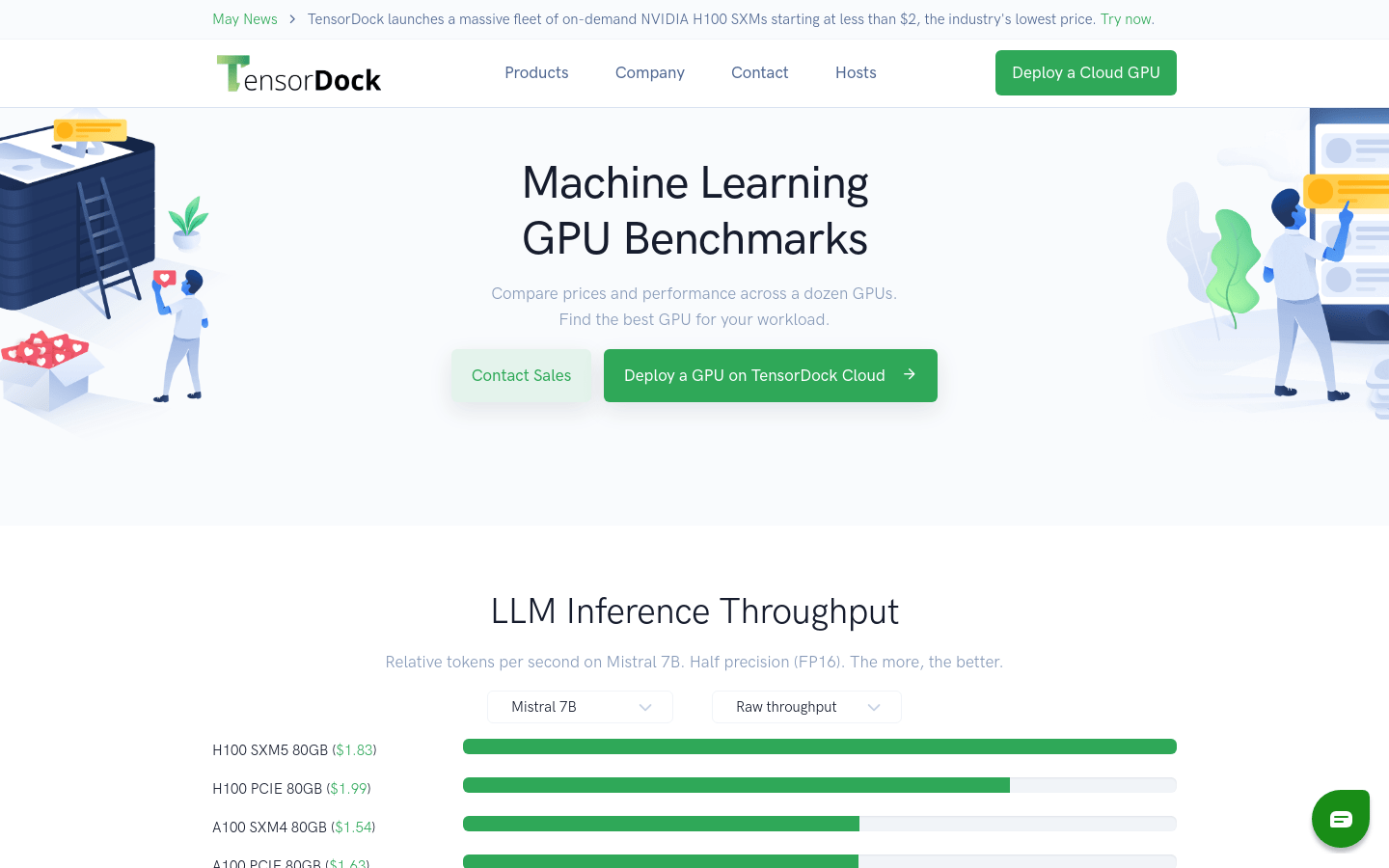

TensorDockは、妥協のない信頼性が求められるワークロードのために構築された、専門的なクラウドサービスプロバイダーです。NVIDIA H100 SXMsを含む多様なGPUサーバーオプションと、深層学習、AI、レンダリングに最適なコスト効率の高い仮想マシンインフラストラクチャを提供しています。TensorDockは、OSレベルの監視、自動スケーリング、ロードバランシング機能を備えた、完全マネージドなコンテナホスティングサービスも提供しています。さらに、TensorDockは専門家による世界クラスのエンタープライズサポートを提供しています。

ターゲットユーザー :

["深層学習研究者およびデータサイエンティスト:TensorDockが提供するGPUクラウドサービスは、大規模なモデルトレーニングやデータ分析に特に適しています。","AI開発者:TensorDockのサービスを利用して、AIモデルを迅速にデプロイおよびテストできます。","レンダリング専門家:高性能GPUによる画像およびビデオレンダリングを必要とする専門ユーザー向けに、TensorDockは必要な計算能力を提供します。","研究機関および大学:TensorDockのCPUおよびGPUクラウドサービスは、科学研究および教育活動に適しています。"]

使用シナリオ

TensorDockのGPUクラウドサービスを使用して、大規模なニューラルネットワークのトレーニングを実行します。

TensorDockのコンテナホスティングサービスを使用して、機械学習モデルをデプロイします。

TensorDockのCPUクラウドサービスを使用して、複雑な科学計算とデータ分析を実行します。

製品特徴

NVIDIA H100 SXMsなどの高性能GPUサーバーを提供

深層学習、AI、レンダリングワークロードをサポート

OSレベルの監視とロードバランシングを含む、完全マネージドなコンテナホスティングサービス

自動スケーリング機能により、様々なワークロードの需要に対応

Intel XeonおよびAMD EPYCプロセッサ搭載のCPUクラウドサービスを提供

GPUクラウドサービスはコスト効率に優れ、科学計算や高性能計算ワークロードに最適

詳細なGPUパフォーマンスベンチマークを提供し、最適なGPUの選択を支援

使用チュートリアル

ステップ1:TensorDockの公式サイトにアクセスしてアカウントを登録します。

ステップ2:ワークロードのニーズに応じて、適切なGPUまたはCPUサーバーを選択します。

ステップ3:必要なサーバーまたはコンテナをデプロイし、構成します。

ステップ4:必要なデータとアプリケーションをTensorDockが提供するクラウドサービスにアップロードします。

ステップ5:深層学習モデルのトレーニング、AIモデルの推論、またはレンダリング作業を開始します。

ステップ6:TensorDockの監視ツールを使用して、サーバーのパフォーマンスとリソースの使用状況をリアルタイムで追跡します。

ステップ7:必要に応じてリソース構成を調整し、ワークロードのパフォーマンスを最適化します。

おすすめAI製品

Pseudoeditor

PseudoEditorは無料で使用できるオンライン擬似コードエディタです。構文の強調表示や自動補完などの機能を備えており、擬似コードの作成を容易にします。さらに、内蔵の擬似コードコンパイラ機能でテストすることも可能です。ダウンロード不要ですぐにご利用いただけます。

開発とツール

3.8M

Coze

Cozeは、次世代AIチャットボット構築プラットフォームです。AIチャットボットアプリケーションの迅速な作成、デバッグ、最適化が可能です。コーディング不要で、チャットボットを簡単に作成し、様々なプラットフォームに公開できます。豊富なプラグインも提供しており、データとの連携、アイデアをボットスキルへの変換、長期記憶の装備、会話の開始など、ボットの機能を拡張できます。

開発とツール

3.7M