バイトダンス Flux

Fluxは、バイトダンスが開発した高性能通信オーバーラップライブラリで、GPU上のテンソルとエキスパート並列化のために設計されています。効率的なカーネルとPyTorchとの互換性により、さまざまな並列化戦略をサポートし、大規模モデルの訓練と推論に適しています。Fluxの主な利点には、高性能、容易な統合、およびさまざまなNVIDIA GPUアーキテクチャのサポートが含まれます。大規模分散型訓練、特にMixture-of-Experts(MoE)モデルにおいて優れたパフォーマンスを発揮し、計算効率を大幅に向上させることができます。

モバイルショッピングとオンライン

43.6K

3FS

3FSは、AIトレーニングと推論ワークロード向けに設計された高性能分散ファイルシステムです。最新のSSDとRDMAネットワークを活用し、共有ストレージ層を提供することで、分散アプリケーションの開発を簡素化します。その主な利点は、高性能、強力な整合性、およびさまざまなワークロードへの対応であり、AI開発と展開の効率を大幅に向上させることができます。このシステムは大規模なAIプロジェクトに適しており、特にデータ準備、トレーニング、および推論フェーズで優れた性能を発揮します。

開発とツール

44.2K

Evo 2

Evo 2は、NVIDIAが開発したAI基盤モデルで、深層学習技術を用いて生体分子の遺伝暗号を解読することを目的としています。NVIDIA DGX Cloudプラットフォームを基盤として開発され、大規模なゲノムデータを処理でき、生物医学研究に強力なツールを提供します。Evo 2の主な利点は、最大100万トークンの遺伝子配列を処理できるため、ゲノムの複雑性をより包括的に理解できることです。このモデルは、疾患診断、医薬品開発、遺伝子編集など、生物医学分野での幅広い応用が期待されています。Evo 2の開発はArc研究所とスタンフォード大学によって支援されており、生物医学研究の革新と飛躍的な進歩を目指しています。

AIモデル

43.3K

高品質新製品

Deepgemm

DeepGEMMは、効率的なFP8行列乗算に特化したCUDAライブラリです。Hopper TMA特性、永続スレッド特殊化、全JIT設計などの細粒度スケーリングと様々な最適化技術により、行列演算の性能を大幅に向上させます。このライブラリは主に深層学習と高性能計算の分野を対象としており、効率的な行列演算が必要な場面に適しています。NVIDIA HopperアーキテクチャのTensor Coreをサポートし、様々な行列形状で卓越した性能を発揮します。DeepGEMMは設計が簡潔で、コアコードは約300行と少なく、容易に学習?使用でき、同時に専門家が最適化したライブラリと同等かそれ以上の性能を発揮します。オープンソースかつ無料であるため、深層学習の最適化と開発を行う研究者や開発者にとって理想的な選択肢となります。

開発とツール

44.4K

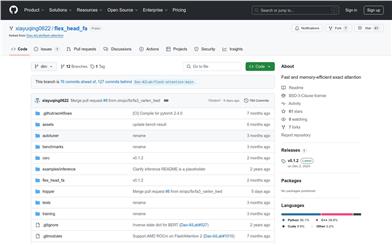

Flexheadfa

FlexHeadFAは、FlashAttentionを改良したモデルであり、高速かつメモリ効率の高い正確なアテンションメカニズムを提供することに重点を置いています。柔軟なヘッド次元の構成に対応しており、大規模言語モデルのパフォーマンスと効率を大幅に向上させることができます。主な利点としては、GPUリソースの効率的な利用、様々なヘッド次元の構成への対応、FlashAttention-2およびFlashAttention-3との互換性などが挙げられます。計算効率とメモリ最適化が必要な深層学習のシナリオ、特に長シーケンスデータの処理において優れた性能を発揮します。

モデルトレーニングとデプロイメント

45.0K

高品質新製品

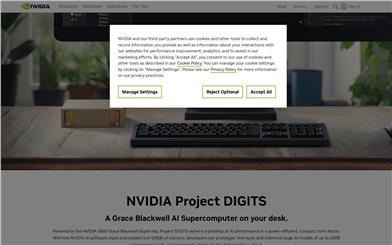

NVIDIA Project DIGITS

NVIDIA Project DIGITSは、NVIDIA GB10 Grace Blackwellスーパーチップをベースとしたデスクトップ型スーパーコンピューターで、AI開発者に強力なAI性能を提供することを目的としています。消費電力が効率的でコンパクトな設計ながら、毎秒一千万億回のAI演算性能を実現します。NVIDIA AIソフトウェアスタックがプリインストールされており、128GBのメモリを搭載しているため、開発者は最大2000億パラメーターの大規模AIモデルのローカルでのプロトタイピング、ファインチューニング、推論を行い、データセンターやクラウドにシームレスに展開できます。Project DIGITSの登場は、AI開発とイノベーションを促進するNVIDIAの重要なマイルストーンであり、開発者にAIモデルの開発と展開を加速するための強力なツールを提供します。

開発プラットフォーム

47.5K

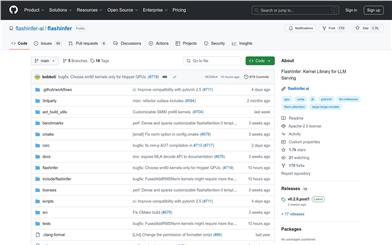

Flashinfer

FlashInferは、大規模言語モデル(LLM)サービス向けに設計された高性能GPUカーネルライブラリです。効率的な疎/密なアテンションメカニズム、負荷分散スケジューリング、メモリ効率の最適化などの機能を提供することで、LLMの推論とデプロイにおけるパフォーマンスを大幅に向上させます。FlashInferはPyTorch、TVM、C++ APIをサポートし、既存のプロジェクトに容易に統合できます。主な利点としては、効率的なカーネル実装、柔軟なカスタマイズ機能、幅広い互換性などが挙げられます。FlashInferは、増加の一途を辿るLLMアプリケーションのニーズに応え、より効率的で信頼性の高い推論サポートを提供するために開発されました。

開発とツール

50.0K

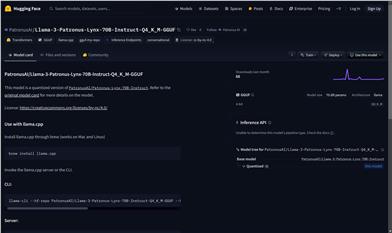

Llama 3 Patronus Lynx 70B Instruct Q4 K M GGUF

PatronusAI/Llama-3-Patronus-Lynx-70B-Instruct-Q4_K_M-GGUFは、70Bパラメータの大規模量子化言語モデルです。4ビット量子化技術を用いてモデルサイズを削減し、推論効率を向上させています。PatronusAIシリーズに属し、Transformersライブラリを基盤として構築されており、高性能な自然言語処理を必要とするアプリケーションシナリオに適しています。モデルはcc-by-nc-4.0ライセンスに従い、非営利目的での使用と共有が可能です。

AIモデル

44.4K

Flagcx

FlagCXは、北京人工智能研究院(BAAI)の支援を受けて開発された、拡張性と適応性に優れたチップ間通信ライブラリです。FlagAI-Openオープンソース計画の一部であり、AI技術のオープンソースエコシステムの促進を目指しています。FlagCXはネイティブな集団通信ライブラリを活用し、様々なプラットフォームでのシングルチップ通信を包括的にサポートしています。サポートされている通信バックエンドには、NCCL、IXCCL、CNCLが含まれます。

開発とツール

46.4K

EXAONE 3.5 32B Instruct AWQ

EXAONE-3.5-32B-Instruct-AWQは、LG AI Researchが開発した、指示調整済みの英語と韓国語のバイリンガル生成モデルシリーズです。パラメーター数は2.4Bから32Bまで様々です。これらのモデルは最大32Kトークンのロングコンテキスト処理に対応し、現実世界のユースケースやロングコンテキスト理解において最先端の性能を発揮すると同時に、最近発表された同規模のモデルと比較して、汎用領域においても競争力を維持しています。AWQ量子化技術により、4ビットグループレベルの重み量子化を実現し、モデルの配置効率を最適化しています。

AIモデル

45.5K

中国語精選

Deepseek V3

DeepSeek-V3は、総パラメータ数6710億、活性化パラメータ数370億の強力なMixture-of-Experts(MoE)言語モデルです。DeepSeek-V2で実証済みのMulti-head Latent Attention(MLA)とDeepSeekMoEアーキテクチャを採用しています。さらに、DeepSeek-V3では、初めて補助損失なしの負荷均衡戦略を採用し、多トークン予測トレーニング目標を設定することで、より強力な性能を実現しました。DeepSeek-V3は14.8兆の高品質トークンで事前学習され、その後、教師あり微調整と強化学習段階を経て、その能力を最大限に活用しています。総合的な評価によると、DeepSeek-V3は他のオープンソースモデルを凌駕し、主要なクローズドソースモデルと同等の性能に達しています。優れた性能にもかかわらず、DeepSeek-V3の完全なトレーニングにはわずか2.788M H800 GPU時間しか必要なく、トレーニングプロセスは非常に安定しています。

AIモデル

695.0K

Fastvideo

FastVideoは、大規模ビデオ拡散モデルの高速化を目的としたオープンソースフレームワークです。一貫性蒸留ビデオ拡散モデルとしてFastHunyuanとFastMochiの2種類を提供し、推論速度を8倍に向上させます。FastVideoはPCM(Phased-Consistency-Model)に基づき、オープンなビデオDiT蒸留レシピを初めて提供し、MochiやHunyuanなど、最先端のオープンなビデオDiTモデルの蒸留、微調整、推論をサポートします。さらに、FSDP、シーケンシャル並列処理、選択的活性化チェックポイントによる拡張可能なトレーニング、LoRA、事前計算潜在変数、事前計算テキスト埋め込みによるメモリ効率の高い微調整をサポートします。FastVideoの開発は現在進行中で、技術的には高度に実験的な段階であり、今後の計画としては、蒸留方法の追加、より多くのモデルのサポート、コードの更新などが含まれます。

映像制作

51.3K

Trillium TPU

Trillium TPUは、Google Cloudの第6世代Tensor Processing Unit(TPU)であり、AIワークロード向けに設計されており、強化された性能と費用対効果を提供します。Google Cloud AI Hypercomputerの主要コンポーネントとして、統合されたハードウェアシステム、オープンソースソフトウェア、最先端の機械学習フレームワーク、柔軟な消費モデルを通じて、大規模AIモデルのトレーニング、ファインチューニング、推論をサポートします。Trillium TPUは、性能、コスト効率、持続可能性の面で大幅な向上を実現し、AI分野における重要な進歩です。

モデルトレーニングとデプロイ

44.2K

Deepseek V2.5 1210

DeepSeek-V2.5-1210はDeepSeek-V2.5のアップグレード版であり、数学、コーディング、ライティング推論など、複数の能力において改良が加えられています。MATH-500ベンチマークテストでの性能は74.8%から82.8%に向上し、LiveCodebench (08.01 - 12.01)ベンチマークテストでの精度は29.2%から34.38%に向上しました。さらに、ファイルアップロードとウェブページサマリー機能のユーザーエクスペリエンスも最適化されています。DeepSeek-V2シリーズ(基本版とチャット版を含む)は商用利用をサポートしています。

コードアシスタント

59.3K

Rain AI

Rain AIは、高効率な人工知能ハードウェアの開発に特化しています。エネルギー消費量の増加が懸念される現代において、Rain AIの製品はハードウェア設計の最適化により、高性能を維持しながらエネルギー消費量を削減します。これは、データセンターや大量の計算資源を必要とする企業にとって非常に重要です。主な利点として、高効率性、高性能、環境への配慮が挙げられます。Rain AIは、技術革新を通じて環境への影響を軽減し、人工知能技術の持続可能な発展に尽力しています。価格やターゲット層は明確にされていませんが、高性能計算を必要とし、エネルギー効率に高い要求を持つ企業をターゲットにしていると考えられます。

ハードウェア

44.2K

Falcon Mamba 7b

tiiuae/falcon-mamba-7bは、TII UAEによって開発された、Mambaアーキテクチャに基づく高性能因果言語モデルです。生成タスク向けに設計されており、複数のベンチマークテストで優れた性能を示しています。様々なハードウェア構成で動作し、性能とリソースの必要性に応じて、複数の精度設定に対応しています。高度な3D並列化戦略とZeRO最適化技術を用いて訓練されており、大規模GPUクラスタ上での効率的な訓練を可能にしています。

AIモデル

42.2K

AMD Instinct MI325X アクセラレータ

AMD Instinct MI325Xアクセラレータは、AMD CDNA 3アーキテクチャに基づいており、基礎モデルのトレーニング、ファインチューニング、推論など、AIタスク向けに設計されています。卓越した性能と効率性を提供し、システム、ラック、データセンターレベルでの高性能かつ最適化されたAIソリューションの構築をAMDのお客様とパートナーに可能にします。AMD Instinct MI325Xアクセラレータは、業界をリードするメモリ容量と帯域幅を提供し、6.0TB/sの256GB HBM3Eをサポートしています。これは、H200と比較して容量が1.8倍、帯域幅が1.3倍向上しており、FP16およびFP8計算性能の大幅な向上を実現しています。

AIモデル

43.1K

Intel Gaudi 3 AIアクセラレータ

Intel? Gaudi? 3 AIアクセラレータは、インテルが提供する高性能人工知能アクセラレータです。効率的なIntel? Gaudi?プラットフォームをベースに構築されており、優れたMLPerfベンチマーク性能を備え、要求の厳しいトレーニングと推論タスクの処理を目的としています。このアクセラレータは、データセンターやクラウドにおける大規模言語モデル、マルチモーダルモデル、エンタープライズRAGなどのAIアプリケーションに対応し、既に所有しているイーサネットインフラストラクチャ上で動作します。単一のアクセラレータでも数千個のアクセラレータでも、Intel Gaudi 3はAIの成功に重要な役割を果たします。

AIモデル推論トレーニング

46.1K

Groq

Groqは、AIモデルに超低遅延の推論サービスを提供することに特化した、高性能AIチップとクラウドサービスを提供する企業です。2024年2月ローンチされたGroqCloud?は、既に46万7千人を超える開発者にご利用いただいています。GroqのAIチップ技術はMeta社のチーフAIサイエンティストであるYann LeCun氏から技術サポートを受けており、BlackRock社主導の6.4億ドルの資金調達を受け、企業価値は28億ドルに達しています。Groqの技術的優位性は、他のプロバイダーからのGroqへのシームレスな移行がわずか3行のコード変更で可能で、OpenAIのエンドポイントと互換性がある点にあります。GroqのAIチップは、AIチップ市場におけるNvidia社のリーダーシップに挑み、開発者と企業により高速で効率的なAI推論ソリューションを提供することを目指しています。

開発とツール

239.3K

Qwen2.5 LLM

Qwen2.5シリーズ言語モデルは、0.5Bから72Bパラメータまで様々な規模の、オープンソースのdecoder-only稠密モデルです。異なる製品のモデル規模のニーズに対応することを目指しています。これらのモデルは、自然言語理解、コード生成、数学的推論など、複数の分野で優れた性能を発揮し、特に高性能な言語処理能力を必要とするアプリケーションシナリオに適しています。Qwen2.5シリーズモデルの公開は、大規模言語モデル分野における重要な進歩を示し、開発者と研究者に強力なツールを提供します。

AIモデル

48.3K

海外精選

Cerebras Inference

Cerebras Inferenceは、Cerebras社が提供するAI推論プラットフォームです。GPUの20倍の速度と1/5のコストを実現します。Cerebrasの高性能計算技術を活用し、大規模言語モデルや高性能計算などに、迅速かつ効率的な推論サービスを提供します。医療、エネルギー、政府、金融サービスなど、様々な業界のAIモデルに対応し、オープンソースであるため、ユーザーは独自の基盤モデルのトレーニングやオープンソースモデルのファインチューニングが可能です。

モデルトレーニングとデプロイ

50.8K

海外精選

Graphcore

Graphcoreは、高性能コンピューティングを必要とする人工知能分野をターゲットとした、人工知能ハードウェアアクセラレータに特化した企業です。GraphcoreのIPU(インテリジェントプロセッシングユニット)テクノロジーは、機械学習、深層学習などのAIアプリケーションに強力な計算能力を提供します。クラウドIPU、データセンターIPU、Bow IPUプロセッサなどを含む同社の製品は、Poplar? Softwareによって最適化されており、AIモデルのトレーニングと推論速度を大幅に向上させます。Graphcoreの製品とテクノロジーは、金融、バイオテクノロジー、研究など複数の業界で活用されており、企業や研究機関がAIプロジェクトの実験プロセスを加速し、効率性を向上させる支援をしています。

AIモデル

51.1K

Skywork MoE Base FP8

Skywork-MoEは、146億パラメーターを持つ高性能な混合専門家(MoE)モデルです。16のエキスパートと22億の活性化パラメーターを備えています。このモデルは、Skywork-13Bモデルの密集型チェックポイントから初期化されています。2つの革新的な技術、ゲート付きロジック正規化(専門家の多様性を強化)と適応型補助損失係数(層固有の補助損失係数の調整を可能にする)が導入されています。Skywork-MoEは、C-Eval、MMLU、CMMLU、GSM8K、MATH、HumanEvalなどの様々な一般的なベンチマークテストにおいて、パラメーター数が多いモデルや活性化パラメーター数が多いモデルと同等かそれ以上の性能を示しています。

AIモデル

44.4K

クルソー?クラウド

クルソーは、高性能コンピューティングとAI向けに最適化された、拡張性のある気候変動対策に配慮したデジタルインフラストラクチャを提供します。廃棄エネルギー、孤立したエネルギー源、またはクリーンエネルギーを活用することで温室効果ガスの排出量を削減し、エネルギー転換を支援し、資源効率を最大化するという革新的なアプローチを採用しています。

AIモデル

51.9K

海外精選

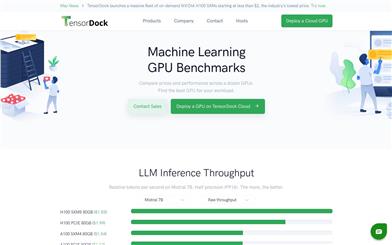

Tensordock

TensorDockは、妥協のない信頼性が求められるワークロードのために構築された、専門的なクラウドサービスプロバイダーです。NVIDIA H100 SXMsを含む多様なGPUサーバーオプションと、深層学習、AI、レンダリングに最適なコスト効率の高い仮想マシンインフラストラクチャを提供しています。TensorDockは、OSレベルの監視、自動スケーリング、ロードバランシング機能を備えた、完全マネージドなコンテナホスティングサービスも提供しています。さらに、TensorDockは専門家による世界クラスのエンタープライズサポートを提供しています。

開発とツール

53.8K

Llama 3 70B Gradient 524K アダプター

Llama-3 70B Gradient 524K アダプターは、Gradient AI Teamが開発したLlama-3 70Bモデルベースのアダプターです。LoRA技術を用いてモデルのコンテキスト長を524Kに拡張することで、長文データ処理におけるモデルのパフォーマンスを向上させます。このモデルは、NTK-aware補間とRingAttentionライブラリなどの高度なトレーニング技術を用いて、高性能計算クラスタ上で効率的にトレーニングされています。

AIモデル

47.7K

中国語精選

Abab 6.5

abab 6.5シリーズには、abab 6.5とabab 6.5sの2つのモデルが含まれています。どちらも最大20万トークンのコンテキスト長に対応しています。abab 6.5は数兆パラメーターを備え、abab 6.5sはより効率的で、約3万文字のテキストを1秒で処理できます。知識、推論、数学、プログラミング、指示遵守などの主要な能力テストにおいて、業界最先端レベルに近い性能を発揮しています。

AIモデル

137.4K

WSE 3

Cerebras Systemsは、業界最大級のAIモデルのトレーニング向けに設計された、第3世代5nmウェハー規模エンジン(WSE-3)を発表しました。WSE-3は、前世代製品であるWSE-2の2倍の性能を、消費電力と価格を維持したまま実現しています。このチップは5nmプロセスで製造され、4兆個のトランジスタを搭載しており、AI向けに最適化された90万個の計算コアにより、125ペタフロップスのピークAI性能を提供します。

モデルトレーニングとデプロイ

49.7K

Solidus AI Tech

Solidus AI Techは、AIaaS(人工知能即サービス)、BAAS(ブロックチェーン即サービス)、高性能計算能力(HPC)、そしてAIマーケットプレイスを提供する革新的なテクノロジー企業です。当社の基軸トークンであるAITECHは、これらの最先端技術のすべてを推進しています。当社のプラットフォームを通じて、ユーザーは最新のAI技術に容易にアクセスし、複雑な問題を解決し、効率性を向上させ、ビジネス目標の達成を実現できます。

開発プラットフォーム

50.5K

Stablecode

StableCodeは、Stable AIが発表したプログラミングに特化した初の生成AI製品です。3種類の異なるモデルを採用し、開発者のプログラミング効率向上を支援します。基礎モデルは、BigCodeのstack-dataset(v1.2)でトレーニングされた後、Python、Go、Java、Javascript、C、Markdown、C++などの一般的なプログラミング言語に特化したトレーニングがさらに実施されました。合計5600億個のコードトークンを、高性能計算クラスタ上でトレーニングしました。その後、約12万個のコード指示/応答ペアを用いて基礎モデルを微調整し、複雑なプログラミングタスクの解決を目指しました。StableCodeはプログラミング学習の理想的な基盤であり、長文コンテキストウィンドウモデルにより、ユーザーは単一行および複数行の自動補完提案を得ることができます。本モデルは従来のオープンソースモデルと比較して2~4倍多くのコードを一度に処理でき(コンテキストウィンドウは16,000トークン)、平均的なPythonファイル5個分に相当するコードを同時に閲覧?編集できるため、初心者にとって大きな課題にも対応できる理想的な学習ツールとなっています。

AIコード生成

48.0K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.2K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

38.9K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.1K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

38.9K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.1K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M