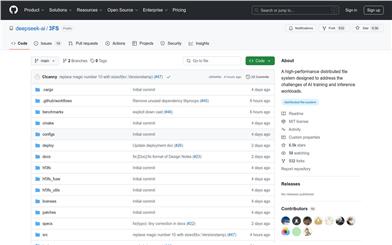

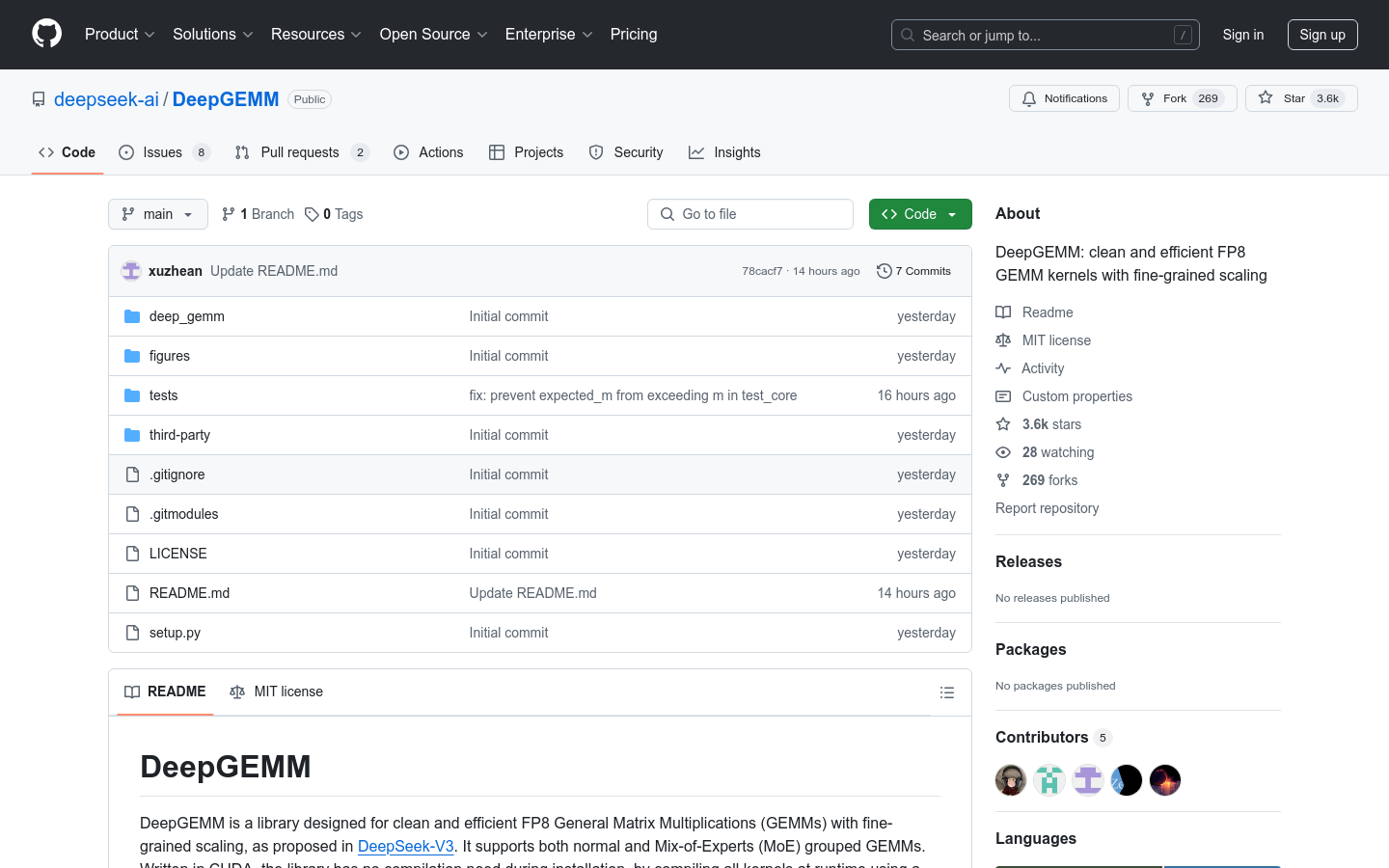

Deepgemm

紹介 :

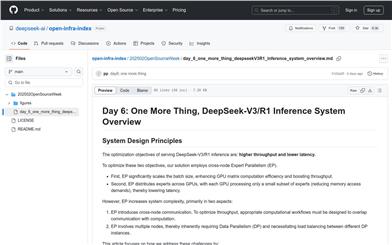

DeepGEMMは、効率的なFP8行列乗算に特化したCUDAライブラリです。Hopper TMA特性、永続スレッド特殊化、全JIT設計などの細粒度スケーリングと様々な最適化技術により、行列演算の性能を大幅に向上させます。このライブラリは主に深層学習と高性能計算の分野を対象としており、効率的な行列演算が必要な場面に適しています。NVIDIA HopperアーキテクチャのTensor Coreをサポートし、様々な行列形状で卓越した性能を発揮します。DeepGEMMは設計が簡潔で、コアコードは約300行と少なく、容易に学習?使用でき、同時に専門家が最適化したライブラリと同等かそれ以上の性能を発揮します。オープンソースかつ無料であるため、深層学習の最適化と開発を行う研究者や開発者にとって理想的な選択肢となります。

ターゲットユーザー :

本製品は、特にNVIDIA HopperアーキテクチャGPU上で効率的な行列演算が必要な、深層学習研究者や開発者を対象としています。大規模深層学習モデルの訓練や推論など、FP8行列乗算の性能最適化が必要な場面に適しています。オープンソースかつ無料で、容易に統合できるため、既存プロジェクトで行列演算の性能を迅速に向上させたい開発者にも最適です。

使用シナリオ

深層学習モデルの訓練過程で、DeepGEMMを使用してFP8形式の行列乗算演算を高速化し、訓練速度を大幅に向上させる。

推論段階で、DeepGEMMのグループGEMM機能を使用して、混合専門家モデル(MoE)の計算性能を最適化する。

開発者はDeepGEMMを既存の深層学習フレームワークに統合し、その最適化技術を利用してシステム全体の効率を向上させることができる。

製品特徴

深層学習におけるGEMM演算に適した、FP8形式の効率的な行列乗算をサポート

細粒度スケーリング技術を採用し、計算精度と性能を向上

HopperアーキテクチャのTMA特性を利用し、高速なデータ転送と最適化を実現

全JIT設計により、インストール時のコンパイルが不要で、実行時に動的にコンパイルと最適化を行う

通常のGEMMとグループGEMMを含む、様々な行列乗算シナリオをサポート

永続スレッド特殊化、FFMA命令最適化などの様々な最適化技術を提供

簡潔で使いやすいAPIにより、開発者は既存のプロジェクトに容易に統合可能

使用チュートリアル

1. DeepGEMMリポジトリをクローンし、サブモジュールを初期化します:`git clone --recursive https://github.com/deepseek-ai/DeepGEMM.git`

2. Python 3.8以降、CUDA 12.3以降、PyTorch 2.1以降などの依存関係をインストールします。

3. `python setup.py develop`を使用して開発モードでインストールします。

4. JITコンパイルとコア機能をテストします:`python tests/test_jit.py`と`python tests/test_core.py`

5. Pythonプロジェクトで`deep_gemm`モジュールをインポートし、提供されているGEMM関数を使用します。

おすすめAI製品

Pseudoeditor

PseudoEditorは無料で使用できるオンライン擬似コードエディタです。構文の強調表示や自動補完などの機能を備えており、擬似コードの作成を容易にします。さらに、内蔵の擬似コードコンパイラ機能でテストすることも可能です。ダウンロード不要ですぐにご利用いただけます。

開発とツール

3.8M

Coze

Cozeは、次世代AIチャットボット構築プラットフォームです。AIチャットボットアプリケーションの迅速な作成、デバッグ、最適化が可能です。コーディング不要で、チャットボットを簡単に作成し、様々なプラットフォームに公開できます。豊富なプラグインも提供しており、データとの連携、アイデアをボットスキルへの変換、長期記憶の装備、会話の開始など、ボットの機能を拡張できます。

開発とツール

3.7M