Deepscaler 1.5B Preview

简介 :

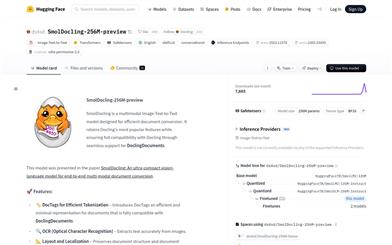

DeepScaleR-1.5B-Preview 是一个经过强化学习优化的大型语言模型,专注于提升数学问题解决能力。该模型通过分布式强化学习算法,显著提高了在长文本推理场景下的准确率。其主要优点包括高效的训练策略、显著的性能提升以及开源的灵活性。该模型由加州大学伯克利分校的 Sky Computing Lab 和 Berkeley AI Research 团队开发,旨在推动人工智能在教育领域的应用,尤其是在数学教育和竞赛数学领域。模型采用 MIT 开源许可,完全免费供研究人员和开发者使用。

需求人群 :

该模型主要面向教育领域的研究人员、开发者以及数学竞赛选手。研究人员可以利用其开源特性进行算法研究和改进;开发者可以将其集成到教育软件中,为学生提供智能辅导;数学竞赛选手可以使用该模型进行解题练习和思路启发。

使用场景

在数学竞赛辅导软件中集成该模型,为学生提供实时解题建议和思路。

研究人员利用该模型的开源代码,探索新的强化学习算法优化方法。

数学教师使用该模型生成练习题和解析,辅助课堂教学。

产品特色

使用分布式强化学习算法优化模型性能

支持长文本上下文(最长可达24K),提升复杂问题解决能力

基于大规模数学问题数据集进行训练,覆盖 AIME、AMC 等竞赛题目

提供高效的推理服务支持,兼容多种高性能推理系统

开源模型架构和训练方法,便于开发者二次开发和研究

使用教程

1. 访问 Hugging Face 网站并下载 DeepScaleR-1.5B-Preview 模型文件。

2. 安装支持的推理系统(如 vLLM 或 Hugging Face Text Generation Inference)。

3. 将模型加载到推理系统中,配置合适的参数(如上下文长度、采样策略等)。

4. 使用模型进行数学问题的推理和解答,通过 API 接口调用模型服务。

5. 根据实际需求对模型输出进行解析和处理,例如提取答案、生成解题步骤等。