Deepscaler 1.5B Preview

紹介 :

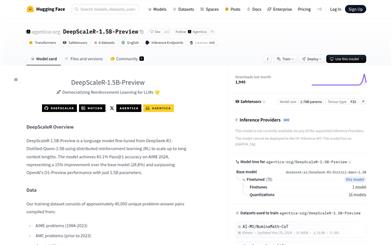

DeepScaleR-1.5B-Previewは、強化学習によって最適化された大規模言語モデルであり、数学問題解決能力の向上に特化しています。このモデルは分散型強化学習アルゴリズムを用いることで、長文推論における精度を大幅に向上させています。主な利点としては、効率的なトレーニング戦略、顕著な性能向上、そしてオープンソースによる柔軟性などが挙げられます。このモデルはカリフォルニア大学バークレー校のSky Computing LabとBerkeley AI Researchチームによって開発され、特に数学教育や競技数学の分野における人工知能の応用を推進することを目的としています。MITオープンソースライセンスを採用しており、研究者や開発者は無料で利用できます。

ターゲットユーザー :

このモデルは主に、教育分野の研究者、開発者、そして数学競技の参加者を対象としています。研究者はオープンソースの特性を利用してアルゴリズムの研究や改良を行うことができます。開発者は教育ソフトウェアに統合して、生徒にインテリジェントな指導を提供できます。数学競技の参加者は、このモデルを使用して問題解決の練習やアイデアのヒントを得ることができます。

使用シナリオ

数学競技指導ソフトウェアにこのモデルを統合し、生徒にリアルタイムで解法の提案やアイデアを提供する。

研究者がこのモデルのオープンソースコードを利用して、新しい強化学習アルゴリズムの最適化方法を探求する。

数学教師がこのモデルを使用して練習問題と解説を生成し、授業を補助する。

製品特徴

分散型強化学習アルゴリズムを使用してモデル性能を最適化

長文コンテキスト(最大24Kまで)をサポートし、複雑な問題解決能力を向上

大規模な数学問題データセットに基づいてトレーニングされており、AIME、AMCなどの競技問題を網羅

効率的な推論サービスをサポートし、様々な高性能推論システムと互換性あり

モデルアーキテクチャとトレーニング方法をオープンソース化し、開発者による二次開発と研究を容易に

使用チュートリアル

1. Hugging Faceのウェブサイトにアクセスし、DeepScaleR-1.5B-Previewモデルファイルをダウンロードします。

2. サポートされている推論システム(vLLMやHugging Face Text Generation Inferenceなど)をインストールします。

3. モデルを推論システムにロードし、適切なパラメータ(コンテキストの長さ、サンプリング戦略など)を設定します。

4. モデルを使用して数学問題の推論と解答を行い、APIインターフェースを介してモデルサービスを呼び出します。

5. 実際のニーズに合わせてモデルの出力を解析および処理します(例:回答の抽出、解法手順の生成など)。

おすすめAI製品

高品質新製品

Miraa

Miraaは、AIによる双方向字幕と学習支援機能を搭載したアプリです。ビデオや音声などのメディア資料を自動的に文字起こしし、対話型のAI解説とリアルタイム翻訳機能を提供することで、効率的な学習を支援します。主な特長は、字幕のシームレスな追従とユーザーのペースに合わせた繰り返し再生、AIによるインタラクティブな解説と質問対応、リアルタイム翻訳などです。Miraaは無料で利用できますが、付加価値のある有料サービスも提供しています。主に語学学習者や教育関係者を対象としています。

学習教育

1.4M

Maths.ai

Maths.aiは、AIを活用した最高のオンライン数学指導ツールです。あらゆる数学の疑問にすぐに解答を得られます。AIによるパーソナライズされた数学サポートを、すぐに利用できます。

学習教育

1.1M