MILS

简介 :

MILS是一个由Facebook Research发布的开源项目,旨在展示大型语言模型(LLMs)在未经过任何训练的情况下,能够处理视觉和听觉任务的能力。该技术通过利用预训练的模型和优化算法,实现了对图像、音频和视频的自动描述生成。这一技术突破为多模态人工智能的发展提供了新的思路,展示了LLMs在跨模态任务中的潜力。该模型主要面向研究人员和开发者,为他们提供了一个强大的工具来探索多模态应用。目前该项目是免费开源的,旨在推动学术研究和技术发展。

需求人群 :

该产品主要面向人工智能研究人员、开发者以及对多模态生成任务感兴趣的专业人士。它为研究人员提供了一个强大的工具来探索和开发新的多模态应用,同时也为开发者提供了可以直接使用的代码和模型,帮助他们快速实现相关功能。

使用场景

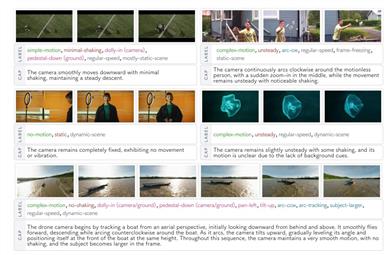

使用MILS为MS-COCO数据集中的图像生成描述

为Clotho数据集中的音频生成描述

为MSR-VTT数据集中的视频生成描述

产品特色

支持图像、音频和视频的自动描述生成

利用预训练模型优化跨模态任务性能

提供多种任务的示例代码,包括图像、音频和视频描述

支持多GPU并行处理,提升生成效率

提供详细的安装和使用指南,易于上手

使用教程

1. 安装所需的依赖环境,运行`conda env create -f environment.yml`并激活环境

2. 下载所需的图像、音频和视频数据集,并解压到指定目录

3. 更新`paths.py`文件中的路径,设置数据集和输出目录

4. 根据任务选择对应的脚本运行,例如运行图像描述生成脚本`main_image_captioning.py`

5. 使用评估脚本计算生成结果的性能指标,如BLEU、METEOR等

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M