Controlmm

简介 :

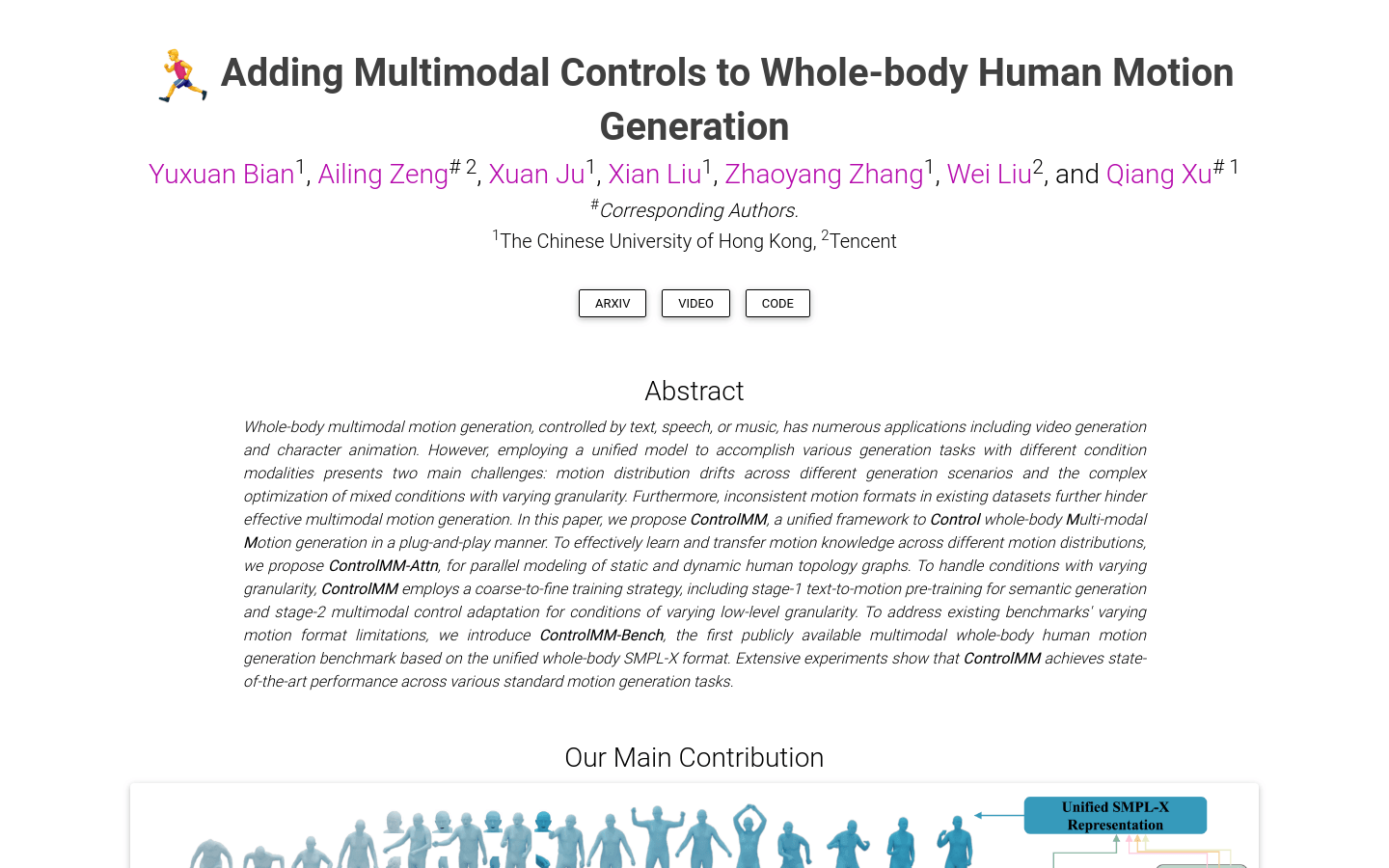

ControlMM是一个全身运动生成框架,具有即插即用的多模态控制功能,能够在文本到运动(Text-to-Motion)、语音到手势(Speech-to-Gesture)和音乐到舞蹈(Music-to-Dance)等多个领域中生成稳健的运动。该模型在可控性、序列性和运动合理性方面具有明显优势,为人工智能领域提供了一种新的运动生成解决方案。

需求人群 :

ControlMM的目标受众主要是人工智能领域的研究人员和开发者,尤其是那些专注于人机交互、动作识别和生成、以及虚拟现实等领域的专业人士。该技术可以用于提升机器人的动作生成能力,增强虚拟现实体验的真实感,或者辅助动画制作等。

使用场景

研究人员使用ControlMM生成与特定文本描述相符的全身运动,用于研究动作识别。

开发者利用ControlMM将语音指令转换为机器人的手势动作,提高人机交互的自然度。

动画制作人员使用ControlMM根据音乐节奏创作舞蹈动画,提高工作效率。

产品特色

文本到运动:根据文本描述生成相应的全身运动。

语音到手势:将语音内容转换为相应的手势动作。

音乐到舞蹈:根据音乐节奏生成舞蹈动作。

高可控性:模型能够生成高度可控的运动。

序列性:生成的运动序列符合逻辑和时间顺序。

运动合理性:生成的运动符合人体运动学原理,动作自然流畅。

使用教程

步骤1:访问ControlMM的网页链接。

步骤2:了解ControlMM的基本信息和技术特点。

步骤3:根据需求选择文本到运动、语音到手势或音乐到舞蹈中的一个功能。

步骤4:输入相应的文本、语音或音乐信息。

步骤5:ControlMM将根据输入生成对应的全身运动或手势动作。

步骤6:评估生成的运动或动作是否满足预期效果。

步骤7:根据需要调整输入参数,优化生成结果。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M

中文精选

剪映dreamina

剪映Dreamina是抖音旗下的AIGC工具,用户可以根据文本内容生成由AI生成的创意图,支持修整图片大小比例和模板类型。未来会用于抖音的图文或短视频的内容创作,丰富抖音在AI创造方面的内容库。

AI图像生成

9.1M