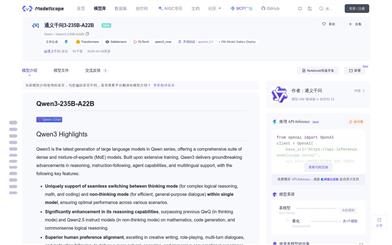

使用場景

研究人員使用該模型進行自然語言處理領域的研究,如文本分類和情感分析。

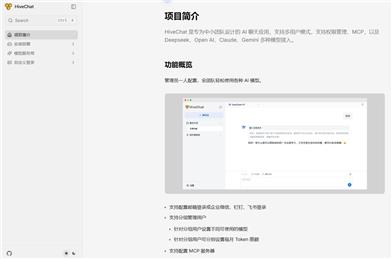

開發者利用模型的文本生成能力,開發聊天機器人和自動回覆系統。

教育機構使用該模型作為教學工具,幫助學生理解自然語言處理的工作原理。

產品特色

• 支持文本生成:能夠處理包括聊天在內的多種文本生成任務。

• 指令遵循:模型能夠理解和執行給定的指令。

• 多任務性能:在MATH、GSM8K和IFEval等多個基準測試中表現優異。

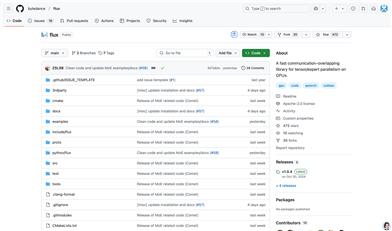

• 開源數據和代碼:提供了完全開源的數據和代碼,方便研究和教育使用。

• 後訓練技術:模型採用了現代的後訓練技術,如SFT(Supervised Fine-Tuning)和DPO(Differential Privacy Optimization)。

• 易於部署:可以通過Hugging Face平臺輕鬆加載和部署。

• 安全性和風險控制:模型雖然有有限的安全訓練,但能夠產生問題輸出,尤其是在被要求這樣做時。

使用教程

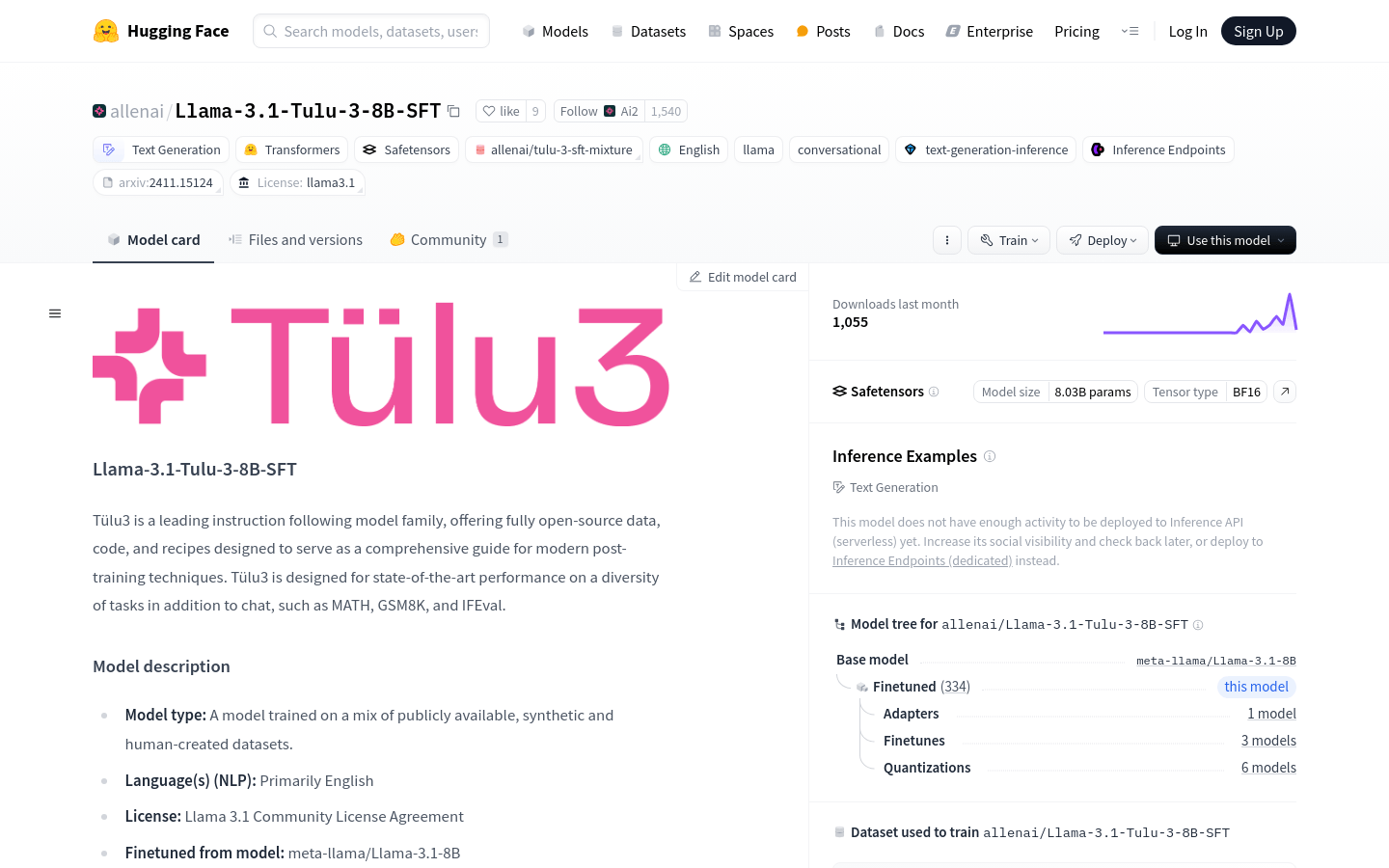

1. 訪問Hugging Face平臺並搜索Llama-3.1-Tulu-3-8B-SFT模型。

2. 使用提供的代碼片段加載模型:`from transformers import AutoModelForCausalLM; tulua_model = AutoModelForCausalLM.from_pretrained("allenai/Llama-3.1-Tulu-3-8B-SFT")`。

3. 根據需要調整模型參數,例如最大序列長度和學習率。

4. 使用模型進行文本生成或其他NLP任務。

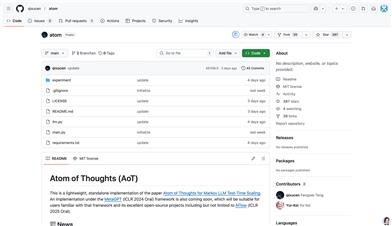

5. 參考模型的GitHub倉庫和論文,瞭解更多關於模型訓練和評估的細節。

6. 如果需要,可以通過Hugging Face的Inference Endpoints部署模型,以便在生產環境中使用。