使用场景

研究人员使用该模型进行自然语言处理领域的研究,如文本分类和情感分析。

开发者利用模型的文本生成能力,开发聊天机器人和自动回复系统。

教育机构使用该模型作为教学工具,帮助学生理解自然语言处理的工作原理。

产品特色

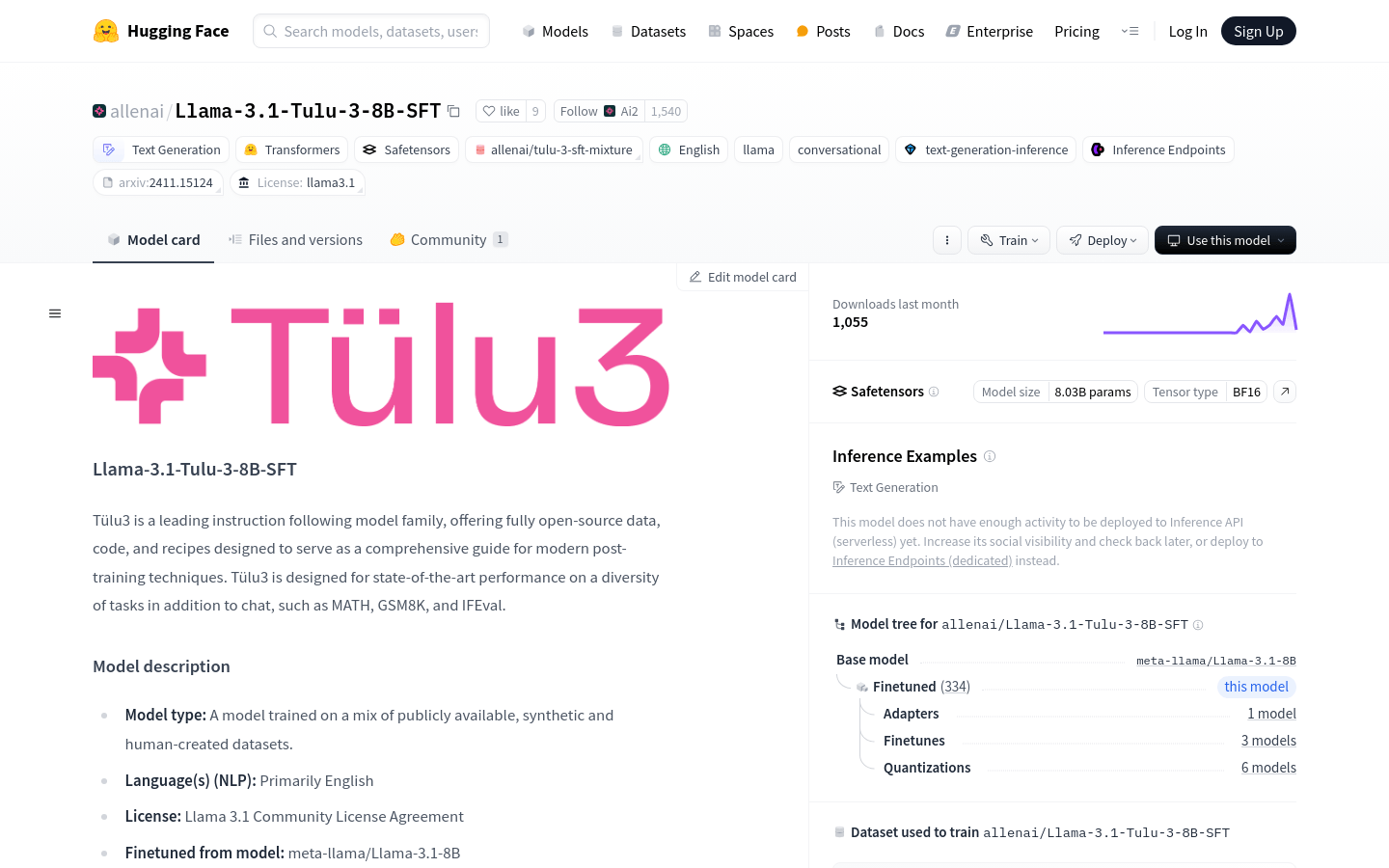

• 支持文本生成:能够处理包括聊天在内的多种文本生成任务。

• 指令遵循:模型能够理解和执行给定的指令。

• 多任务性能:在MATH、GSM8K和IFEval等多个基准测试中表现优异。

• 开源数据和代码:提供了完全开源的数据和代码,方便研究和教育使用。

• 后训练技术:模型采用了现代的后训练技术,如SFT(Supervised Fine-Tuning)和DPO(Differential Privacy Optimization)。

• 易于部署:可以通过Hugging Face平台轻松加载和部署。

• 安全性和风险控制:模型虽然有有限的安全训练,但能够产生问题输出,尤其是在被要求这样做时。

使用教程

1. 访问Hugging Face平台并搜索Llama-3.1-Tulu-3-8B-SFT模型。

2. 使用提供的代码片段加载模型:`from transformers import AutoModelForCausalLM; tulua_model = AutoModelForCausalLM.from_pretrained("allenai/Llama-3.1-Tulu-3-8B-SFT")`。

3. 根据需要调整模型参数,例如最大序列长度和学习率。

4. 使用模型进行文本生成或其他NLP任务。

5. 参考模型的GitHub仓库和论文,了解更多关于模型训练和评估的细节。

6. 如果需要,可以通过Hugging Face的Inference Endpoints部署模型,以便在生产环境中使用。