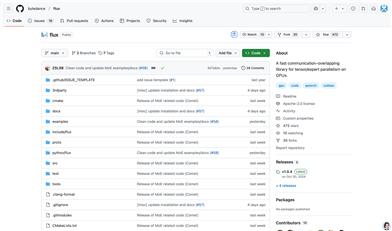

バイトダンス Flux

紹介 :

Fluxは、バイトダンスが開発した高性能通信オーバーラップライブラリで、GPU上のテンソルとエキスパート並列化のために設計されています。効率的なカーネルとPyTorchとの互換性により、さまざまな並列化戦略をサポートし、大規模モデルの訓練と推論に適しています。Fluxの主な利点には、高性能、容易な統合、およびさまざまなNVIDIA GPUアーキテクチャのサポートが含まれます。大規模分散型訓練、特にMixture-of-Experts(MoE)モデルにおいて優れたパフォーマンスを発揮し、計算効率を大幅に向上させることができます。

ターゲットユーザー :

Fluxは、GPU上で大規模モデルの訓練と推論を行う必要がある深層学習研究者やエンジニア、特にPyTorchフレームワークとMoEモデルを使用しているユーザーを対象としています。モデルの訓練効率と推論性能を向上させ、同時にハードウェア資源の使用コストを削減するのに役立ちます。

使用シナリオ

大規模MoEモデルにおいて、Fluxは通信オーバーヘッドを大幅に削減し、モデルの訓練速度を向上させることができます。

研究者はFluxの高効率カーネルを利用して、既存モデルの推論性能を最適化できます。

開発者はPyTorchプロジェクトにFluxを統合することで、分散型訓練の効率を向上させることができます。

製品特徴

Ampere、Ada Lovelace、Hopperなど、複数のGPUアーキテクチャをサポート

高性能な通信オーバーラップカーネルを提供し、計算効率を最適化

PyTorchと深く統合され、既存のフレームワークで簡単に使用可能

float16やfloat32など、複数のデータ型をサポート

詳細なインストールガイドと使用例を提供し、開発者が迅速に使い始めることを容易にする

使用チュートリアル

1. GitHubからFluxリポジトリをクローンし、依存関係をインストールします。

2. GPUアーキテクチャに合わせて適切なビルドオプションを選択し、build.shスクリプトを実行します。

3. インストール後、Fluxが提供するサンプルコードを使用して機能をテストします。

4. PyTorchプロジェクトにFluxを統合し、そのAPIを呼び出して通信オーバーラップを実現します。

5. 必要に応じてFluxの設定を調整し、モデルの訓練と推論のパフォーマンスを最適化します。

おすすめAI製品

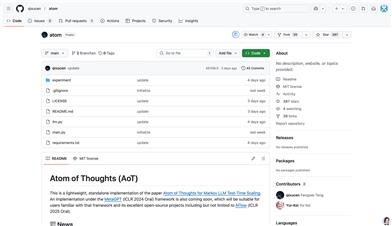

Aot

Atom of Thoughts (AoT)は、解法を原子問題の組み合わせとして表現することで、推論プロセスをマルコフ過程に変換する新しい推論フレームワークです。このフレームワークは、分解と縮小メカニズムを通じて、大規模言語モデルの推論タスクにおける性能を大幅に向上させると同時に、計算資源の無駄を削減します。AoTは、独立した推論方法としてだけでなく、既存のテスト時拡張方法のプラグインとしても使用でき、さまざまな方法の長所を柔軟に組み合わせることができます。このフレームワークはオープンソースで、Pythonで実装されており、研究者や開発者が自然言語処理と大規模言語モデルの分野で実験や応用を行うのに適しています。

モバイルショッピングとオンライン

46.9K

Factorio学習環境

Factorio Learning Environment(FLE)は、『Factorio』ゲームを基盤として構築された新しいフレームワークで、大規模言語モデル(LLMs)の長期的計画、プログラム合成、資源最適化能力を評価するために使用されます。LLMsが既存のベンチマークテストを飽和状態に近づけるにつれて、FLEは新たなオープンな評価方法を提供します。その重要性は、研究者がLLMsの長所と短所をより包括的かつ深く理解できる点にあります。主な利点として、複雑さが指数関数的に増加するオープンな課題を提供し、構造化されたタスクとオープンなタスクの2種類の評価プロトコルを備えている点が挙げられます。このプロジェクトはJack Hopkins氏らによって開発され、オープンソースとして公開されており、無料で使用できます。AI研究者が複雑でオープンな分野におけるエージェントの能力に関する研究を推進することを目的としています。

モバイルショッピングとオンライン

45.5K