GPT 4.1

GPT-4.1は、一連の新しいモデルであり、特にコーディング、指示遵守、長いテキストコンテキストの処理において、顕著な性能向上を提供します。コンテキストウィンドウは100万トークンに拡大され、現実世界のアプリケーションで優れたパフォーマンスを発揮し、開発者がより効率的なアプリケーションを作成するのに適しています。このモデルは比較的低価格で、高速な応答能力を備えているため、複雑なタスクの開発と実行をより効率的に行うことができます。

AIモデル

38.6K

混元T1

混元T1は、強化学習に基づく超大規模推論モデルであり、事後学習によって推論能力を大幅に向上させ、人間の好みと整合性をとっています。本モデルは長文の処理と複雑な推論タスクに特化しており、顕著な性能上の優位性を示しています。

人工知能

41.4K

AI21 Jamba Large 1.6

AI21-Jamba-Large-1.6は、AI21 Labsが開発した混合SSM-Transformerアーキテクチャの基礎モデルであり、長文処理と効率的な推論のために設計されています。このモデルは、長文処理、推論速度、品質において優れたパフォーマンスを発揮し、複数の言語をサポートし、強力な指示追従能力を備えています。金融分析、コンテンツ生成など、大量のテキストデータを処理する必要があるエンタープライズアプリケーションに適しています。このモデルはJamba Open Model Licenseのライセンスで提供され、ライセンス条項に従って研究および商用利用が許可されています。

モバイルショッピングとオンライン

45.0K

Qwq 32B

QwQ-32BはQwenシリーズの推論モデルであり、複雑な問題の思考と推論能力に特化しています。下流タスクにおいて優れたパフォーマンスを発揮し、特に難問解決においてその力を発揮します。このモデルはQwen2.5アーキテクチャをベースに、事前学習と強化学習による最適化が行われており、325億のパラメーターを持ち、最大131072トークンの完全なコンテキスト長を処理できます。主な利点としては、強力な推論能力、効率的な長文処理能力、柔軟な展開オプションなどが挙げられます。このモデルは、学術研究、プログラミング支援、創作執筆など、深い思考と複雑な推論を必要とする場面に適しています。

AIモデル

48.6K

高品質新製品

Gemini 2.0 Flash Lite

Gemini 2.0 Flash-Liteは、Googleが提供する高効率な言語モデルであり、長文処理と複雑なタスク向けに最適化されています。推論、マルチモーダル、数学、事実性のベンチマークテストで優れた結果を示しており、簡素化された価格戦略により、百万レベルのコンテキストウィンドウをより経済的に利用できます。Gemini 2.0 Flash-Liteは、Google AI StudioとVertex AIで全面的に公開されており、エンタープライズレベルの生産用途に適しています。

AIモデル

45.0K

Moba

MoBA(Mixture of Block Attention)は、長文コンテキストを扱う大規模言語モデル向けに設計された革新的なアテンション機構です。コンテキストを複数のブロックに分割し、各クエリトークンが最も関連性の高いブロックに注目することで、効率的な長シーケンス処理を実現します。MoBAの主な利点は、フルアテンションとスパースアテンションをシームレスに切り替えられることで、性能と計算効率の両立を可能にしている点です。文書解析やコード生成など、長文処理が必要なタスクに適用可能であり、計算コストの大幅な削減と、高いモデル性能の維持を両立します。MoBAのオープンソース実装は、研究者や開発者に強力なツールを提供し、長文処理分野における大規模言語モデルの応用を促進します。

モデルトレーニングとデプロイメント

46.9K

EXAONE 3.5

EXAONE 3.5は、LG AI Researchが発表した、優れた性能とコスト効率で知られる一連の人工知能モデルです。モデルのトレーニング効率、データクレンジング、長文理解、指示遵守能力において優れた性能を発揮します。EXAONE 3.5モデルの開発はLGのAI倫理原則に従って行われ、AI倫理影響評価を実施することで、責任ある使用方法を確保しています。これらのモデルの発表は、AI研究とエコシステムの発展を促進し、AIイノベーションの基盤を築くことを目的としています。

AIモデル

44.2K

Qwen2.5 Coder 0.5B Instruct GGUF

Qwen2.5-Coderは、コード生成、コード推論、コード修正に特化したQwen大規模言語モデルの最新シリーズです。強力なQwen2.5をベースに開発されたQwen2.5-Coder-32Bは、現在最先端のオープンソースコード言語モデルであり、そのコーディング能力はGPT-4oに匹敵します。コードエージェントなどの実際のアプリケーションにおいて、コーディング能力の向上だけでなく、数学や汎用能力の優位性も維持することで、より包括的な基盤を提供します。

コード推論

48.0K

中国語精選

Qwen2.5 Turbo

Qwen2.5-Turboは、アリババ開発チームが開発した、超長文を処理できる言語モデルです。Qwen2.5をベースに最適化されており、最大100万トークン(約100万単語相当、または約150万文字相当)のコンテキストをサポートします。100万トークンのPasskey Retrievalタスクにおいて100%の精度を達成し、RULER長文評価ベンチマークテストでは93.1点を獲得、GPT-4やGLM4-9B-1Mを凌駕しています。長文処理における優れた性能に加え、短文処理についても高いパフォーマンスを維持しており、100万トークンあたりの処理コストはわずか0.3元と、コストパフォーマンスにも優れています。

高性能

58.0K

Qwen2.5 Coder 3B Instruct GPTQ Int4

Qwen2.5-Coderは、コード生成、推論、修正のために設計されたQwen大規模言語モデルの最新シリーズです。Qwen2.5をベースに、ソースコード、テキストコードベース、合成データなどを含む5.5兆トークンまでトレーニングトークンを拡張しました。Qwen2.5-Coder-32Bは、現在オープンソースのコードLLMの中でトップクラスであり、そのコーディング能力はGPT-4oに匹敵します。このモデルは、GPTQ量子化された4ビット命令微調整済み3BパラメーターQwen2.5-Coderモデルで、因果言語モデル、事前トレーニングと事後トレーニング段階、transformersアーキテクチャなどの特徴があります。

コード推論

45.3K

Qwen2.5 Coder 32B Instruct GPTQ Int8

Qwen2.5-Coder-32B-Instruct-GPTQ-Int8は、Qwenシリーズのコード生成に特化した大規模言語モデルです。32億のパラメータを持ち、長文処理に対応しており、現在、オープンソースのコード生成分野で最先端のモデルの一つです。Qwen2.5をベースに更なるトレーニングと最適化が行われており、コード生成、推論、修正において顕著な性能向上を示すと同時に、数学や汎用的な能力も維持しています。GPTQ 8-bit量子化技術を採用することで、モデルサイズを削減し、実行効率を向上させています。

長文処理

47.2K

Qwen2.5 Coder 32B Instruct GPTQ Int4

Qwen2.5-Coder-32B-Instruct-GPTQ-Int4は、Qwen2.5をベースとした32億5千万パラメーターのコード生成大規模言語モデルであり、長文処理に対応し、最大128Kトークンをサポートします。コード生成、コード推論、コード修正において顕著な性能向上を実現しており、現在オープンソースのコード言語モデルの中でもトップクラスです。コーディング能力の強化に加え、数学や一般能力においても優れた性能を維持しています。

コード推論

44.4K

Qwen2.5 Coder 32B Instruct AWQ

Qwen2.5-Coderは、コード生成に最適化された一連の大規模言語モデルです。0.5億、1.5億、3億、7億、14億、32億パラメータの6つの主要なモデルサイズを網羅し、様々な開発者のニーズに対応します。Qwen2.5-Coderは、コード生成、コード推論、コード修正において顕著な性能向上を実現しています。強力なQwen2.5をベースに、ソースコード、テキストコード接地、合成データなどを含む5.5兆トークンでトレーニングされ、現在最先端のオープンソースコードLLMとなっています。そのコーディング能力はGPT-4oに匹敵します。さらに、Qwen2.5-Coderはより包括的な基盤を提供し、現実世界のコードエージェントなどのアプリケーションシナリオに適しています。

コード推論

46.6K

Qwen2.5 Coder 32B

Qwen2.5-Coder-32Bは、Qwen2.5をベースとしたコード生成モデルで、32億個のパラメータを持ちます。これは現在、オープンソースのコード言語モデルの中で最大規模のモデルの一つです。コード生成、コード推論、コード修正において顕著な改善が見られ、最大128Kトークンの長文処理に対応できるため、コードエージェントなどの実用的なアプリケーションシナリオに適しています。数学や一般的な能力も維持しており、長文処理にも対応するため、開発者にとって強力なコード開発支援ツールとなります。

コードアシスタント

45.5K

Mistral Small Instruct 2409

Mistral-Small-Instruct-2409は、Mistral AI Teamが開発した、220億パラメーターの指令微調整AIモデルです。複数の言語に対応し、最大128kのシーケンス長をサポートします。長文処理や複雑な指示の理解が必要な自然言語処理、機械学習などの分野に特に適しています。

AIモデル

46.9K

Reader LM

Reader-LMは、Jina AIが開発した小型言語モデルで、ウェブ上の生の、雑然としたHTMLコンテンツをクリーンなMarkdown形式に変換することを目的としています。これらのモデルは特に長文処理に最適化されており、多言語に対応し、最大256Kトークンのコンテキスト長を処理できます。Reader-LMモデルは、HTMLからMarkdownへの直接変換を行うことで、正規表現やヒューリスティックなルールへの依存を減らし、変換の正確性と効率性を向上させています。

AI文章翻訳音声

48.3K

高品質新製品

AI21 Jamba 1.5 Mini

AI21-Jamba-1.5-Miniは、AI21 Labsが開発した最新世代の混合SSM-Transformer命令追従基盤モデルです。このモデルは、卓越した長文処理能力、速度、および品質で市場において際立っており、同等の規模の主要モデルと比較して、推論速度は最大2.5倍向上しています。Jamba 1.5 MiniとJamba 1.5 Largeは、関数呼び出し、構造化出力(JSON)、基本的な生成など、ビジネスユースケースと機能向けに最適化されています。

AIモデル

45.3K

海外精選

Jamba 1.5 オープンモデルファミリー

Jamba 1.5 オープンモデルファミリーは、AI21社が発表した最新のAIモデルシリーズです。SSM-Transformerアーキテクチャに基づき、超長文処理能力、高速性、高品質を備えており、市場における同種製品の中で最高の性能を誇ります。これらのモデルはエンタープライズアプリケーション向けに設計されており、リソース効率、品質、速度、重要なタスク解決能力を考慮しています。

AIモデル

49.4K

Internlm XComposer2.5

InternLM-XComposer2.5は、70億パラメーターを備えた大規模言語モデルで、テキストと画像の理解と生成に特化しています。最大96Kトークンの長文コンテキストに対応し、複雑で広範囲な入出力が必要なタスクに最適です。

AIモデル

53.5K

Internlm2.5 7B Chat 1M

InternLM2.5-7B-Chat-1Mは、オープンソースの70億パラメーターの会話モデルです。卓越した推論能力を備え、特に数学的推論において同規模のモデルを凌駕しています。1Mトークンの超長文コンテキストウィンドウに対応しており、LongBenchなどの長文処理タスクにも対応可能です。さらに、強力なツール呼び出し機能を備え、数百ものウェブページから情報を収集して分析?推論を行うことができます。

AIモデル

49.7K

Internlm2.5 7B Chat

InternLM2.5-7B-Chatは、実用的なシナリオ向けに設計された、オープンソースの70億パラメーターの日本語対話型モデルです。優れた推論能力を備え、数学的推論においてLlama3やGemma2-9Bなどのモデルを凌駕しています。数百のウェブサイトから情報を収集し、分析?推論を行うことができ、強力なツール呼び出し機能を備えています。1Mを超える超長文コンテキストウィンドウに対応しており、長文処理や複雑なタスクのインテリジェントエージェント構築に適しています。

AI会話機械人間

52.4K

Qwen2

Qwen2は、事前学習と指示調整が施された一連のモデルであり、英語や中国語を含む最大27の言語をサポートしています。これらのモデルは複数のベンチマークテストで優れたパフォーマンスを示しており、特にコーディングと数学において顕著な向上が見られます。Qwen2モデルは最大128Kトークンのコンテキスト長に対応し、長文処理タスクに適しています。さらに、Qwen2-72B-Instructモデルは、安全性においてGPT-4と同等であり、Mistral-8x22Bモデルを大きく上回っています。

AIモデル

155.7K

高品質新製品

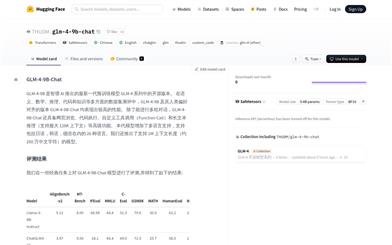

GLM 4 9B Chat 1M

GLM-4-9B-Chat-1Mは、智譜AIが発表した新世代の事前学習モデルであり、GLM-4シリーズのオープンソース版です。意味、数学、推論、コード、知識など、多様なデータセットの評価において高い性能を示しています。このモデルは複数回にわたる対話に対応するだけでなく、ウェブブラウジング、コード実行、カスタムツールの呼び出し、長文推論などの高度な機能も備えています。日本語、韓国語、ドイツ語を含む26言語に対応しており、特に1Mコンテキスト長のモデルバージョンも提供しています。大量のデータや多言語環境の処理が必要な開発者や研究者にとって最適です。

AIモデル

55.2K

高品質新製品

GLM 4 9B Chat

GLM-4-9B-Chatは、智譜AIが発表した次世代事前学習モデルGLM-4シリーズのオープンソース版です。多様な対話、ウェブ閲覧、コード実行、カスタムツール呼び出し、長文推論といった高度な機能を備えています。日本語、韓国語、ドイツ語を含む26言語に対応しており、1Mコンテキスト長のモデルも提供しています。

AIモデル

59.6K

Llama 3 70B Gradient 524K アダプター

Llama-3 70B Gradient 524K アダプターは、Gradient AI Teamが開発したLlama-3 70Bモデルベースのアダプターです。LoRA技術を用いてモデルのコンテキスト長を524Kに拡張することで、長文データ処理におけるモデルのパフォーマンスを向上させます。このモデルは、NTK-aware補間とRingAttentionライブラリなどの高度なトレーニング技術を用いて、高性能計算クラスタ上で効率的にトレーニングされています。

AIモデル

47.7K

Llama 3 70B Instruct Gradient 1048k

Llama-3 70B Instruct Gradient 1048kは、Gradient AIチームが開発した最先端の言語モデルです。コンテキストの長さを1048K以上に拡張することで、適切な調整を受けたSOTA(State of the Art)言語モデルが長文処理を学習できることを実証しました。このモデルは、NTK-aware補間とRingAttention技術、そしてEasyContext Blockwise RingAttentionライブラリを使用して、高性能計算クラスタ上で効率的にトレーニングされました。商業利用と研究用途の両方で幅広い応用可能性を秘めており、特に長文処理と生成が必要な場面で役立ちます。

AIモデル

55.2K

Unichat Llama3 Chinese

Unichat-llama3-Chineseは、中国联通AI Innovation Centerが発表した、Meta Llama 3モデルに基づく業界初の中国語指令微調整モデルです。中国語データを追加して訓練することで、高品質な中国語での質疑応答機能を実現しており、最大28Kのコンテキスト入力に対応しています。さらに、64Kに対応するバージョンもリリース予定です。モデルの微調整指令データは、人の手で選別されており、データの高品質が保証されています。また、700億パラメータの中国語微調整バージョンも順次リリース予定で、長文バージョンと中国語二次事前学習済みのバージョンが含まれます。

AI会話型ロボット

56.3K

Llama 3 8B Instruct 262k

Llama-3 8B Instruct 262kは、Gradient AIチームが開発したテキスト生成モデルです。LLama-3 8Bのコンテキスト長を160K以上に拡張し、最先端(SOTA)の大規模言語モデルが長文処理を学習する潜在能力を示しています。RoPE thetaパラメータの適切な調整、NTK-aware補間とデータ駆動型最適化技術の組み合わせにより、長文での効率的な学習を実現しています。さらに、EasyContext Blockwise RingAttentionライブラリを基盤として構築されており、高性能ハードウェア上での拡張性と効率的なトレーニングをサポートします。

AIモデル

56.3K

中国語精選

Moonshot AI オープンプラットフォーム

Kimi chat を支えるMoonshot AIモデルのAPI申請を正式に開始いたしました。OpenAI APIとの互換性があり、最大128Kのコンテキスト長に対応しています。価格は0.06元、新規ユーザー様には15元分のトークンをプレゼントいたします。スムーズな移行が可能です。

チャットボット

508.4K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.2K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

38.9K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.1K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

38.9K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.1K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M