Upstage AI

Upstage AIは強力な大規模言語モデルとドキュメント処理エージェントを利用して、企業のワークフローを変革し、効率を向上させます。主な利点には高精度、高性能、そして各業界向けのカスタマイズ可能なソリューションが含まれます。リーディング企業に対する支援を目的としています。

ドキュメント処理

37.5K

Zerosearch

ZeroSearch は、実際の検索エンジンとの相互作用なしに、大規模な言語モデル(LLMs)の検索能力を促進する新しいタイプの強化学習フレームワークです。教師あり微調整を通じて、ZeroSearch は LLM を関連する無関係なドキュメントを生成できる検索モジュールに変換します。また、モデルの推論能力を段階的に促進するコースウェアメカニズムを導入しています。この技術の主な利点は、実際の検索エンジンに基づくモデルよりもパフォーマンスが高いことに加え、API 成本が発生しないことです。さまざまな規模の LLM に対応しており、異なる強化学習アルゴリズムをサポートしています。これは、効率的な検索能力を持つ必要のある研究や開発チームに最適です。

検索能力

37.5K

Notellm

NoteLLM はユーザ生成コンテンツに特化した検索可能な大規模言語モデルであり、推薦システムのパフォーマンスを向上させることを目指しています。テーマ生成と埋め込み生成の組み合わせにより、ノートの内容に対する理解と処理力を向上させています。このモデルはエンドツーエンドのチューニング戦略を採用しており、マルチモーダル入力に対応し、多様なコンテンツ領域での応用可能性を広げています。その重要なポイントは、ノート推薦の精度と体験を効果的に向上させることで、特に小紅書などのUGCプラットフォームに最適です。

マルチモーダル処理

38.1K

Weclone

WeCloneは、微信のチャットログで微調整された大規模言語モデルに基づくプロジェクトで、主に高品質の音声クローンとデジタル分身の実現を目的としています。微信の音声メッセージと0.5Bの大規模モデルを組み合わせることで、ユーザーはチャットボットを通じて自身のデジタル分身とインタラクトできます。この技術はデジタル不滅と音声クローン分野で重要な応用価値を持ち、ユーザーは不在時でも他者と継続的にコミュニケーションを取ることができます。このプロジェクトは急速に進化しており、AIと言語モデルに興味のあるユーザーに適しており、現在は無料の開発段階です。

["野菜と様々なプランツ],["チェイブッツ]

37.5K

Dream 7B

Dream 7Bは、香港大学NLPグループとファーウェイ?ノアの方舟研究所が共同で発表した最新の拡散型大規模言語モデルです。テキスト生成分野において優れた性能を示しており、特に複雑な推論、長期計画、文脈の一貫性などに優れています。本モデルは高度なトレーニング方法を採用しており、強力な計画能力と柔軟な推論能力を備え、様々なAIアプリケーションにより強力なサポートを提供します。

AIモデル

37.5K

中国語精選

Argo

Xark-Argoは、ユーザーが独自の大規模言語モデルを簡単に構築?利用できるように設計されたデスクトップクライアント製品です。MacOSとWindowsに対応した複数のオペレーティングシステムをサポートし、強力なローカルモデル展開機能を提供します。ollamaテクノロジーを統合することで、ユーザーはオープンソースモデルをワンクリックでダウンロードでき、ChatGPT、Claude、Siliconflowなどの大規模モデルAPIにも対応しており、利用ハードルを大幅に低減します。この製品は、テキストや知識管理を効率的に処理する必要がある個人および企業ユーザーに適しており、高い柔軟性と拡張性を備えています。現時点では明確な価格情報は公開されていませんが、その機能から、中高端ユーザー層をターゲットとしている可能性があります。

デバイスとアクセサリー

47.2K

Notagen

NotaGen は、事前学習、ファインチューニング、強化学習の3段階を経て音楽生成の品質を向上させる革新的な記号音楽生成モデルです。大規模言語モデル技術を利用して、高品質のクラシック音楽楽譜を生成し、音楽創作に新たな可能性をもたらします。このモデルの主な利点には、効率的な生成、多様なスタイル、高品質の出力などが含まれます。音楽創作、教育、研究などの分野に適用でき、幅広い応用が期待できます。

コンピューター

54.4K

Aot

Atom of Thoughts (AoT)は、解法を原子問題の組み合わせとして表現することで、推論プロセスをマルコフ過程に変換する新しい推論フレームワークです。このフレームワークは、分解と縮小メカニズムを通じて、大規模言語モデルの推論タスクにおける性能を大幅に向上させると同時に、計算資源の無駄を削減します。AoTは、独立した推論方法としてだけでなく、既存のテスト時拡張方法のプラグインとしても使用でき、さまざまな方法の長所を柔軟に組み合わせることができます。このフレームワークはオープンソースで、Pythonで実装されており、研究者や開発者が自然言語処理と大規模言語モデルの分野で実験や応用を行うのに適しています。

モバイルショッピングとオンライン

46.6K

語析yuxi Know

語析Yuxi-Knowは、大規模言語モデルRAGナレッジベースに基づく知識グラフQ&Aシステムであり、Llamaindex + VueJS + Flask + Neo4jを使用して構築されています。OpenAI、国内の主要な大規模言語モデルプラットフォームのモデル呼び出し、およびローカルvllm展開をサポートしており、ナレッジベースQ&A、知識グラフ検索、インターネット検索などの機能を実現します。このシステムの主な利点は、さまざまなモデルへの柔軟な適応性、複数のナレッジベース形式のサポート、そして強力な知識グラフ統合機能です。効率的な知識管理とインテリジェントなQ&Aを必要とする企業や研究機関に適しており、高い技術的先進性と実用性を備えています。

知識管理

45.3K

Spark TTS

Spark-TTSは大規模言語モデルに基づいた、効率的なテキスト音声変換モデルであり、シングルストリームデカップリング音声トークンの特徴を持っています。大規模言語モデルの強力な能力を活用して、コードから予測された音声データを直接再構築し、追加の音響特徴量生成モデルを省略することで、効率性を向上させ、複雑さを軽減しています。このモデルはゼロショットテキスト音声変換をサポートし、複数言語やコードの切り替えシナリオに対応できるため、高い自然さと正確性を必要とする音声合成アプリケーションに最適です。また、仮想音声の作成にも対応しており、ユーザーは性別、ピッチ、速度などのパラメーターを調整することで、さまざまな音声を作成できます。このモデルの背景には、従来の音声合成システムにおける非効率性と複雑性の問題解決があり、研究と生産に効率的で柔軟かつ強力なソリューションを提供することを目指しています。現在、このモデルは主に学術研究や合法的なアプリケーション、例えばパーソナライズされた音声合成、支援技術、言語研究などに焦点を当てています。

テキスト読み上げ音声

43.6K

Level Navi Agent Search

Level-Navi Agentは、複雑な問題を分解し、インターネット上の情報を段階的に検索してユーザーの質問に答えることができる、オープンソースの汎用ウェブ検索エージェントフレームワークです。金融、ゲーム、スポーツ、映画、イベントなど5つの分野を網羅するWeb24データセットを提供することで、検索タスクにおけるモデルのパフォーマンス評価の基準を提供します。このフレームワークはゼロショット学習と少ショット学習をサポートし、大規模言語モデルの中国語ウェブ検索エージェント分野における応用にとって重要な参考資料となります。

AI検索

43.1K

M2RAG

M2RAGは、マルチモーダルコンテキストにおける検索強化生成のためのベンチマークテストコードリポジトリです。マルチモーダル検索ドキュメントを使用して質問に答え、マルチモーダル大規模言語モデル(MLLMs)がマルチモーダルコンテキストの知識を活用する能力を評価します。このモデルは、画像記述、マルチモーダル質問応答、ファクト検証、画像の再配置などのタスクで評価され、マルチモーダルコンテキスト学習におけるモデルの有効性を向上させることを目的としています。M2RAGは、研究者にとって標準化されたテストプラットフォームを提供し、マルチモーダル言語モデルの発展を促進するのに役立ちます。

AIモデル

44.2K

SWE RL

SWE-RLは、Facebook Researchが提案した、強化学習に基づく大規模言語モデルの推論技術です。オープンソースソフトウェアの進化データを利用して、ソフトウェアエンジニアリングタスクにおけるモデルのパフォーマンスを向上させることを目的としています。ルール駆動型の報酬メカニズムにより、モデルの推論能力を最適化し、より高品質なコードの理解と生成を可能にします。SWE-RLの主な利点は、革新的な強化学習手法とオープンソースデータの有効活用であり、ソフトウェアエンジニアリング分野に新たな可能性をもたらします。本技術は現在研究段階にあり、商業的な価格設定はまだ明確ではありませんが、開発効率とコード品質の向上に大きな可能性を秘めています。

コードアシスタント

43.6K

Tablegpt2 7B

TableGPT2-7Bは浙江大学が開発した大規模デコーダーモデルで、データ集約型タスク、特に表データの解釈と分析に特化しています。Qwen2.5アーキテクチャをベースとし、継続的プリトレーニング(CPT)と教師ありファインチューニング(SFT)によって最適化されており、複雑な表クエリやビジネスインテリジェンス(BI)アプリケーションに対応できます。日本語クエリに対応しており、構造化データを効率的に処理する必要がある企業や研究機関に適しています。現在、無料でオープンソースとして公開されていますが、将来的にはより専門的なバージョンが提供される可能性があります。

データ分析

45.3K

Coding Tutor

Coding-Tutorは、大規模言語モデル(LLM)に基づいたプログラミング指導ツールです。対話型インタラクションを通じて学習者のプログラミング能力向上を目指しています。知識追跡と逐次検証を組み合わせたTrace-and-Verify(Traver)ワークフローにより、プログラミング指導における重要な課題を解決します。このツールはプログラミング教育だけでなく、他のタスク指導の場面にも拡張でき、学習者の知識レベルに合わせて教育内容を調整できます。オープンソースであり、コミュニティによる貢献を歓迎します。

学習教育

45.3K

中国語精選

百宝箱tbox

Tboxはアリペイの生活シーンに基づいた大規模言語モデル技術製品です。企業が専門的なインテリジェントエージェントを迅速に構築し、ビジネスの成長を促進することを目的としています。アリババの百霊大規模言語モデル、蟻天鑑、Lingjingデジタルヒューマンなどの先進技術を統合し、体験の向上、インテリジェントな意思決定などの機能を実現します。Tboxは、民生、行政、交通、観光地、医療など、様々な業界に適用でき、インテリジェントなサービスを通じてユーザーエクスペリエンスと業務効率を向上させます。価格と具体的な位置付けは企業のニーズによって異なり、企業にカスタマイズされたソリューションを提供します。

スマートボディ

67.1K

Moba

MoBA(Mixture of Block Attention)は、長文コンテキストを扱う大規模言語モデル向けに設計された革新的なアテンション機構です。コンテキストを複数のブロックに分割し、各クエリトークンが最も関連性の高いブロックに注目することで、効率的な長シーケンス処理を実現します。MoBAの主な利点は、フルアテンションとスパースアテンションをシームレスに切り替えられることで、性能と計算効率の両立を可能にしている点です。文書解析やコード生成など、長文処理が必要なタスクに適用可能であり、計算コストの大幅な削減と、高いモデル性能の維持を両立します。MoBAのオープンソース実装は、研究者や開発者に強力なツールを提供し、長文処理分野における大規模言語モデルの応用を促進します。

モデルトレーニングとデプロイメント

46.9K

Goedel Prover

Goedel-Proverは、自動定理証明に特化したオープンソースの大規模言語モデルです。自然言語の数学問題を形式言語(Lean 4など)に変換し、形式化された証明を生成することで、数学問題の自動証明効率を大幅に向上させます。miniF2Fベンチマークテストでは57.6%の成功率を達成し、他のオープンソースモデルを凌駕しています。主な利点としては、高性能、オープンソースによる拡張性、および数学問題に対する深い理解力などが挙げられます。Goedel-Proverは、自動定理証明技術の発展を促進し、数学研究や教育に強力なツールを提供することを目指しています。

研究機器

49.1K

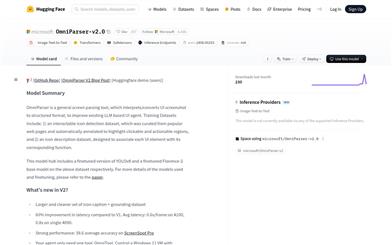

Omniparser V2.0

OmniParserは、Microsoftが開発した高度な画像解析技術です。不規則なスクリーンショットを、インタラクティブ領域の位置やアイコンの機能説明を含む構造化された要素リストに変換することを目的としています。YOLOv8やFlorence-2などの深層学習モデルを用いて、UIインターフェースを効率的に解析します。主な利点は、その効率性、正確性、そして幅広い適用性です。OmniParserは、大規模言語モデル(LLM)ベースのUIエージェントのパフォーマンスを大幅に向上させ、様々なユーザーインターフェースの理解と操作を可能にします。自動テスト、インテリジェントアシスタント開発など、幅広いアプリケーションシナリオで優れたパフォーマンスを発揮します。オープンソースの特性と柔軟なライセンスにより、開発者や研究者にとって強力なツールとなっています。

AI設計ツール

76.2K

中国語精選

DMXAPI

DMXAPIは、LangChain日本語版が提供する大規模言語モデルAPI統合サービスです。開発者が世界をリードする大規模言語モデルに迅速にアクセスできるようにすることを目指しています。集中調達とモデルメーカーとの直接連携により、DMXAPIはより競争力のある価格と効率的なサービスを提供します。GPT-4、Claude、LLaMAなど、自然言語処理、画像認識、生成AIなど、多様な用途に対応するモデルをサポートしています。DMXAPIの主な利点は、安全、低価格、高効率であり、7×24時間体制のオンラインカスタマーサポートを提供することで、ユーザーが安心して利用できるようにしています。

APIサービス

61.5K

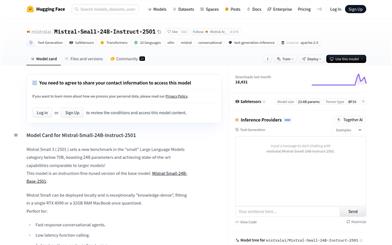

Mistral Small 24B Instruct 2501

Mistral Small 24Bは、Mistral AIチームが開発した240億パラメータの大規模言語モデルです。多言語対応の対話と命令処理をサポートしています。命令微調整により高品質のテキスト生成が可能で、チャット、ライティング、プログラミング支援など、様々な用途に適しています。主な利点としては、強力な言語生成能力、多言語サポート、効率的な推論能力が挙げられます。高性能な言語処理を必要とする個人や企業ユーザーに最適で、オープンソースライセンスであり、ローカル展開や量子化最適化にも対応しているため、データプライバシーを重視する場面にも適しています。

会話型AI

47.2K

高品質新製品

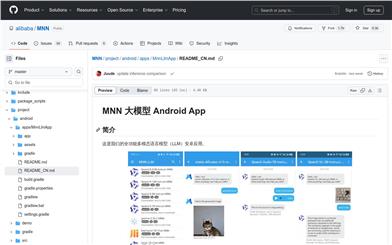

MNN大規模言語モデル Androidアプリ

MNN大規模言語モデルAndroidアプリは、アリババが開発した大規模言語モデル(LLM)ベースのAndroidアプリです。テキスト生成、画像認識、音声文字起こしなど、多様なモダリティの入出力に対応しています。推論性能を最適化することで、モバイルデバイス上での効率的な動作を確保し、ユーザーデータのプライバシーも保護します。すべての処理はローカルで行われます。Qwen、Gemma、Llamaなど、複数の主要なモデルプロバイダーをサポートしており、幅広い用途に対応可能です。

AIモデル

149.6K

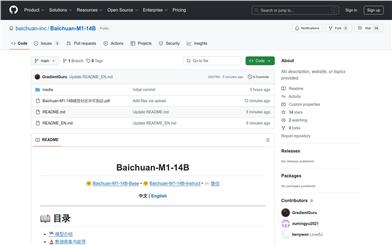

Baichuan M1 14B

Baichuan-M1-14Bは、百川智能が開発したオープンソースの大規模言語モデルで、医療現場向けに最適化されています。20兆トークンの高品質な医療データと汎用データを用いて訓練されており、20以上の医療科をカバーし、強力なコンテキスト理解能力と長シーケンスタスクでの優れた性能を備えています。医療分野において優れた成果を上げており、一般的なタスクでも同規模のモデルと同等の性能を発揮します。革新的なモデル構造とトレーニング方法により、医療推論、疾患判定などの複雑なタスクで優れた成果を上げており、医療分野におけるAIアプリケーションを強力に支援します。

医療

56.9K

中国語精選

Doubao 1.5 Pro

Doubao-1.5-proは、豆包チームが開発した高性能なスパースMoE(Mixture of Experts)大規模言語モデルです。本モデルは、訓練と推論の一体化設計により、モデル性能と推論性能の究極的なバランスを実現しています。複数の公開評価基準で優れた性能を示しており、特に推論効率とマルチモーダル能力において顕著な優位性を有しています。自然言語処理、画像認識、音声対話など、効率的な推論とマルチモーダルインタラクションを必要とするシナリオに適しています。その技術的背景は、スパース活性化MoEアーキテクチャに基づいており、活性化パラメータの比率と訓練アルゴリズムを最適化することで、従来の密なモデルよりも高い性能レバレッジを実現しています。さらに、本モデルは、異なるアプリケーションシナリオやコスト要件に合わせてパラメータを動的に調整することもできます。

AIモデル

94.1K

Deepseek R1 Distill Llama 70B

DeepSeek-R1-Distill-Llama-70Bは、DeepSeekチームが開発した大規模言語モデルで、Llama-70Bアーキテクチャをベースに強化学習によって最適化されています。このモデルは、推論、対話、多言語タスクにおいて優れた性能を発揮し、コード生成、数学的推論、自然言語処理など、多様なアプリケーションシナリオに対応しています。主な利点として、効率的な推論能力と複雑な問題解決能力があり、オープンソースと商用利用の両方をサポートしています。高性能な言語生成と推論能力が必要な企業や研究機関に適しています。

AIモデル

75.6K

Pasa

PaSaは、バイトダンスが開発した高度な学術論文検索エージェントです。大規模言語モデル(LLM)技術に基づいており、検索ツールを自律的に呼び出し、論文を読み、関連参考文献を絞り込むことで、複雑な学術的な検索クエリに対して包括的で正確な結果を取得します。この技術は強化学習によって最適化され、合成データセットAutoScholarQueryを用いて訓練されており、実世界のクエリデータセットRealScholarQueryにおいて優れた性能を示し、従来の検索エンジンやGPTベースの方法を大幅に上回っています。PaSaの主な利点は、高い再現率と精度であり、研究者に効率的な学術検索体験を提供します。

AI検索

59.6K

Internvl2 5 78B MPO

InternVL2.5-MPOは、InternVL2.5と混合選好最適化(MPO)に基づくマルチモーダル大規模言語モデルシリーズです。これは、新しく増分事前学習されたInternViTと、InternLM 2.5やQwen 2.5などの様々な事前学習済み大規模言語モデル(LLM)を、ランダムに初期化されたMLPプロジェクターを使用して統合することで、マルチモーダルタスクにおいて優れた性能を発揮します。このモデルシリーズは約300万サンプルを含むマルチモーダル推論選好データセットMMPRでトレーニングされており、効率的なデータ構築プロセスと混合選好最適化技術により、モデルの推論能力と回答品質が向上しています。

AIモデル

48.9K

自己適応型LLM

SakanaAI/self-adaptive-llmsは、Transformer2と呼ばれる適応型フレームワークであり、従来のファインチューニング手法の計算集約性と、多様なタスクへの対応能力の静的さを解決することを目指しています。このフレームワークは、推論過程において、2段階のメカニズムによって大規模言語モデル(LLM)をリアルタイムに調整し、未経験のタスクに適応します。まず、タスク属性をスケジューリングシステムが識別し、次に、強化学習で訓練されたタスク固有の「エキスパート」ベクトルを動的に混合することで、入力プロンプトに対する目標とする動作を得ます。主な利点としては、リアルタイムでのタスク適応性、計算効率、柔軟性などが挙げられます。このプロジェクトはSakanaAIチームによって開発され、現在GitHubでオープンソースとして公開されており、195個のスターと12回のフォークを獲得しています。

AIモデル

45.5K

Internlm3 8B Instruct

InternLM3-8B-Instructは、InternLMチームによって開発された大規模言語モデルであり、卓越した推論能力と知識集約型タスク処理能力を備えています。わずか4兆の高品質トークンを用いたトレーニングで、同レベルのモデルと比較して75%以上のトレーニングコスト削減を実現し、複数のベンチマークテストにおいてLlama3.1-8BやQwen2.5-7Bなどのモデルを凌駕しています。深層思考モードをサポートし、長い思考連鎖を通じて複雑な推論タスクを解決できると共に、流暢なユーザーインタラクション能力も備えています。Apache-2.0ライセンスの下でオープンソース化されており、効率的な推論と知識処理を必要とする様々なアプリケーションシナリオに適しています。

AIモデル

43.9K

Minmo

MinMoは、阿里巴巴グループの通義实验室が開発した、約80億パラメータを持つマルチモーダル大規模言語モデルです。シームレスな音声インタラクションの実現に特化しており、音声テキストアライメント、テキスト音声アライメント、音声音声アライメント、全二重インタラクションアライメントを含む複数段階のトレーニングを経て、140万時間におよぶ多様な音声データと幅広い音声タスクでトレーニングされています。MinMoは音声理解と生成における様々なベンチマークテストで最先端の性能を達成しており、同時にテキストの大規模言語モデルの能力も維持し、全二重対話(ユーザーとシステム間の同時双方向通信)をサポートしています。さらに、MinMoは、音声生成において従来のモデルを凌駕する、新規かつシンプルな音声デコーダを提案しています。MinMoの指示遵守能力は強化されており、ユーザーの指示に従って、感情、方言、話速などの詳細を含む音声生成を制御し、特定の音声を模倣することができます。MinMoの音声テキスト変換の遅延は約100ミリ秒、全二重遅延は理論上約600ミリ秒、実際は約800ミリ秒です。MinMoの開発は、従来のマルチモーダルモデルのアライメントにおける主な制約を克服し、ユーザーにより自然でスムーズ、人間味のある音声インタラクション体験を提供することを目的としています。

言語識別

47.5K

- 1

- 2

- 3

- 4

- 5

- 6

- 10

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.2K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

38.6K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

37.5K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

37.8K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

38.4K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

37.8K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M