Camerabench

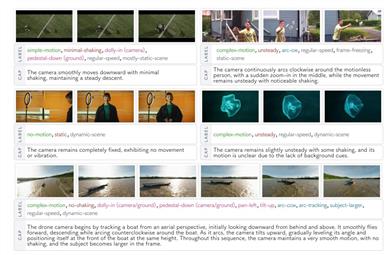

CameraBenchは、ビデオ内のカメラの動きを分析するモデルであり、ビデオの解釈を通じてカメラの動きパターンを理解することを目指しています。その主な強みは、生成型の視覚言語モデルを使用してカメラの動きパターンを分類し、ビデオ-テキスト検索を行うことです。従来の方法である構造化運動(SfM)や同時位置姿勢推定(SLAM)と比較し、このモデルはシーンのセマンティックをよりよく捉えています。モデルはオープンソースであり、研究者や開発者向けに適しており、後日、さらなる改良版がリリースされます。

研究ツール

38.1K

Hidream I1

HiDream-I1 は、170億個のパラメーターを持つ新しいオープンソースの画像生成基礎モデルです。数秒で高品質な画像を生成できます。研究開発に適しており、複数の評価で優れた性能を示しており、効率性と柔軟性を備えているため、様々なクリエイティブデザインや生成タスクに適しています。

AIモデル

38.4K

Together Chat

Together Chatは安全なAIチャットプラットフォームであり、毎日100件の無料メッセージを提供します。秘密の会話と高品質のインタラクションを必要とするユーザーに最適です。サーバーの所在地は北アメリカであり、ユーザー情報の安全性を確保しています。

チャットボット

43.3K

Wan 2.1 AI

Wan 2.1 AIは、アリババが開発したオープンソースの大規模動画生成AIモデルです。テキストから動画(T2V)と画像から動画(I2V)の生成をサポートし、シンプルな入力を高品質な動画コンテンツに変換できます。このモデルは動画生成分野において重要な意味を持ち、動画制作プロセスを大幅に簡素化し、制作のハードルを下げ、制作効率を向上させ、ユーザーに多様な動画制作の可能性を提供します。主な利点としては、高品質な動画生成効果、複雑な動作の滑らかな表現、リアルな物理シミュレーション、豊富なアートスタイルなどがあります。現在、この製品は完全にオープンソース化されており、ユーザーは基本機能を無料で利用できます。動画制作のニーズがありながら、専門的なスキルや設備がない個人や企業にとって、非常に高い実用価値があります。

["ビデオ アップデート, AI モデル]

52.4K

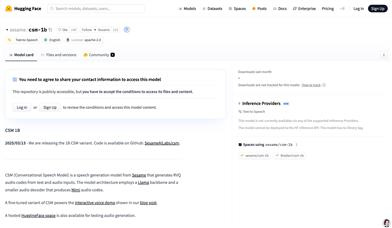

CSM 1B

CSM 1BはLlamaアーキテクチャに基づいた音声生成モデルであり、テキストとオーディオ入力からRVQオーディオコードを生成できます。このモデルは主に音声合成分野で使用され、高品質の音声生成能力を備えています。その利点は、複数話者の会話シーンを処理し、コンテキスト情報を使用して自然で滑らかな音声を生成できることです。このモデルはオープンソースであり、研究と教育目的での使用を支援することを目的としていますが、なりすまし、詐欺、または違法行為に使用することを明確に禁止しています。

ファッションモデル

55.2K

Gemma 3

Gemma 3は、Googleが発表した最新のオープンソースモデルであり、Gemini 2.0の研究と技術開発に基づいています。軽量で高性能なモデルであり、単一のGPUまたはTPU上で動作し、開発者に強力なAI機能を提供します。Gemma 3は、複数のサイズ(1B、4B、12B、27B)を提供し、140以上の言語をサポートし、高度なテキストとビジュアル推論機能を備えています。主な利点としては、高性能、低計算需要、幅広い多言語サポートがあり、さまざまなデバイスでAIアプリケーションを迅速に展開するのに適しています。Gemma 3の発表は、AI技術の普及と革新を促進し、開発者がさまざまなハードウェアプラットフォームで効率的な開発を実現することを目的としています。

AIモデル

61.5K

Hunyuanvideo I2V

HunyuanVideo-I2Vは、テンセントがオープンソース化した画像から動画を生成するモデルであり、HunyuanVideoアーキテクチャに基づいて開発されました。このモデルは画像潜在的拼接技術を用いて、参考画像情報を動画生成プロセスに効果的に統合し、高解像度動画の生成をサポートし、カスタマイズ可能なLoRA効果トレーニング機能を提供します。この技術は動画制作分野において重要な意味を持ち、制作者が高品質な動画コンテンツを迅速に生成し、制作効率を向上させるのに役立ちます。

映像制作

71.8K

Wan2.1 T2V 14B

Wan2.1-T2V-14Bは、拡散トランスフォーマーアーキテクチャに基づき、革新的な時空間変分オートエンコーダー(VAE)と大規模データトレーニングを組み合わせた、最先端のテキストから動画への生成モデルです。様々な解像度で高品質な動画コンテンツを生成でき、中国語と英語のテキスト入力をサポートしており、既存のオープンソースモデルや商用モデルを性能と効率の面で凌駕しています。コンテンツ制作、広告制作、動画編集など、効率的な動画生成が必要な場面に適しています。現在、Hugging Faceプラットフォームで無料で提供されており、動画生成技術の発展と応用を促進することを目的としています。

映像制作

48.6K

中国語精選

Wan

Wanはアリババの通義实验室が開発した、強力な動画生成能力を備えた高度なビジュアル生成モデルです。テキスト、画像、その他の制御信号に基づいて動画を生成できます。Wan 2.1シリーズモデルは完全オープンソース化されています。主な特長として、複雑な動作の生成能力の高さ(幅広い身体動作、複雑な回転、動的なシーン遷移、滑らかなカメラワークを含むリアルな動画の生成)、正確な物理シミュレーション(現実世界の物理法則に沿った動画の生成)、映画のような質感(豊富なテクスチャと多様なスタイリッシュな効果)、制御可能な編集機能(画像や動画を参考に正確な編集が可能)が挙げられます。このモデルのオープンソース化は、動画生成分野に新たな可能性をもたらし、利用障壁を下げ、関連技術の発展を促進します。

映像制作

58.0K

PIKE RAG

PIKE-RAGは、マイクロソフトが開発したドメイン知識と推論強化生成モデルであり、知識抽出、保存、推論ロジックによって大規模言語モデル(LLM)の能力を強化することを目的としています。多モジュール設計により、複雑なマルチホップ質問応答タスクを処理でき、製造業、鉱業、製薬業などの分野で質問応答の精度を大幅に向上させました。PIKE-RAGの主な利点としては、効率的な知識抽出能力、強力な複数情報統合能力、複数ステップ推論能力があり、高度なドメイン知識と複雑な論理推論が必要なシナリオで優れたパフォーマンスを発揮します。

研究機器

57.1K

Skyreels V1 Hunyuan I2V

SkyReels V1は、HunyuanVideoをファインチューニングした人間中心の動画生成モデルです。高品質の映画作品から学習しており、映画のような質感の動画コンテンツを生成できます。本モデルは、オープンソース分野において業界をリードする水準に達しており、特に顔の表情のキャプチャとシーンの理解において優れた性能を発揮します。主な利点としては、オープンソースにおけるリーディング性、高度な顔アニメーション技術、映画レベルの光と影の美学などが挙げられます。映画制作、広告制作など、高品質な動画生成が必要な場面に適しており、幅広い応用が期待できます。

映像制作

65.4K

Skyreels V1

SkyReels-V1は、高品質な映画作品クリップを用いて微調整されたオープンソースの人間中心型動画基礎モデルであり、高品質な動画コンテンツの生成に特化しています。このモデルは、オープンソース分野においてトップレベルに達し、商用モデルにも匹敵します。主な利点としては、高品質な顔表情のキャプチャ、映画レベルの光と影の効果、そしてマルチGPU並列処理に対応した効率的な推論フレームワークSkyReelsInferなどが挙げられます。このモデルは、映画制作、広告制作など、高品質な動画生成が必要な場面に適しています。

映像制作

69.0K

Deepscaler 1.5B Preview

DeepScaleR-1.5B-Previewは、強化学習によって最適化された大規模言語モデルであり、数学問題解決能力の向上に特化しています。このモデルは分散型強化学習アルゴリズムを用いることで、長文推論における精度を大幅に向上させています。主な利点としては、効率的なトレーニング戦略、顕著な性能向上、そしてオープンソースによる柔軟性などが挙げられます。このモデルはカリフォルニア大学バークレー校のSky Computing LabとBerkeley AI Researchチームによって開発され、特に数学教育や競技数学の分野における人工知能の応用を推進することを目的としています。MITオープンソースライセンスを採用しており、研究者や開発者は無料で利用できます。

学習教育

59.9K

Lumina Video

Lumina-Videoは、Alpha-VLLMチームが開発した、テキストから高品質なビデオコンテンツを生成するためのビデオ生成モデルです。深層学習技術に基づいており、ユーザーが入力したテキストプロンプトに基づいて対応するビデオを生成でき、効率性と柔軟性を備えています。ビデオ生成分野において重要な意味を持ち、コンテンツ制作者に強力なツールを提供し、ビデオ素材を迅速に生成することを可能にします。現在、このプロジェクトはオープンソース化されており、様々な解像度とフレームレートのビデオ生成をサポートし、詳細なインストールと使用方法ガイドを提供しています。

映像制作

59.9K

Zonos V0.1

Zonos-v0.1は、Zyphraチームが開発したリアルタイムテキスト音声変換(TTS)モデルであり、高忠実度の音声クローン機能を備えています。このモデルは、Apache 2.0オープンソースライセンスの下で公開されている、16億パラメータのTransformerモデルと16億パラメータのハイブリッドモデル(Hybrid)で構成されています。テキストプロンプトに基づいて自然で表現力豊かな音声を作成でき、複数の言語をサポートしています。さらに、5~30秒の音声クリップで高品質の音声クローンを作成でき、話速、トーン、音質、感情などの条件に合わせて調整可能です。主な利点としては、生成品質が高く、リアルタイムのインタラクションに対応し、柔軟な音声制御機能を提供している点が挙げられます。このモデルの公開は、TTS技術の研究開発を促進することを目的としています。

言語克服

59.1K

Hibiki

Hibikiは、ストリーミング音声翻訳に特化した先進的なモデルです。十分なコンテキスト情報をリアルタイムに蓄積することで、正確な翻訳を逐次生成します。音声翻訳とテキスト翻訳をサポートし、音声変換も可能です。マルチストリームアーキテクチャに基づいており、ソース音声とターゲット音声を同時に処理し、連続したオーディオストリームとタイムスタンプ付きテキスト翻訳を生成します。主な利点としては、高忠実度の音声変換、低遅延のリアルタイム翻訳、複雑な推論戦略への適合性などが挙げられます。Hibikiは現在、フランス語から英語への翻訳をサポートしており、国際会議や多言語ライブ配信など、リアルタイムで効率的な翻訳が必要な場面に適しています。モデルはオープンソースで無料で、開発者や研究者にご利用いただけます。

翻訳

51.1K

Qwen2.5 1M

Qwen2.5-1Mは、長シーケンス処理向けに設計されたオープンソースの人工知能言語モデルです。最大100万トークンのコンテキスト長をサポートします。革新的なトレーニング方法と技術的最適化により、長シーケンス処理のパフォーマンスと効率が大幅に向上しました。長コンテキストタスクで優れたパフォーマンスを発揮しながら、短テキストタスクのパフォーマンスも維持し、既存の長コンテキストモデルの優れたオープンソース代替手段となっています。このモデルは、ドキュメント分析や情報検索など、大量のテキストデータを処理する必要があるシナリオに適しており、開発者に強力な言語処理能力を提供します。

AIモデル

54.1K

BEN2

BEN2(Background Erase Network)は、Confidence Guided Matting(CGM)プロセスを採用した革新的な画像セグメンテーションモデルです。モデルの確信度が低いピクセルを専門に処理する細分化ネットワークにより、より正確な切り抜きを実現します。BEN2は、髪の毛の切り抜き、4K画像処理、オブジェクトセグメンテーション、エッジの細分化において優れた性能を発揮します。基本モデルはオープンソースであり、ユーザーはAPIまたはWebデモを通じて完全なモデルを無料で試用できます。このモデルのトレーニングデータには、DIS5kデータセットと22Kの独自のセグメンテーションデータセットが含まれており、多様な画像処理ニーズに対応できます。

画像編集

52.2K

高品質新製品

Yue

YuEは、香港科技大学と多様なモダリティアート投影チームによって開発されたオープンソースの音楽生成モデルです。与えられた歌詞に基づいて、ボーカルと伴奏を含む最長5分の完全な楽曲を生成できます。語彙強化オーディオマーカー、デュアルマーキング技術、歌詞連鎖思考などの技術革新により、歌詞から楽曲生成という複雑な問題を解決しました。YuEの主な利点は、高品質の楽曲を生成でき、複数の言語と音楽スタイルに対応し、拡張性と制御性に優れていることです。現在、このモデルは無料でオープンソースとして公開されており、音楽生成技術の発展を促進することを目的としています。

音楽生成

58.2K

Llasa 1B

Llasa-1Bは、香港科技大学音声研究室によって開発されたテキスト読み上げモデルです。LLaMAアーキテクチャを基盤とし、XCodec2コードブックの音声トークンを組み合わせることで、自然で滑らかな音声へのテキスト変換を実現しています。25万時間の中国語と英語の音声データで訓練されており、テキストからの音声生成に加え、指定の音声プロンプトを利用した合成も可能です。主な利点として、高品質な多言語音声の生成能力があり、オーディオブック、音声アシスタントなど、様々な音声合成シーンに適しています。本モデルはCC BY-NC-ND 4.0ライセンスを採用しており、商用利用は禁止されています。

テキスト読み上げ音声

60.7K

Llasa 3B

Llasa-3Bは、LLaMAアーキテクチャに基づいて開発された強力なテキスト音声変換(TTS)モデルであり、中国語と英語の音声合成に特化しています。XCodec2の音声符号化技術と組み合わせることで、テキストを自然で滑らかな音声に効率的に変換できます。主な利点としては、高品質の音声出力、多言語合成のサポート、柔軟な音声プロンプト機能などが挙げられます。このモデルは、オーディオブック制作、音声アシスタント開発など、音声合成が必要な様々な場面に適しています。オープンソースであるため、開発者は自由に機能を探求?拡張することができます。

テキスト音声変換

62.7K

Minirag

MiniRAGは、小型言語モデル用に設計された検索強化生成システムであり、RAGプロセスの簡素化と効率化を目指しています。意味を理解する異種グラフ索引メカニズムと軽量なトポロジ拡張検索手法により、従来のRAGフレームワークにおける小型モデルの性能制限の問題を解決します。このモデルは、モバイルデバイスやエッジコンピューティング環境など、リソースの限られた環境で顕著な利点を発揮します。また、MiniRAGはオープンソースであるため、開発者コミュニティによる容易な採用と改良が可能です。

モデルトレーニングとデプロイ

48.0K

Mattergen

MatterGenは、マイクロソフト研究所が開発した、材料設計のための生成AIツールです。用途に合わせて、特定の化学的、機械的、電気的、または磁気的特性を持つ新規材料を直接生成でき、材料探索に新たなパラダイムを提供します。このツールの登場により、新規材料の研究開発プロセスが加速し、研究開発コストの削減、そして電池、太陽電池、CO2吸着剤などの分野において重要な役割を果たすと期待されています。現在、MatterGenのソースコードはGitHubで公開されており、一般の人が使用および開発を進めることができます。

研究機器

68.4K

Kokoro 82M

Kokoro-82Mは、hexgradによって作成され、Hugging Faceでホストされているテキスト音声変換(TTS)モデルです。8200万パラメーターを備え、Apache 2.0ライセンスの下でオープンソースとして公開されています。2024年12月25日にv0.19版がリリースされ、10種類のユニークな音声パックを提供しています。TTS Spaces Arenaで1位を獲得しており、パラメーター規模とデータ使用における効率性の高さを示しています。アメリカ英語とイギリス英語に対応し、高品質の音声出力を生成できます。

テキスト読み上げ音声

91.6K

Llama 3 Patronus Lynx 8B Instruct

Llama-3-Patronus-Lynx-8B-Instructは、Patronus AIが開発したmeta-llama/Meta-Llama-3-8B-Instructモデルをファインチューニングしたバージョンです。RAG設定における幻覚検出を主な目的としています。CovidQA、PubmedQA、DROP、RAGTruthなど複数データセット(人工アノテーションデータと合成データを含む)で訓練されており、与えられた文書、質問、回答が文書内容に忠実であるか、文書外の新たな情報を含んでいないか、文書情報と矛盾していないかを評価できます。

モデルトレーニングとデプロイメント

48.3K

Meta Video Seal

Meta Video Sealは、高度なオープンソースのビデオ透かし埋め込みモデルであり、動画編集後も永続的な、不可視の透かしを埋め込むことができます。AI生成コンテンツの増加に伴い、動画の起源を検証することが極めて重要になっています。Video Sealは、不可視の透かしを埋め込むことで、動画が編集された後でも透かしの完全性を維持し、著作権保護とコンテンツ検証に重要な役割を果たします。

映像編集

50.2K

Olmo 2 1124 13B Instruct

OLMo-2-1124-13B-Instructは、Allen AI研究所が開発した大規模言語モデルで、テキスト生成と対話タスクに特化しています。数学問題の解答や科学的な質問への回答など、複数のタスクで優れた性能を発揮します。130億個のパラメータを持つこのモデルは、特定のデータセットを用いた教師ありファインチューニングと強化学習によって訓練され、性能と安全性が向上しています。オープンソースモデルであるため、研究者や開発者は言語モデルの研究開発に活用できます。

会話型AI

51.1K

Olmo 2 1124 7B Instruct

OLMo-2-1124-7B-Instructは、Allen人工知能研究所が開発した大規模言語モデルであり、対話生成タスクに特化しています。本モデルは、数学問題解答、GSM8K、IFEvalなど、複数のタスクにおいて最適化されており、Tülu 3データセットを用いて教師あり微調整が施されています。Transformersライブラリをベースに構築されており、研究および教育目的で使用できます。主な利点としては、高性能、多様なタスクへの適応性、オープンソースであることが挙げられ、自然言語処理分野における重要なツールとなっています。

会話型AI

45.5K

Allegro TI2V

Allegro-TI2Vは、ユーザーが提供したプロンプトと画像から動画コンテンツを生成できるテキスト画像から動画生成モデルです。オープンソースであること、多様なコンテンツ制作能力、高品質の出力、コンパクトで効率的なモデルパラメータ、そして複数の精度とGPUメモリ最適化に対応していることから注目を集めています。これは、動画生成分野における現在の人工知能技術の最先端を示しており、重要な技術的価値と商業的応用可能性を秘めています。Allegro-TI2VモデルはHugging Faceプラットフォームで提供され、Apache 2.0オープンソースライセンスに従っています。ユーザーは無料でダウンロードして使用できます。

映像制作

52.7K

Llama 3.1 Tulu 3 70B DPO

Llama-3.1-Tulu-3-70B-DPOは、Tülu3モデルファミリーの一部であり、最新の事後トレーニング技術に関する包括的なガイドを提供します。このモデルファミリーは、チャット以外の様々なタスク(MATH、GSM8K、IFEvalなど)において最先端の性能を実現することを目指しています。公開可能な合成データと人間が作成したデータセットに基づいてトレーニングされており、主に英語を使用し、Llama 3.1コミュニティライセンスに準拠しています。

テキスト生成

47.7K

- 1

- 2

- 3

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

39.2K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.6K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

39.5K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.4K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M