Qwq 32B Preview Gptqmodel 4bit Vortex V3

紹介 :

本製品は、Qwen2.5-32Bをベースとした4ビット量子化言語モデルです。GPTQ技術により、高効率推論と低リソース消費を実現しています。高い性能を維持しつつ、モデルのストレージと計算要件を大幅に削減するため、リソースが限られた環境での使用に適しています。本モデルは、インテリジェントカスタマーサービス、プログラミング支援、コンテンツ作成など、高性能な言語生成を必要とするアプリケーションシナリオを主に対象としています。オープンソースライセンスと柔軟な展開方法により、商業および研究分野で幅広い応用が期待できます。

ターゲットユーザー :

本製品は、高性能な言語生成を必要とする開発者や企業、特にリソース消費に敏感なシナリオ(インテリジェントカスタマーサービス、プログラミング支援ツール、コンテンツ作成プラットフォームなど)に適しています。高効率な量子化技術と柔軟な展開方法により、理想的な選択肢となります。

使用シナリオ

インテリジェントカスタマーサービスシステムにおいて、本モデルは自然言語による応答を迅速に生成し、顧客満足度の向上に貢献します。

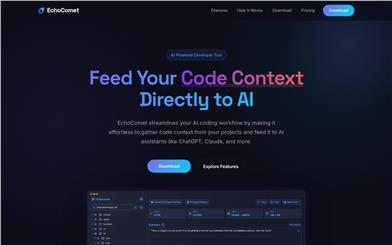

開発者は本モデルを利用してコードスニペットや最適化提案を生成し、プログラミング効率を向上させることができます。

コンテンツクリエイターは本モデルを使用して、ストーリー、記事、広告コピーなどの創造的なテキストを生成できます。

製品特徴

4ビット量子化に対応し、モデルのストレージと計算要件を大幅に削減

GPTQ技術に基づき、高効率推論と低遅延応答を実現

多言語テキスト生成に対応し、幅広いアプリケーションシナリオをカバー

柔軟なAPIインターフェースを提供し、開発者による統合と展開を容易化

オープンソースライセンスにより、自由な使用と二次開発を許可

PyTorchやSafetensorsなど、複数の推論フレームワークに対応

詳細なモデルカードと使用例を提供し、迅速な導入を支援

クラウド環境やローカルサーバーなど、複数のプラットフォームへの展開に対応

使用チュートリアル

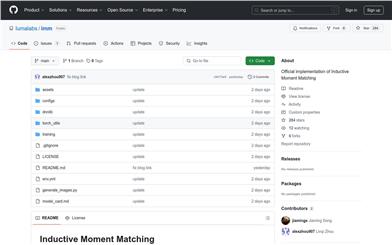

1. Hugging Faceページにアクセスし、モデルファイルと依存ライブラリをダウンロードします。

2. AutoTokenizerを使用してモデルのトークナイザーを読み込みます。

3. GPTQModelモデルを読み込み、モデルパスを指定します。

4. 入力テキストを作成し、トークナイザーを使用してモデル入力形式に変換します。

5. モデルのgenerateメソッドを呼び出して、テキスト出力を生成します。

6. トークナイザーを使用して出力結果をデコードし、最終的に生成されたテキストを取得します。

7. 必要に応じて、生成されたテキストをさらに処理または適用します。

おすすめAI製品

中国語精選

文心一言

文心一言は、百度が開発した最新世代の知識増強型大規模言語モデルです。人間と対話したり、質問に答えたり、創作を支援したりすることで、人々が効率的かつ簡単に情報、知識、そしてインスピレーションを得られるよう支援します。飛槳(PaddlePaddle)深層学習プラットフォームと文心知識増強大規模言語モデルをベースに、膨大なデータと大規模な知識から継続的に学習しており、知識増強、検索増強、対話増強といった技術的特徴を備えています。皆様からのフィードバックをお待ちしております。文心一言の更なる進化にご協力ください。

チャットボット

5.4M

海外精選

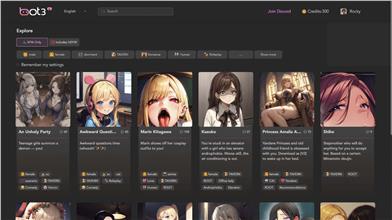

Bot3 AI

BOT3 AIは、究極のAI会話ロボットです。かつてないほどスマートな会話を実現し、AIキャラクターとの交流をお楽しみいただけます。

チャットボット

2.7M