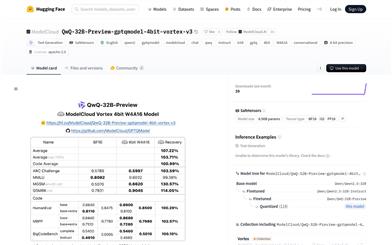

Qwq 32B Preview Gptqmodel 4bit Vortex V3

本製品は、Qwen2.5-32Bをベースとした4ビット量子化言語モデルです。GPTQ技術により、高効率推論と低リソース消費を実現しています。高い性能を維持しつつ、モデルのストレージと計算要件を大幅に削減するため、リソースが限られた環境での使用に適しています。本モデルは、インテリジェントカスタマーサービス、プログラミング支援、コンテンツ作成など、高性能な言語生成を必要とするアプリケーションシナリオを主に対象としています。オープンソースライセンスと柔軟な展開方法により、商業および研究分野で幅広い応用が期待できます。

チャットボット

53.3K

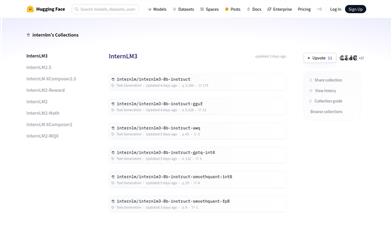

Internlm3

InternLM3は、InternLMチームが開発した、高性能な言語モデルのシリーズで、テキスト生成タスクに特化しています。様々な量子化技術によって最適化されており、異なるハードウェア環境下でも高効率に動作し、優れた生成品質を維持します。主なメリットとしては、効率的な推論性能、多様な適用シーン、そして様々なテキスト生成タスクへの最適化サポートが挙げられます。InternLM3は、高品質なテキスト生成を必要とする開発者や研究者にとって最適であり、自然言語処理分野における迅速なアプリケーション開発を支援します。

AIモデル

46.1K

Voyage 3 Large

Voyage-3-largeは、Voyage AIが開発した最新の多言語汎用埋め込みモデルです。法律、金融、コードなど8つの分野、100個のデータセットにおいてトップの座を獲得し、OpenAI-v3-largeやCohere-v3-Englishを凌駕しています。Matryoshka学習と量子化感知トレーニングによって、より低次元の埋め込みとint8およびバイナリ量子化に対応し、ベクトルデータベースのコストを大幅に削減しながら、検索品質への影響を最小限に抑えています。また、32Kトークンのコンテキスト長に対応しており、OpenAI(8K)、Cohere(512)を大きく上回ります。

AIモデル

55.2K

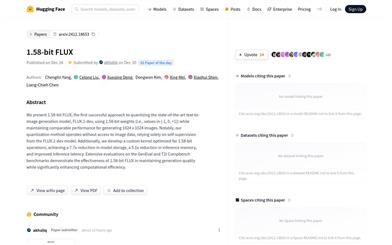

1.58 Bit FLUX

1.58-bit FLUXは、{-1, 0, +1}の値を用いてFLUX.1-devモデルを量子化することで、1024x1024画像の生成性能を維持しながら、高度なテキストから画像生成を実現するモデルです。本手法は画像データへのアクセスを必要とせず、FLUX.1-devモデルの自己教師学習に完全に依存しています。さらに、1.58ビット演算を最適化したカスタムカーネルを開発し、モデルサイズは7.7倍、推論メモリは5.1倍の削減、推論遅延の改善を実現しました。GenEvalとT2I Compbenchベンチマークにおける広範な評価により、1.58-bit FLUXは生成品質を維持しつつ、計算効率を大幅に向上させることが示されました。

画像生成

70.7K

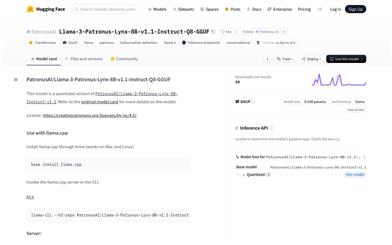

Llama 3 Patronus Lynx 8B V1.1 Instruct Q8 GGUF

PatronusAI/Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUFは、Llamaモデルに基づく量子化バージョンで、対話と幻覚検出のために設計されています。このモデルはGGUF形式を使用し、8.03億のパラメータを持ち、大規模言語モデルに分類されます。その重要性は、高品質な対話生成と幻觉検出能力を提供しつつ、モデルの高効率動作を維持できる点にあります。このモデルはTransformersライブラリとGGUFテクノロジーに基づいて構築されており、高性能な対話システムとコンテンツ生成が必要なアプリケーションシナリオに適しています。

チャットボット

46.4K

Qwen2.5 Coder 32B Instruct GGUF

Qwen2.5-Coderはコード生成に特化したモデルであり、コード生成などの分野で顕著な性能向上を実現しています。パラメータ規模は多様で、量子化にも対応しています。無料であり、開発者の効率と品質向上を目的としています。

コード推論

50.2K

量子化llama

LlamaモデルはMeta社が発表した大規模言語モデルです。量子化技術により、モデルのサイズを小さくし、動作速度を向上させながら、モデルの品質と安全性を維持しています。これらのモデルは、モバイルデバイスやエッジデバイスへの展開に特に適しており、リソースに制限のあるデバイスでも高速なオンデバイス推論を提供し、メモリ使用量を削減します。量子化Llamaモデルの開発は、モバイルAI分野における重要な進歩を示しており、多くの開発者が豊富な計算リソースを必要とせずに、高品質なAIアプリケーションを構築および展開できるようになります。

モデルトレーニングとデプロイ

46.1K

高品質新製品

Torchao

torchaoは、PyTorchのライブラリであり、カスタムデータ型と最適化に重点を置いています。量子化とスパース化された重み、勾配、オプティマイザ、活性化関数をサポートし、推論とトレーニングに使用されます。torch.compile()とFSDP2と互換性があり、ほとんどのPyTorchモデルの高速化を実現します。torchaoは、量子化認識トレーニング(QAT)やポストトレーニング量子化(PTQ)などの技術を通じて、精度損失を最小限に抑えながら、モデルの推論速度とメモリ効率を向上させることを目指しています。

AI開発助手

54.4K

Cog Flux

Cog inference for flux models は、Black Forest Labsが開発したFLUX.1 [schnell]およびFLUX.1 [dev]モデル向けの推論エンジンです。コンパイルと量子化、有害コンテンツ検出、img2imgサポートに対応しており、画像生成モデルのパフォーマンスとセキュリティの向上を目指しています。

AI画像生成

55.2K

Nemotron Mini 4B Instruct

Nemotron-Mini-4B-Instructは、NVIDIAが開発した小型言語モデルです。蒸留、枝刈り、量子化による最適化により、速度の向上とデバイス上での展開が容易になっています。これは、NVIDIAの大規模言語モデル圧縮技術を用いて、nvidia/Minitron-4B-BaseをNemotron-4 15Bから枝刈りと蒸留によって得られた、微調整済みのモデルです。この指示モデルは、ロールプレイング、検索強化型質問応答(RAG QA)、機能呼び出し向けに最適化されており、4096トークンのコンテキスト長をサポートし、商用利用可能です。

AIモデル

57.1K

Comfyui GGUF

ComfyUI-GGUFは、ComfyUIネイティブモデルにGGUF量子化サポートを提供するプロジェクトです。llama.cppによって普及したGGUF形式でモデルファイルを保存することを可能にします。一般的なUNETモデル(conv2d)は量子化に適していませんが、fluxのようなtransformer/DiTモデルは量子化の影響を受けにくいようです。これにより、低スペックGPUでも、重みあたりビットレートを低くして実行できるようになります。

AIモデル

91.4K

海外精選

Vllm

vLLMは、大規模言語モデル(LLM)の推論とサービス提供のための、高速で使いやすく、効率的なライブラリです。最新のサービススループット技術、効率的なメモリ管理、連続バッチ処理リクエスト、CUDA/HIPグラフによる高速モデル実行、量子化技術、最適化されたCUDAカーネルなどを用いることで、高性能な推論サービスを提供します。vLLMは、人気のHugging Faceモデルとのシームレスな統合をサポートし、並列サンプリング、ビームサーチなど、様々なデコードアルゴリズムに対応しています。テンソル並列性をサポートし、分散推論に適しており、ストリーミング出力に対応し、OpenAI APIサーバーとの互換性があります。さらに、NVIDIAとAMDのGPU、実験的なプレフィックスキャッシュとマルチLoRAのサポートにも対応しています。

開発とツール

64.9K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

39.2K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.6K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

39.5K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.4K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M