GLM 4 Voice

紹介 :

GLM-4-Voiceは、清華大学チームが開発したエンドツーエンドの音声モデルです。日本語と英語の音声を直接理解し生成することで、リアルタイムの音声対話を可能にします。高度な音声認識と音声合成技術により、音声からテキスト、そして再び音声へのシームレスな変換を実現し、低遅延かつ高精度な対話能力を備えています。音声モーダルにおける知性と合成表現力に最適化されており、リアルタイムの音声インタラクションが必要な場面に適しています。

ターゲットユーザー :

GLM-4-Voiceのターゲットユーザーは、開発者、企業、そしてリアルタイムの音声インタラクションを必要とする個人や組織です。開発者にとっては、音声インタラクションアプリケーションを構築するための強力なツールとなります。企業にとっては、顧客サービスの効率と品質の向上に役立ちます。個人ユーザーにとっては、革新的な音声インタラクション体験を提供します。

使用シナリオ

? ユーザーをリラックスさせるために優しい声で誘導する

? サッカーの試合を実況するために興奮した声で解説する

? 怪談を語るために物悲しい声で話す

製品特徴

? 音声認識:連続した音声入力を離散的なトークンに変換

? 音声合成:離散化された音声トークンを連続した音声出力に変換

? 感情制御:ユーザーの指示に従って、音声の感情、トーン、速度、方言などを変更

? ストリーミング推論:テキストと音声の両モーダルのコンテンツを交互にストリーミング出力することで、エンドツーエンドの対話遅延を低減

? 事前学習能力:数百万時間の音声データと数千億トークンの音声テキスト交錯データで事前学習されており、強力な音声理解とモデリング能力を備えている

? 多言語対応:日本語と英語の音声を直接理解し生成し、リアルタイムの音声対話を可能にする

使用チュートリアル

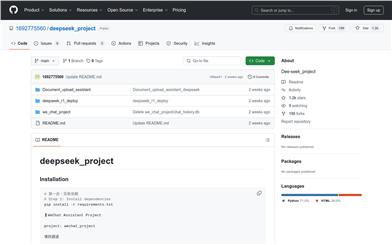

1. まずリポジトリをダウンロードします:gitコマンドを使用してプロジェクトをローカルにクローンします。

2. 依存関係をインストールします:プロジェクト内のrequirements.txtファイルに従って、必要なPython依存関係をインストールします。

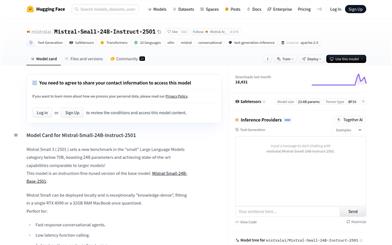

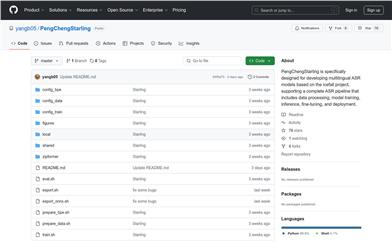

3. モデルをダウンロードします:プロジェクトガイドに従って、必要な音声モデルとトークナイザーをダウンロードします。

4. モデルサービスを開始します:model_server.pyスクリプトを実行してモデルサービスを開始します。

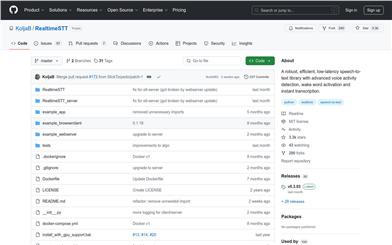

5. Webデモを開始します:web_demo.pyスクリプトを実行してWebデモサービスを開始します。

6. Webデモにアクセスします:ブラウザでhttp://127.0.0.1:8888にアクセスしてWebデモを使用します。

おすすめAI製品

中国語精選

豆包(doubao)

豆包(Doubao)は、自然言語処理を用いたインテリジェントなチャットボットです。天気、ニュース、ジョーク、音楽など、様々な話題でユーザーと自然な会話を楽しむことができます。さらに、ユーザーの好みや習慣に基づいて、関連性の高いコンテンツやサービスをレコメンドします。豆包はあなた専属のチャットアシスタントとして、寂しさを解消します。

会話型AI

17.0M

中国語精選

Kimiスマートアシスタント

Kimi Chatは、月之暗面科技が開発した、スマートなチャットボットアプリです。大容量の知識ベースを備え、インテリジェントな雑談、質問への回答、生活支援サービスの提供など、高度なインテリジェントなインタラクション能力を備えています。いつでもどこでもKimiとチャットして楽しみを見つけることができ、その返答は多様で、会話をより楽しくします。Kimi Chatは完全に無料で、QRコードをスキャンするか、携帯電話で検索して直接使用できます。

会話型AI

15.9M