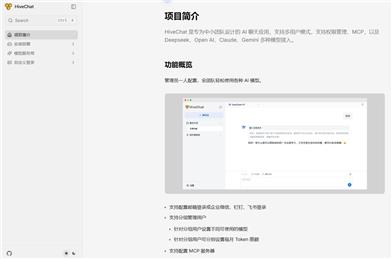

GLM 4 Voice

简介 :

GLM-4-Voice是由清华大学团队开发的端到端语音模型,能够直接理解和生成中英文语音,进行实时语音对话。它通过先进的语音识别和合成技术,实现了语音到文本再到语音的无缝转换,具备低延迟和高智商的对话能力。该模型在语音模态下的智商和合成表现力上进行了优化,适用于需要实时语音交互的场景。

需求人群 :

GLM-4-Voice的目标受众包括开发者、企业以及任何需要实时语音交互的个人或组织。对于开发者而言,它提供了一个强大的工具来构建语音交互应用;对于企业,它可以帮助提升客户服务的效率和质量;对于个人用户,它提供了一种新颖的语音交互体验。

使用场景

• 用轻柔的声音引导用户放松

• 用激动的声音解说足球比赛

• 用哀怨的声音讲一个鬼故事

产品特色

• 语音识别:将连续的语音输入转化为离散的token

• 语音合成:将离散化的语音token转化为连续的语音输出

• 情感控制:根据用户的指令要求改变语音的情感、语调、语速、方言等属性

• 流式推理:支持流式交替输出文本和语音两个模态的内容,降低端到端对话延迟

• 预训练能力:在数百万小时音频和数千亿token的音频文本交错数据上进行预训练,具备强大的音频理解和建模能力

• 多语言支持:能够直接理解和生成中英文语音,进行实时语音对话

使用教程

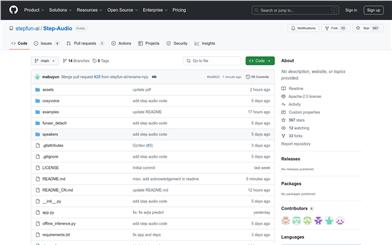

1. 首先下载仓库:使用git命令克隆项目到本地

2. 安装依赖:根据项目中的requirements.txt文件安装所需的Python依赖

3. 下载模型:根据项目指南下载所需的语音模型和分词器

4. 启动模型服务:运行model_server.py脚本启动模型服务

5. 启动Web Demo:运行web_demo.py脚本启动Web Demo服务

6. 访问Web Demo:在浏览器中访问http://127.0.0.1:8888来使用Web Demo