Whisper Large V3 Turbo

紹介 :

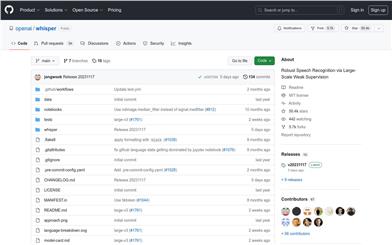

Whisper large-v3-turboは、OpenAIが開発した高度な自動音声認識(ASR)および音声翻訳モデルです。500万時間以上のラベル付け済みデータでトレーニングされており、ゼロショット設定で多くのデータセットやドメインに汎化できます。このモデルはWhisper large-v3を微調整したバージョンで、速度向上のためデコード層が32から4に削減されていますが、わずかに品質が低下する可能性があります。

ターゲットユーザー :

AI研究者、開発者、そして効率的な音声認識ソリューションを必要とする企業が主な対象ユーザーです。多言語対応と高速処理能力により、大量かつ多様な音声データを処理する必要があるユーザーに特に適しています。

使用シナリオ

リアルタイムの音声テキスト変換による会議記録効率の向上

モバイルアプリへの統合による多言語音声翻訳サービスの提供

インタビュー、講演会など長尺の音声コンテンツの転写と分析

製品特徴

99種類の言語の音声認識と翻訳をサポート

ゼロショット設定で複数のデータセットやドメインに汎化可能

デコード層の削減によりモデルの処理速度を向上

長尺の音声ファイルのチャンク処理に対応

温度スケーリングや先行トークンに基づく条件付けなど、すべてのWhisperデコード戦略と互換性あり

ソース音声の言語を自動予測

音声書き起こしと音声翻訳タスクに対応

タイムスタンプの予測が可能で、文レベルまたは単語レベルのタイムスタンプを提供

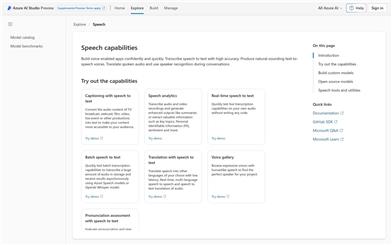

使用チュートリアル

まず、TransformersライブラリとDatasets、Accelerateライブラリをインストールします。

AutoModelForSpeechSeq2SeqとAutoProcessorを使用して、Hugging Face Hubからモデルとプロセッサを読み込みます。

pipelineクラスを使用して、自動音声認識のためのパイプラインを作成します。

Hugging Face Hubのサンプルデータセットまたはローカルの音声ファイルなど、音声データを読み込み、準備します。

パイプラインを呼び出し、音声データを入力として渡して、転写結果を取得します。

必要に応じて、generate_kwargsパラメーターを設定して、追加のデコード戦略を有効化できます。

音声翻訳を行う場合は、taskパラメーターを'translate'に設定してタスクの種類を指定します。

タイムスタンプを予測する必要がある場合は、return_timestampsパラメーターをTrueに設定します。