Crisperwhisper

紹介 :

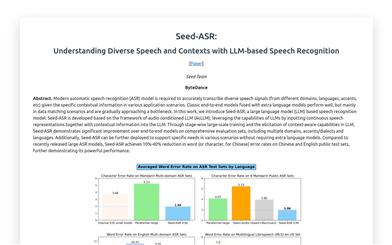

CrisperWhisperは、OpenAIのWhisperモデルを高度に改良したモデルで、高速かつ正確な単語単位の音声認識を目的として設計されています。正確な単語レベルのタイムスタンプを提供します。元のWhisperモデルと比較して、CrisperWhisperは、つなぎ言葉、間、吃音、誤った開始など、発話されたすべての単語を単語単位で転写することに重点を置いています。TED、AMIなどの単語単位データセットで最高ランクを獲得しており、INTERSPEECH 2024で発表されました。

ターゲットユーザー :

CrisperWhisperは、高精度な音声認識が必要な研究者や開発者にとって最適です。特に、会議録、講義の転写、言語学習など、口語を単語単位で記録および分析する必要があるシナリオに適しています。

使用シナリオ

研究者はCrisperWhisperモデルを使用して、TEDトークにおける口語のパターンを分析しています。

教育機関は、このモデルを使用して言語学習教材の転写品質を向上させています。

企業はCrisperWhisperを使用して、会議録と要約を自動的に生成しています。

製品特徴

正確な単語レベルのタイムスタンプ:不自然な発話や間があっても、正確なタイムスタンプを提供します。

単語単位の転写:'um'や'uh'などのつなぎ言葉を含む、すべての単語を区別して転写します。

つなぎ言葉検出:つなぎ言葉を検出し、正確に転写します。

幻覚の低減:転写の幻覚を最小限に抑え、精度を高めます。

ストリーミングアプリケーションのサポート:Streamlitアプリケーションを通じて、ユーザーフレンドリーなインターフェースを提供し、オーディオファイルの録音またはアップロードによる転写を可能にします。

高性能:複数のデータセットにおいて、特に単語単位の転写スタイルのデータセットにおいて、Whisper Large v3を大幅に上回っています。

使用チュートリアル

1. CrisperWhisperリポジトリをローカルにクローンします。

2. Python仮想環境を作成してアクティブ化します。

3. 必要な依存ライブラリをインストールします。

4. Hugging Faceアカウントを使用してモデルをダウンロードします。

5. PythonスクリプトまたはStreamlitアプリケーションを使用して、モデルによる音声認識を実行します。

6. 必要に応じてモデルパラメーターを調整して、認識結果を最適化します。

7. 転写結果(単語レベルのタイムスタンプとつなぎ言葉を含む)を確認および分析します。