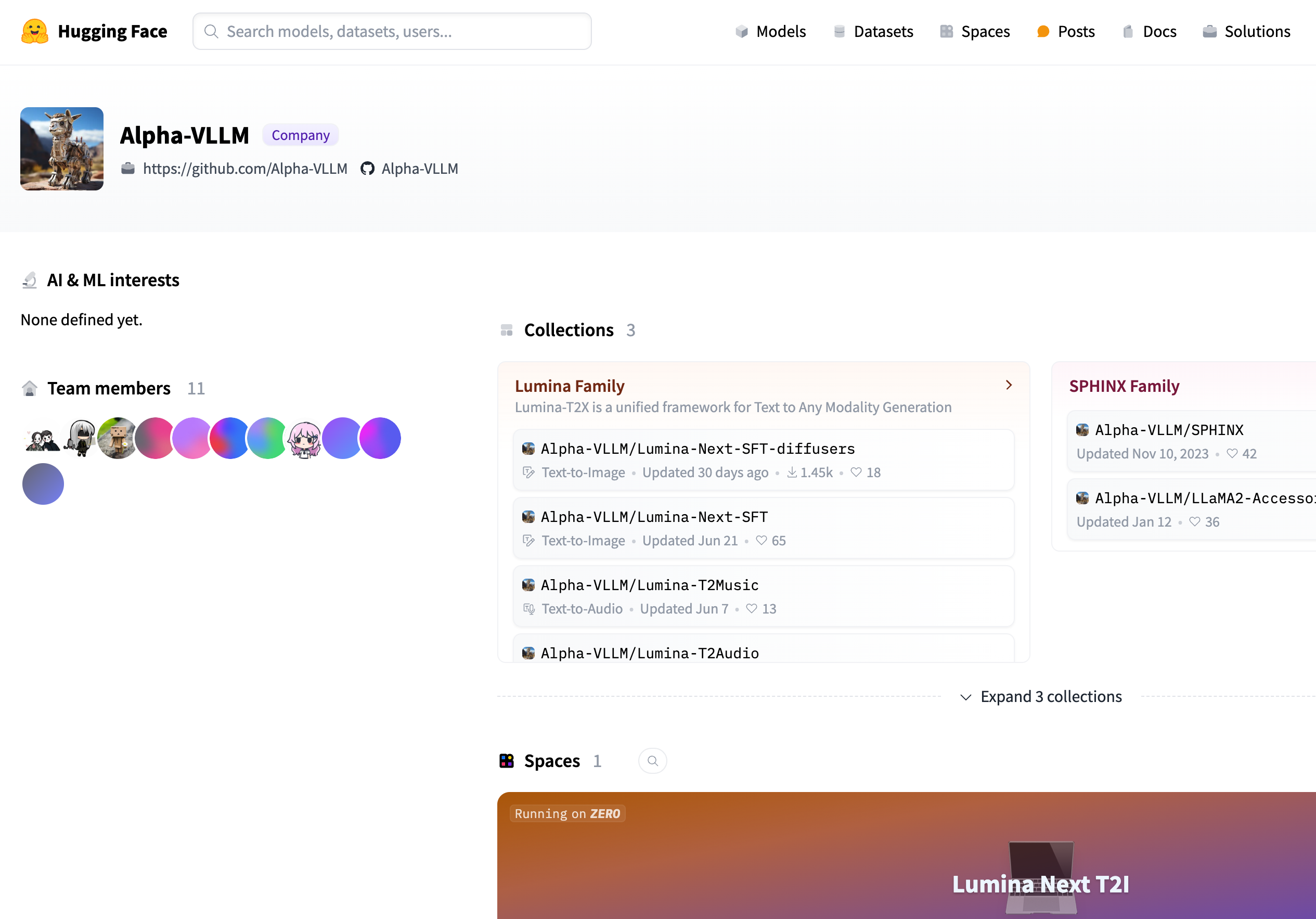

Alpha VLLM

紹介 :

Alpha-VLLMは、テキストから画像、音声など、様々なマルチモーダルコンテンツの生成を支援する一連のモデルを提供します。これらのモデルは深層学習技術に基づいており、コンテンツ制作、データ拡張、自動設計など、幅広い分野で活用できます。

ターゲットユーザー :

Alpha-VLLMモデルは、これらのモデルを活用してコンテンツ制作能力の向上、作業効率の改善、自動設計とパーソナライズされたコンテンツ生成を実現したい開発者、データサイエンティスト、クリエイティブ産業のプロフェッショナルに適しています。

使用シナリオ

Lumina-Next-SFTモデルを使用して、テキスト記述に一致する画像を生成します。

Lumina-T2Musicモデルを使用して、歌詞と同期した音楽を作成します。

mGPT-7Bシリーズモデルを使用して、記事やストーリーを自動生成します。

製品特徴

テキストから画像生成:Lumina Familyシリーズモデルは、テキスト記述を画像に変換します。

テキストから音声生成:Lumina-T2Musicモデルは、テキストを音声コンテンツに変換します。

テキストからテキスト生成:mGPT-7Bシリーズモデルは、テキストコンテンツの生成と編集を支援します。

マルチモーダルフレームワーク:様々なモーダルコンテンツの生成を支援する統合フレームワークを提供します。

モデル更新:モデルは定期的に更新され、技術的な優位性と適応性を維持します。

コミュニティサポート:オープンソースプロジェクトとして、活発なコミュニティと貢献者を抱えています。

使用チュートリアル

ステップ1:Alpha-VLLMのGitHubページにアクセスし、利用可能なモデルとドキュメントを確認します。

ステップ2:テキストから画像、またはテキストから音声など、ニーズに合ったモデルを選択します。

ステップ3:モデルのドキュメントに従って開発環境を設定し、必要な依存関係をインストールします。

ステップ4:選択したモデルをローカルまたはクラウドサーバーにダウンロードして読み込みます。

ステップ5:コードを作成してテキストを入力し、モデルが生成した出力を受信します。

ステップ6:モデルのパラメータをテストおよび調整して、生成コンテンツの品質を最適化します。

ステップ7:モデルをアプリケーションまたはワークフローに統合して、コンテンツの自動生成を実現します。

おすすめAI製品

Deepmind Gemini

Geminiは、Google DeepMindが開発した次世代人工知能システムです。テキスト、画像、ビデオ、音声、コード間のシームレスな相互作用をサポートし、マルチモーダル推論を実行できます。言語理解、推論、数学、プログラミングなど、複数の分野において従来のシステムを凌駕し、現在までに開発された最も強力なAIシステムの一つとなっています。エッジコンピューティングからクラウドコンピューティングまで、様々なニーズに対応できる3つの異なる規模のバージョンがあります。Geminiは、クリエイティブデザイン、ライティングアシスタント、質問応答、コード生成など、幅広い分野で活用できます。

AIモデル

11.4M

中国語精選

剪映dreamina

剪映DreaminaはTikTok(抖音)が提供するAIGCツールです。テキストを入力すると、AIが自動的にクリエイティブな画像を生成します。画像サイズやアスペクト比、テンプレートの種類も調整可能です。将来的には、TikTokの画像投稿やショート動画のコンテンツ制作にも活用され、TikTokのAIによるコンテンツ制作の充実を図ります。

AI画像生成

9.0M