Comfyui Ollama

紹介 :

ComfyUI Ollamaは、ComfyUIワークフロー用に設計されたカスタムノードです。ollama Pythonクライアントを使用して、ユーザーはLLMをワークフローに簡単に統合したり、GPTの実験を行うことができます。このプラグインの主な利点は、Ollamaサーバーとのインタラクションを可能にすることで、ユーザーは画像クエリの実行、プロンプトによるLLMクエリ、微調整パラメーターを使用したLLMクエリを実行し、生成チェーンのコンテキストを維持することができます。

ターゲットユーザー :

["開発者:ComfyUI Ollamaプラグインを利用して、LLMを開発プロジェクトに迅速に統合できます。","研究者:このプラグインを使用して、言語モデルの実験と研究を行うことができます。","データサイエンティスト:画像クエリとテキスト処理機能を利用して、データ分析作業を強化できます。"]

使用シナリオ

OllamaVisionノードを使用して入力画像を視覚的に分析します。

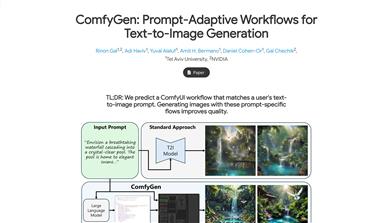

OllamaGenerateノードを使用して、特定のプロンプトに基づいてテキストを生成します。

OllamaGenerateAdvanceノードを組み合わせて、コンテキストを維持する生成チェーンなど、より複雑なテキスト生成タスクを実行します。

製品特徴

OllamaVision:入力画像をクエリする機能を提供します。

OllamaGenerate:指定されたプロンプトでLLMをクエリします。

OllamaGenerateAdvance:指定されたプロンプトでLLMをクエリし、微調整パラメーターと生成チェーンのコンテキストの維持を可能にします。

Ollamaサーバーとの統合:ComfyUIを実行しているホストからアクセス可能な、実行中のOllamaサーバーが必要です。

カスタムノードのインストール:Git URLによるインストールまたはcustom_nodesフォルダへの直接クローンに対応しています。

パラメーターの詳細:Ollama APIドキュメントのパラメーターにアクセスして、詳細情報を取得できます。

使用例:画像ビジョンとLLMテキスト処理を組み合わせた使用方法の例を提供します。

使用チュートリアル

手順1:アクセス可能なOllamaサーバーがあることを確認します。

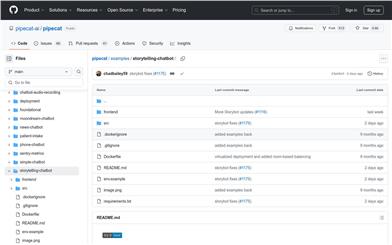

手順2:ComfyUIをインストールし、ComfyUI Ollamaプラグインをcustom_nodesフォルダにクローンまたはダウンロードします。

手順3:ComfyUIを再起動して新しいプラグインを読み込みます。

手順4:ComfyUIで必要なOllamaノードを選択して設定します。

手順5:モデル名やプロンプトなどのノードパラメーターを必要に応じて設定します。

手順6:ワークフローを実行し、Ollamaノードの出力結果を確認します。

手順7:出力に基づいてパラメーターを調整し、ワークフローのパフォーマンスを最適化します。

おすすめAI製品

中国語精選

剪映dreamina

剪映DreaminaはTikTok(抖音)が提供するAIGCツールです。テキストを入力すると、AIが自動的にクリエイティブな画像を生成します。画像サイズやアスペクト比、テンプレートの種類も調整可能です。将来的には、TikTokの画像投稿やショート動画のコンテンツ制作にも活用され、TikTokのAIによるコンテンツ制作の充実を図ります。

AI画像生成

9.0M

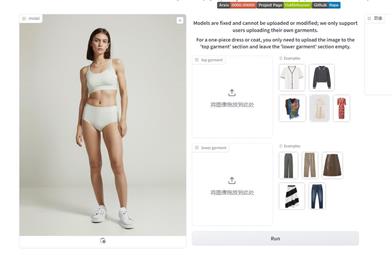

Outfit Anyone

Outfit Anyoneは、衣類を実際に試着することなく様々なファッションスタイルを試せる、超高品質のバーチャル試着製品です。2つの流れを持つ条件付き拡散モデルを採用することで、衣類の変形を柔軟に処理し、よりリアルな効果を生み出します。拡張性が高く、ポーズや体型などの要素を調整でき、アニメキャラクターから実写の人物まで幅広い画像に対応可能です。様々なシーンでの優れたパフォーマンスは、その実用性と実用化への準備が整っていることを示しています。

AI画像生成

5.2M