Comfyui Ollama

简介 :

ComfyUI Ollama是为ComfyUI工作流设计的自定义节点,它使用ollama Python客户端,允许用户轻松地将大型语言模型(LLM)集成到他们的工作流程中,或者仅仅是进行GPT实验。这个插件的主要优点在于它提供了与Ollama服务器交互的能力,使得用户可以执行图像查询、通过给定的提示查询LLM,以及使用精细调整参数进行LLM查询,同时保持生成链的上下文。

需求人群 :

["开发者:可以利用ComfyUI Ollama插件快速集成LLM到他们的开发项目中。","研究人员:可以使用该插件进行语言模型的实验和研究。","数据科学家:可以利用图像查询和文本处理功能来增强他们的数据分析工作。"]

使用场景

使用OllamaVision节点对输入图像进行视觉分析。

通过OllamaGenerate节点根据特定提示生成文本。

结合OllamaGenerateAdvance节点进行更复杂的文本生成任务,如保持上下文的生成链。

产品特色

OllamaVision:提供查询输入图像的能力。

OllamaGenerate:通过给定的提示查询LLM。

OllamaGenerateAdvance:通过给定的提示查询LLM,并允许微调参数和保持生成链的上下文。

与Ollama服务器的集成:需要一个可从运行ComfyUI的主机访问的运行中的Ollama服务器。

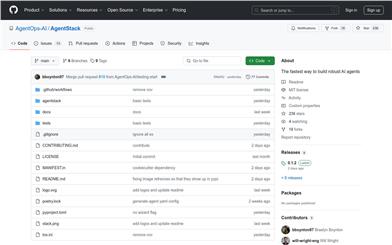

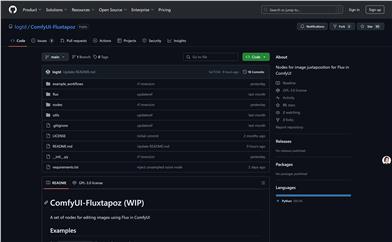

自定义节点安装:支持通过Git URL安装或直接克隆到custom_nodes文件夹。

参数详细信息:提供对Ollama API文档中参数的访问,以获取更多信息。

使用示例:提供了如何将图像视觉与LLM文本处理结合使用的示例。

使用教程

步骤1:确保有一个可访问的Ollama服务器。

步骤2:安装ComfyUI,并克隆或下载ComfyUI Ollama插件到custom_nodes文件夹。

步骤3:重启ComfyUI以加载新插件。

步骤4:在ComfyUI中选择并配置所需的Ollama节点。

步骤5:根据需要设置节点参数,如模型名称和提示。

步骤6:执行工作流,查看Ollama节点的输出结果。

步骤7:根据输出调整参数,优化工作流性能。

精选AI产品推荐

中文精选

剪映dreamina

剪映Dreamina是抖音旗下的AIGC工具,用户可以根据文本内容生成由AI生成的创意图,支持修整图片大小比例和模板类型。未来会用于抖音的图文或短视频的内容创作,丰富抖音在AI创造方面的内容库。

AI图像生成

9.1M

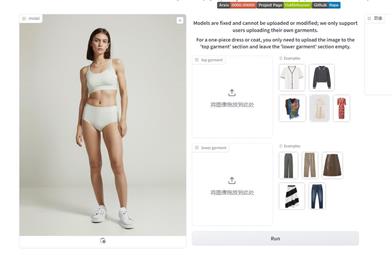

Outfit Anyone

Outfit Anyone 是一款超高质量虚拟试穿产品,使用户能够在不真实试穿衣物的情况下尝试不同的时尚款式。通过采用两个流的条件扩散模型,Outfit Anyone 能够灵活处理衣物变形,生成更逼真的效果。它具备可扩展性,可以调整姿势和身体形状等因素,适用于动漫角色到真实人物的图像。Outfit Anyone 在各种场景下的表现突出了其实用性和准备好投入实际应用的程度。

AI图像生成

5.7M