中文精选

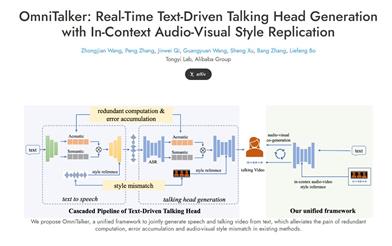

Omnitalker

OmniTalker 是由阿里巴巴 Tongyi 实验室提出的一种统一框架,旨在实时生成音频和视频,提升人机交互体验。其创新之处在于解决了传统文本到语音及语音驱动的视频生成方法中常见的音视频不同步、风格不一致及系统复杂性等问题。OmniTalker 采用双分支扩散变换器架构,能够在保持高效的同时实现高保真的音视频输出。其实时推理速度可达每秒 25 帧,适用于各种交互式视频聊天应用,提升了用户体验。

视频生成

291.7K

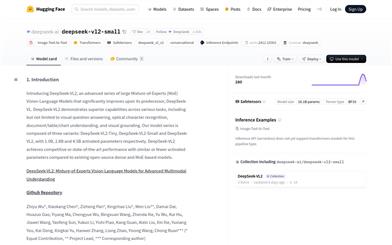

Deepseek VL2 Small

DeepSeek-VL2是一系列先进的大型混合专家(MoE)视觉语言模型,相较于前代DeepSeek-VL有显著提升。该模型系列在视觉问答、光学字符识别、文档/表格/图表理解以及视觉定位等多种任务上展现出卓越的能力。DeepSeek-VL2由三种变体组成:DeepSeek-VL2-Tiny、DeepSeek-VL2-Small和DeepSeek-VL2,分别拥有10亿、28亿和45亿激活参数。DeepSeek-VL2在激活参数相似或更少的情况下,与现有的开源密集型和基于MoE的模型相比,达到了竞争性或最先进的性能。

AI模型

56.0K

Mmaudio

MMAudio是一种多模态联合训练技术,旨在高质量的视频到音频合成。该技术能够根据视频和文本输入生成同步音频,适用于各种应用场景,如影视制作、游戏开发等。其重要性在于提升了音频生成的效率和质量,适合需要音频合成的创作者和开发者使用。

视频生成

60.2K

Internvit 300M 448px V2 5

InternViT-300M-448px-V2_5是一个基于InternViT-300M-448px的增强版本,通过采用ViT增量学习与NTP损失(Stage 1.5),提升了视觉编码器提取视觉特征的能力,尤其是在大规模网络数据集中代表性不足的领域,如多语言OCR数据和数学图表等。该模型是InternViT 2.5系列的一部分,保留了与前代相同的“ViT-MLP-LLM”模型架构,并集成了新的增量预训练的InternViT与各种预训练的LLMs,如InternLM 2.5和Qwen 2.5,使用随机初始化的MLP投影器。

AI模型

60.4K

Florence VL

Florence-VL是一个视觉语言模型,通过引入生成式视觉编码器和深度广度融合技术,增强了模型对视觉和语言信息的处理能力。该技术的重要性在于其能够提升机器对图像和文本的理解,进而在多模态任务中取得更好的效果。Florence-VL基于LLaVA项目进行开发,提供了预训练和微调的代码、模型检查点和演示。

AI模型

52.7K

Llava O1

LLaVA-o1是北京大学元组团队开发的一个视觉语言模型,它能够进行自发的、系统的推理,类似于GPT-o1。该模型在六个具有挑战性的多模态基准测试中超越了其他模型,包括Gemini-1.5-pro、GPT-4o-mini和Llama-3.2-90B-Vision-Instruct。LLaVA-o1通过逐步推理解决问题,展示了其在视觉语言模型中的独特优势。

逐步推理

49.4K

Ppllava

PPLLaVA是一个高效的视频大型语言模型,它结合了细粒度视觉提示对齐、用户指令的卷积风格池化的视觉令牌压缩以及CLIP上下文扩展。该模型在VideoMME、MVBench、VideoChatGPT Bench和VideoQA Bench等数据集上建立了新的最先进结果,仅使用1024个视觉令牌,吞吐量提高了8倍。

视频生成

50.2K

Agent S

Agent S是一个开放的代理框架,旨在通过图形用户界面(GUI)实现与计算机的自主交互,通过自动化复杂多步骤任务来转变人机交互。它引入了经验增强的分层规划方法,利用在线网络知识和叙事记忆,从过去的交互中提取高级经验,将复杂任务分解为可管理的子任务,并使用情景记忆进行逐步指导,Agent S不断优化其行动并从经验中学习,实现适应性强且有效的任务规划。Agent S在OSWorld基准测试中的表现超过了基线9.37%的成功率(相对提高了83.6%),并在WindowsAgentArena基准测试中展示了广泛的通用性。

智能体

58.2K

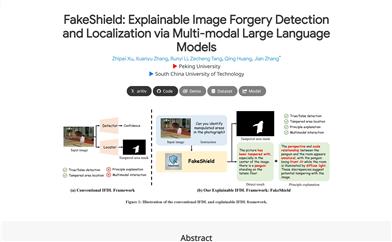

Fakeshield

FakeShield是一个多模态框架,旨在解决图像检测和定位(IFDL)领域中的两个主要挑战:检测原理的黑箱性和在不同篡改方法间的有限泛化能力。FakeShield通过利用GPT-4o增强现有的IFDL数据集,创建了多模态篡改描述数据集(MMTD-Set),用于训练FakeShield的篡改分析能力。该框架包括领域标签引导的可解释检测模块(DTE-FDM)和定位模块(MFLM),能够处理各种类型的篡改检测解释,并实现由详细文本描述引导的定位。FakeShield在检测准确性和F1分数上优于其他方法,提供了一个可解释且优越的解决方案。

图片编辑

59.9K

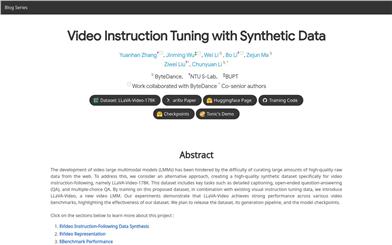

Llava Video

LLaVA-Video是一个专注于视频指令调优的大型多模态模型(LMMs),通过创建高质量的合成数据集LLaVA-Video-178K来解决从网络获取大量高质量原始数据的难题。该数据集包括详细的视频描述、开放式问答和多项选择问答等任务,旨在提高视频语言模型的理解和推理能力。LLaVA-Video模型在多个视频基准测试中表现出色,证明了其数据集的有效性。

AI模型

57.4K

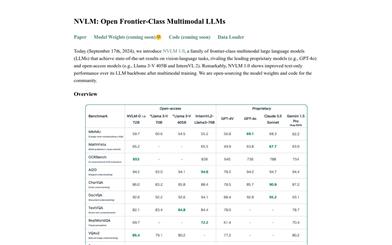

NVLM

NVLM 1.0是一系列前沿级的多模态大型语言模型(LLMs),在视觉-语言任务上取得了与领先专有模型和开放访问模型相媲美的先进成果。值得注意的是,NVLM 1.0在多模态训练后,其文本性能甚至超过了其LLM主干模型。我们为社区开源了模型权重和代码。

AI模型

48.9K

Longllava

LongLLaVA是一个多模态大型语言模型,通过混合架构高效扩展至1000图像,旨在提升图像处理和理解能力。该模型通过创新的架构设计,实现了在大规模图像数据上的有效学习和推理,对于图像识别、分类和分析等领域具有重要意义。

AI模型

49.1K

EAGLE

EAGLE是一个面向视觉中心的高分辨率多模态大型语言模型(LLM)系列,通过混合视觉编码器和不同输入分辨率来加强多模态LLM的感知能力。该模型包含基于通道连接的'CLIP+X'融合,适用于具有不同架构(ViT/ConvNets)和知识(检测/分割/OCR/SSL)的视觉专家。EAGLE模型家族支持超过1K的输入分辨率,并在多模态LLM基准测试中取得了优异的成绩,特别是在对分辨率敏感的任务上,如光学字符识别和文档理解。

AI模型

62.1K

Slowfast LLaVA

SlowFast-LLaVA是一个无需训练的多模态大型语言模型,专为视频理解和推理设计。它无需在任何数据上进行微调,就能在多种视频问答任务和基准测试中达到与最先进视频大型语言模型相当甚至更好的性能。

AI模型

57.7K

Llama3 S V0.2

Llama3-s v0.2 是 Homebrew Computer Company 开发的多模态检查点,专注于提升语音理解能力。该模型通过早期融合语义标记的方式,利用社区反馈进行改进,以简化模型结构,提高压缩效率,并实现一致的语音特征提取。Llama3-s v0.2 在多个语音理解基准测试中表现稳定,并提供了实时演示,允许用户亲自体验其功能。尽管模型仍在早期开发阶段,存在一些限制,如对音频压缩敏感、无法处理超过10秒的音频等,但团队计划在未来更新中解决这些问题。

语音识别

55.2K

Llama3 S

llama3-s是一个开放的、正在进行中的研究实验,旨在将基于文本的大型语言模型(LLM)扩展到具有原生“听力”能力。该项目使用Meta的Chameleon论文启发的技术,专注于令牌传递性,将声音令牌扩展到LLM的词汇表中,未来可能扩展到各种输入类型。作为一个开源科学实验,代码库和数据集都是公开的。

AI模型

50.0K

MAVIS

MAVIS是一个针对多模态大型语言模型(MLLMs)的数学视觉指令调优模型,主要通过改进视觉编码数学图表、图表-语言对齐和数学推理技能来增强MLLMs在视觉数学问题解决方面的能力。该模型包括两个新策划的数据集、一个数学视觉编码器和数学MLLM,通过三阶段训练范式在MathVerse基准测试中取得领先性能。

AI模型

58.0K

Longva

LongVA是一个能够处理超过2000帧或超过200K视觉标记的长上下文转换模型。它在Video-MME中的表现在7B模型中处于领先地位。该模型基于CUDA 11.8和A100-SXM-80G进行了测试,并且可以通过Hugging Face平台进行快速启动和使用。

AI模型

53.0K

MG LLaVA

MG-LLaVA是一个增强模型视觉处理能力的机器学习语言模型(MLLM),通过整合多粒度视觉流程,包括低分辨率、高分辨率和以对象为中心的特征。提出了一个额外的高分辨率视觉编码器来捕捉细节,并通过Conv-Gate融合网络与基础视觉特征融合。此外,通过离线检测器识别的边界框整合对象级特征,以进一步细化模型的对象识别能力。MG-LLaVA仅在公开可用的多模态数据上通过指令调优进行训练,展现出卓越的感知技能。

AI模型

48.6K

国外精选

4M

4M是一个用于训练多模态和多任务模型的框架,能够处理多种视觉任务,并且能够进行多模态条件生成。该模型通过实验分析展示了其在视觉任务上的通用性和可扩展性,为多模态学习在视觉和其他领域的进一步探索奠定了基础。

模型训练与部署

49.1K

Stable Diffusion 3 免费在线

Stable Diffusion 3是由Stability AI开发的最新文本生成图像模型,具有显著进步的图像保真度、多主体处理和文本匹配能力。利用多模态扩散变换器(MMDiT)架构,提供单独的图像和语言表示,支持API、下载和在线平台访问,适用于各种应用场景。

图片生成

75.1K

Videollama2 7B Base

VideoLLaMA2-7B-Base 是由 DAMO-NLP-SG 开发的大型视频语言模型,专注于视频内容的理解与生成。该模型在视觉问答和视频字幕生成方面展现出卓越的性能,通过先进的空间时间建模和音频理解能力,为用户提供了一种新的视频内容分析工具。它基于 Transformer 架构,能够处理多模态数据,结合文本和视觉信息,生成准确且富有洞察力的输出。

AI视频生成

81.1K

Emo Visual Data

emo-visual-data 是一个公开的表情包视觉标注数据集,它通过使用 glm-4v 和 step-free-api 项目完成的视觉标注,收集了5329个表情包。这个数据集可以用于训练和测试多模态大模型,对于理解图像内容和文本描述之间的关系具有重要意义。

AI图像检测识别

64.9K

Llama3v

llama3v是一个基于Llama3 8B和siglip-so400m的SOTA(State of the Art,即最先进技术)视觉模型。它是一个开源的VLLM(视觉语言多模态学习模型),在Huggingface上提供模型权重,支持快速本地推理,并发布了推理代码。该模型结合了图像识别和文本生成,通过添加投影层将图像特征映射到LLaMA嵌入空间,以提高模型对图像的理解能力。

AI模型

68.4K

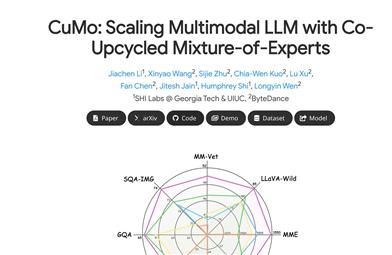

Cumo

CuMo是一种多模态大型语言模型(LLMs)的扩展架构,它通过在视觉编码器和MLP连接器中融入稀疏的Top-K门控专家混合(MoE)块,提高了模型的可扩展性,同时在推理时几乎不增加激活参数。CuMo在预训练MLP块后,初始化MoE块中的每个专家,并在视觉指令调整阶段使用辅助损失以确保专家的均衡负载。CuMo在各种VQA和视觉指令遵循基准测试中超越了其他同类模型,且完全基于开源数据集进行训练。

AI模型

54.6K

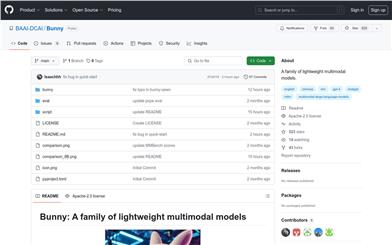

Bunny

Bunny 是一系列轻量级但功能强大的多模态模型,提供多种即插即用的视图编码器和语言主干网络。通过从更广泛的数据源进行精选选择,构建更丰富的训练数据,以补偿模型尺寸的减小。Bunny-v1.0-3B 模型在性能上超越了同类大小甚至更大的 MLLMs(7B)模型,并与 13B 模型性能相当。

AI模型

57.7K

优质新品

Llava Llama 3 8b V1 1

llava-llama-3-8b-v1_1是一个由XTuner优化的LLaVA模型,它基于meta-llama/Meta-Llama-3-8B-Instruct和CLIP-ViT-Large-patch14-336,并通过ShareGPT4V-PT和InternVL-SFT进行了微调。该模型专为图像和文本的结合处理而设计,具有强大的多模态学习能力,适用于各种下游部署和评估工具包。

AI模型

70.7K

Mygo

MyGO是一个用于多模态知识图谱补全的工具,它通过将离散模态信息作为细粒度的标记来处理,以提高补全的准确性。MyGO利用transformers库对文本标记进行嵌入,进而在多模态数据集上进行训练和评估。它支持自定义数据集,并且提供了训练脚本以复现实验结果。

AI数据挖掘

77.6K

Stable Diffusion 3 API

Stable Diffusion 3是一款先进的文本到图像生成系统,它在排版和提示遵循方面与DALL-E 3和Midjourney v6等顶尖系统相匹敌或更优。该系统采用新的多模态扩散变换器(MMDiT)架构,使用不同的权重集来改善图像和语言的表示,从而提高文本理解和拼写能力。Stable Diffusion 3 API现已在Stability AI开发者平台上线,与Fireworks AI合作提供快速可靠的API服务,并承诺在不久的将来通过Stability AI会员资格开放模型权重以供自托管。

AI图像生成

303.6K

MATHVERSE

MATHVERSE项目旨在评估多模态大型语言模型处理和理解视觉数学问题的能力,特别是如何解析和理解问题中的图表信息。

AI模型

57.7K

- 1

- 2

精选AI产品推荐

中文精选

Nocode

NoCode 是一款无需编程经验的平台,允许用户通过自然语言描述创意并快速生成应用,旨在降低开发门槛,让更多人能实现他们的创意。该平台提供实时预览和一键部署功能,非常适合非技术背景的用户,帮助他们将想法转化为现实。

开发平台

97.7K

优质新品

Listenhub

ListenHub 是一款轻量级的 AI 播客生成工具,支持中文和英语,基于前沿 AI 技术,能够快速生成用户感兴趣的播客内容。其主要优点包括自然对话和超真实人声效果,使得用户能够随时随地享受高品质的听觉体验。ListenHub 不仅提升了内容生成的速度,还兼容移动端,便于用户在不同场合使用。产品定位为高效的信息获取工具,适合广泛的听众需求。

音频生成

81.1K

国外精选

Lovart

Lovart 是一款革命性的 AI 设计代理,能够将创意提示转化为艺术作品,支持从故事板到品牌视觉的多种设计需求。其重要性在于打破传统设计流程,节省时间并提升创意灵感。Lovart 当前处于测试阶段,用户可加入等候名单,随时体验设计的乐趣。

AI设计工具

100.7K

Fastvlm

FastVLM 是一种高效的视觉编码模型,专为视觉语言模型设计。它通过创新的 FastViTHD 混合视觉编码器,减少了高分辨率图像的编码时间和输出的 token 数量,使得模型在速度和精度上表现出色。FastVLM 的主要定位是为开发者提供强大的视觉语言处理能力,适用于各种应用场景,尤其在需要快速响应的移动设备上表现优异。

AI模型

83.4K

国外精选

Smart PDFs

Smart PDFs 是一个在线工具,利用 AI 技术快速分析 PDF 文档,并生成简明扼要的总结。它适合需要快速获取文档要点的用户,如学生、研究人员和商务人士。该工具使用 Llama 3.3 模型,支持多种语言,是提高工作效率的理想选择,完全免费使用。

文章摘要

51.3K

Keysync

KeySync 是一个针对高分辨率视频的无泄漏唇同步框架。它解决了传统唇同步技术中的时间一致性问题,同时通过巧妙的遮罩策略处理表情泄漏和面部遮挡。KeySync 的优越性体现在其在唇重建和跨同步方面的先进成果,适用于自动配音等实际应用场景。

视频编辑

78.9K

Anyvoice

AnyVoice是一款领先的AI声音生成器,采用先进的深度学习模型,将文本转换为与人类无法区分的自然语音。其主要优点包括超真实的声音效果、多语言支持、快速生成能力以及语音定制功能。该产品适用于多种场景,如内容创作、教育、商业和娱乐制作等,旨在为用户提供高效、便捷的语音生成解决方案。目前产品提供免费试用,适合不同层次的用户。

音频生成

651.1K

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M